科技进步推动产品创新,给各行各业的设计师们带来了前所未有的挑战,这一点在汽车行业尤为明显。汽车厂商正努力将已实现 ADAS 功能的 L2 自动驾驶技术升级到 L3 和 L4,并最终能在自动驾驶领域,将基于 AI 的系统发展到 SAE 6 级水平。L3 级乘用车已在全球多个地区上路行驶,L4 级自动驾驶出租车目前也在旧金山等城市街道上进行广泛试验(在有些地区已投入商业使用)。但是,在这些车辆大规模投入市场之前,仍存在许多商业、物流和监管方面的挑战。

汽车厂商面临的挑战之一是要弥合两种情况之间的差距:一边是于少数技术实例的概念验证,另一边是将概念转化成为稳健、可重复和实用的大规模制造和部署。后者要求设计稳定、安全、可靠,并且定价合理。

在进行概念验证时,可以通过不同的途径实现目标。“自上而下”的方法是在车辆中集成尽可能多的硬件、传感器和软件,然后通过实现融合、降低复杂性,达到性能、成本和重量目标。相反,“自下而上”的方法则更有条理,汽车厂商先完成一个级别的自动驾驶设计,然后再收集数据并克服必要的挑战,达到下一个级别。后一种方法越来越受到大型主机厂的青睐。

设计过渡从L2到L3到L4逐步提升

汽车要提供先进的 ADAS 系统,并最终实现自动驾驶,必须感知周围环境,然后根据 “看到的内容”采取行动。车辆对环境的认知越准确,就能做出越好的决策,行车也越安全。因此,设计自动驾驶汽车时,首先要确定部署在车辆周围的传感器数量和类型。在环境传感方面,有三种常用技术:图像传感器即摄像头、毫米波雷达和激光雷达,三者各有利弊。

在上述的三种传感器中,很明显,摄像头和激光雷达的算法处理已经普遍在中央域控了,而目前市场上的各类毫米波雷达,通常还是前端处理,生成目标以后,再送到中央域控,而并非中央集中处理。我们将在本文中着重介绍对于 4D 成像毫米波雷达进行中央集中处理的必要性和安霸 CV3 在这方面的技术优势。

一旦确定了车辆对传感器的需求,就要做出一系列关键决定,包括设计系统架构和选择配备合适的处理器。这就需要从根本上考虑是集中处理传感器数据,还是在前端处理传感器数据。

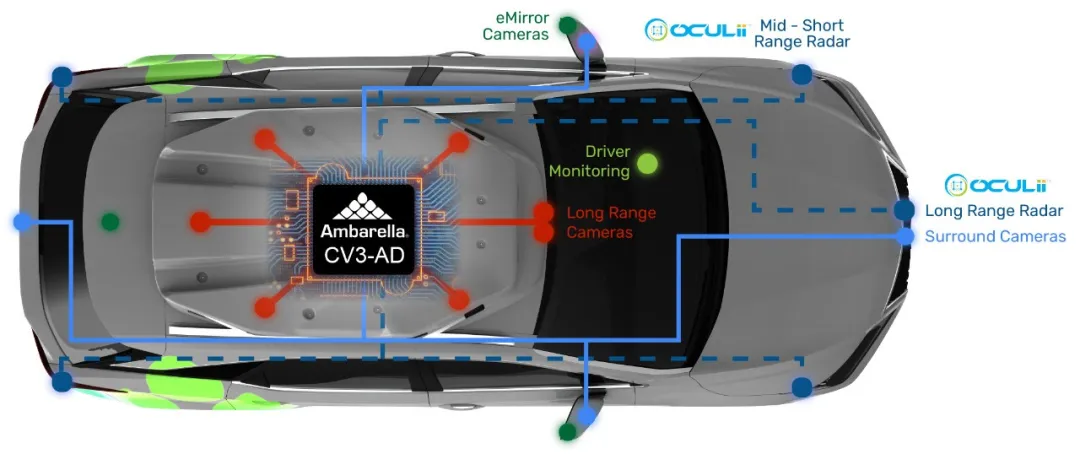

图1 确定传感器架构是自动驾驶汽车取得成功的前提

传统 3D 雷达技术虽然成本较低,但在感知能力存在着一些不足。通常毫米波雷达做前端计算,生成目标以后,在域控里和来自摄像头的感知结果做后融合。这种方式因为在前端的信息损失,不仅使得 3D 雷达的作用被大大削弱,并且在视觉感知高度发展的今天,传统 3D 雷达有靠边站的趋势。

随着毫米波雷达技术的演进,我们看到 4D 成像毫米波雷达的技术指标比起传统 3D 毫米波雷达有了大幅的改进,包括多了一个高度维度,看得更远,点云更密集,有更好的角分辨率,对静止目标检测更可靠,更低的误检和漏检等。4D 成像毫米波雷达之所以有这些技术优势,往往来自于更复杂的调制技术,和更复杂的点云算法,跟踪算法等。因而 4D 成像毫米波雷达往往需要专门的雷达处理芯片才能达到所需的高性能。目前市场上已经存在一些在前端雷达模块中添加雷达 DSP 或 FPGA 来进行前端计算的设计。虽然这些前端计算的 4D 成像毫米波雷达有些展现出比传统 3D 雷达更好的性能,成本较高,不利于广泛应用。

而在集中式处理方法下,由于所有传感器的原始数据都在一个中心点进行合并,数据进行融合时不会丢失关键信息。由于不在前端进行处理,毫米波雷达传感器模块大大简化,从而缩小了尺寸,降低了功耗和成本。此外,大多数毫米波雷达都位于车辆保险杠后侧,最大限度地降低事故后的维修费用。

集中式处理方法还能让研发人员灵活地实时调整毫米波雷达数据和摄像头数据的相对重要性,在各种环境天气和驾驶条件下提供最佳的环境感知能力。举例来说,在恶劣天气条件下,沿高速公路行驶时,毫米波雷达数据将发挥更大优势;而在拥挤的城市中缓慢行驶时,摄像头在识别车道线,读取道路标志和场景感知,识别危险方面将发挥更重要的作用;而激光雷达对于一般障碍物检测和夜晚 AEB 方面更有特色,动态配置传感器套件可以节省处理器资源,降低能耗,同时提高环境感知能力和安全性。

前端处理与中央域控处理4D成像毫米波雷达的比较

前端处理成像雷达

1. 算力受限,更大的算力带来更大的功耗,影响雷达数据密度和灵敏度

2. 固定的计算模式,必须为最恶劣的场景考虑,虽然在常见场景用可能用不到

3. 更高的雷达前端成本, 因为雷达的数据处理放在前端节点,增加成本

4. 传感器融合过于简单,只能用目标级融合

中央处理的域控雷达

1. 为更强大更高效的集中处理,雷达可以得到更好的角分辨率,数据密度和灵敏度

2. 算力可以根据场景,在几个雷达之间动态调整,以达到更好的算力利用率,提升感知结果

3. 更低的雷达前端成本,因为雷达的前端只有传感器,没有计算单元

4. 可以做4D雷达数据和摄像头数据深度的深度融合

SoC 选择

随着电动汽车的普及,如何节约电能并最大限度地提高“每次充电的续航里程 ”成为每个车辆零部件的关键考虑因素。节能是集中式 AI 域控芯片的优势。有些多芯片中央域控消耗大量电能,因而缩短了车辆的续航里程。如果 SoC 产生的热量过大,需要设计主动冷却方案,甚至某些架构需要液体冷却,这就大大增加了汽车的尺寸、成本和重量,从而降低了电池续航能力。

AI 智驾软件正迅速成为系统的关键要素,AI 的实现方式对 SoC 的选择,以及开发系统所花费的时间和资金投入都有重大影响。关键是如何以最小的工作量和能源,运行最新的神经网络算法,但又不牺牲精度。这不仅需要仔细考虑硬件该如何实现神经网络,还要考虑为中间件、设备驱动程序和 AI 工具提供支持,缩短开发时间并降低风险。

车辆出厂后,无论是解决某个问题,还是新增功能,软件都需要持续更新。基于单个域控制器的集中式架构简化了这一过程,OTA 升级的实现,解决了目前需要单独更新每个前端模块软件的难题(更加昂贵和复杂)。这种 OTA 方法也意味着系统网络安全是设计过程中需要解决的另一个重要领域。

SoC 的选择影响着设计过程的各个方面,包括整辆自动驾驶汽车的效能。为了赋能大型主机厂更快落地极具性价比的智驾产品,综合性地考虑到客户需求,为客户带来主攻 L3/L4 旗舰智驾系统的大算力中央域控 AI 芯片 CV3-AD685,该芯片可实现 4D 成像毫米波雷达原始数据的集中式处理和深度融合。

为什么安霸傲酷雷达可以做到成本更低呢?

这是因为,传统 4D 成像毫米波雷达使用固定的调制技术,需要根据调制方案对性能进行折中。不过,采用基于 AI 的实时动态波形的新兴 4D 成像毫米波雷达设计正在帮助解决这一难题。将 “稀疏化阵列天线”与可动态学习并适应环境的 AI 算法(即虚拟孔径成像(VAI)技术)相结合,从根本上打破了调制带来的性能折中,可将 4D 成像毫米波雷达的分辨率提高至 100 倍。这大幅度提高了角度分辨率,以及系统性能和精确度,而天线数量也减少了一个档次,外形尺寸、功率预算、数据传输要求和成本也相应降低。

如何在 CV3 上做中央域控雷达设计呢?

CV3 支持雷达前端传感器直接传输 RAW 数据到域控,而在 CV3 上完成必要的雷达计算包括高质量点云生成,处理,跟踪等算法。CV3-AD685 上带有专用 4D 成像毫米波雷达处理硬件单元,简洁而高效地完成多个雷达同时工作时的数据处理。

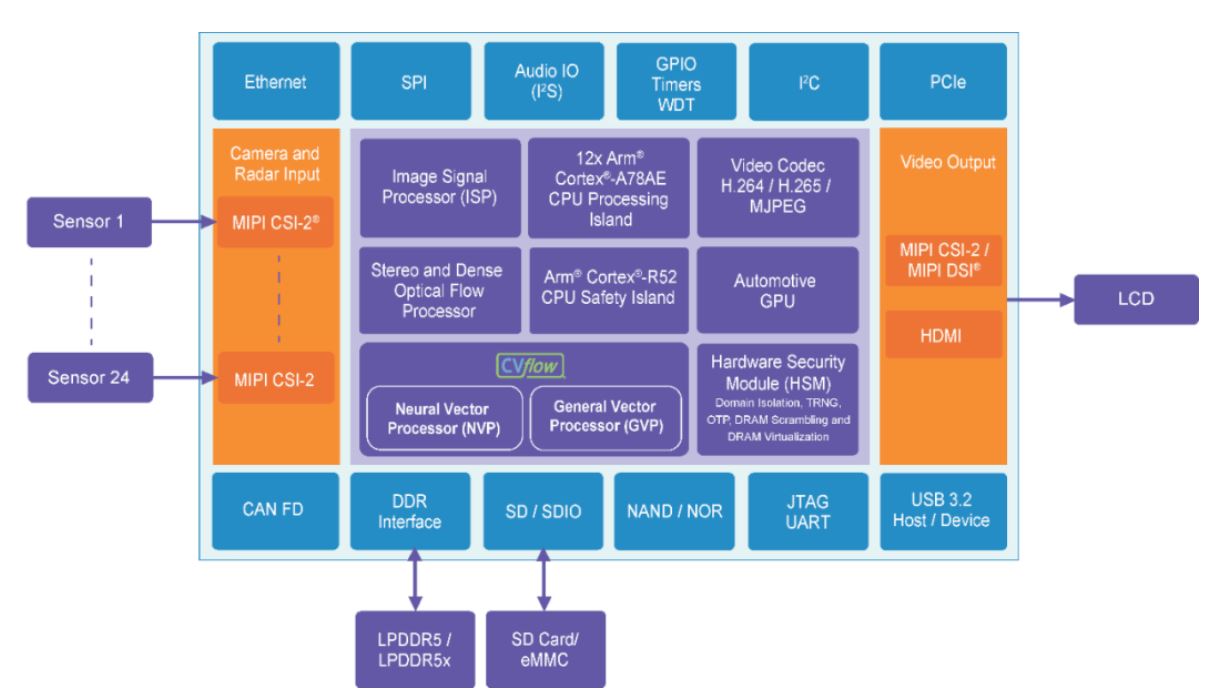

图 3 显示了一个功能强大的 SoC 框图,它是安霸的 CV3-AD685。该 SoC 专为汽车中央域控制器而设计,可高性能运行各种神经网络算法,实现完整的自动驾驶解决方案。CV3-AD685 带有专业图像信号处理单元、可使用各种传感器感知(如来自摄像头、毫米波雷达、超声波雷达和激光雷达)、执行多种传感器的深度融合,运行车辆路径预测规划控制等算法。CV3-AD 系列专为汽车智驾设计的架构与 GPU 等竞品芯片架构截然不同,GPU 一般采用更为通用的并行计算设计,以运行各种不同的应用。因而在运行智驾应用的时候,CV3 比竞品的效率更高,功耗更低。

图3 安霸 CV3-AD685 SoC 框图,该芯片专为汽车应用中的集中式AI域控而设计。

如图 3 所示,该 SoC 集成了神经网络处理器(NVP),通用矢量处理器 (GVP)(用于加速通用机器视觉算法和毫米波雷达处理)、高性能图像信号处理器(ISP) 、12 个 Arm® Cortex®-A78AE 和多个 R52 CPU,双目立体视觉和密集光流引擎、以及 GPU(用于 3D 渲染如 AVM )。CV3-AD系列的整体架构和 CV3-AD685 相同,适用于从 L2+ 到 L4 级汽车智驾系统,拥有充沛算力和安全冗余,可运行完整的自动驾驶解决方案。其 AI 性能则在高性能 GPU 的 3 倍左右,尽管性能出众,这款 SoC 的工作功耗却大幅低于竞品。因此,使用 CV3-AD685,与竞品芯片相比,在电池容量相同的情况下,电动汽车的续航里程至少可增加 30 公里。另外,在保持相同续航里程的情况下,电池成本可以大幅降低,电池重量也可以减少几公斤。

总结

近年来,智驾技术取得了质的飞跃。不同的智驾高级功能成为主流已有一段时间,随着汽车厂商不断创新突破,其他新功能也不断涌现。汽车行业现在面临的挑战是如何将目前的 L3 和 L4 级智能驾驶试验车全面投入生产。

这一进步的关键在于传感器的选择,包括车辆的结构和域控芯片的选择。使用专为集中式传感器融合设计的处理器,以及基于 AI 的创新技术(如稀疏化毫米波雷达阵列),自动驾驶汽车可以集中处理毫米波雷达数据,并将其与摄像头数据进行融合,对车辆周围动态环境做出及时反应。这种性能和灵敏度的提高可以减少对激光雷达的依赖性,进一步降低成本,并且达到更好的环境感知性能。