近日,三大存储原厂三星、SK海力士、美光纷纷发布最新一季财报。三大原厂受惠于生成式AI热潮推动,营收利润均大幅提升。并且相关厂商高带宽存储器(HBM)、 DDR5等高附加值产品的扩产计划引起市场关注。

三星Q2销售额达74.07万亿韩元, HBM、DDR5和SSD需求将保持强劲

7月31日三星电子公布了二季度财报,销售额74.07万亿韩元(约人民币3889.42亿元,下同),净利润9.64万亿韩元(约506.2亿元),同比增长471%;营业利润10.44万亿韩元(当前约548.2亿元)。其中,三星负责半导体的DS(Device Solutions)部门业绩亮眼,以6.45万亿韩元(约338.69亿元人民币)的营业利润引领了整体业绩。

图片来源:三星

对于业绩增长,三星表示在生成式AI热潮的推动下,高带宽存储器(HBM)和DDR5等高附加值产品的需求增加,公司也积极应对生成式AI服务器用高附加值产品的需求,使得业绩较上季度大幅改善。

三星电子预计2024下半年HBM、DDR5和SSD需求将保持强劲,将在下半年扩大产能以提高HBM3E销售比例。公司还将专注于高密度产品,例如基于服务器DRAM中的1b-nm 32Gb DDR5的服务器模块。对于NAND,公司计划通过加强三级单元 (TLC) SSD的供应来增加销售额,这仍然是AI需求的大部分,并将满足客户对四级单元 (QLC) 产品的需求,这些产品针对包括服务器PC和移动设备在内的所有应用进行了优化。

三星MX和网络业务第二季度的综合收入为27.38万亿韩元,营业利润为2.23万亿韩元。三星表示,由于智能手机市场的季节性趋势持续,智能手机整体市场需求环比下降,尤其是在高端市场。尽管MX业务的收入环比下降,但Galaxy S24系列在第二季度和上半年的出货量和收入均比上一代实现了两位数的同比增长。对于智能手机业务发展,三星电子称,2024年下半年智能手机的总体需求预计将同比增长,高端产品的需求增长主要得益于人工智能需求的增长以及具有创新功能的新产品的推出。

在晶圆代工业务上,三星营收有所改善,由于5nm以下技术的订单增加,AI和高性能计算 (HPC) 客户数量较上年增长了两倍。2024年,在第二代3nm GAA 技术全面量产的推动下,公司预计增长将超过市场。三星预计晶圆代工市场将整体增长,尤其是在先进节点方面。目前,三星代工业务提前向客户分发了2nm环绕栅极 (GAA) 技术的工艺开发套件 (PDK),以便在2025年实现量产。未来,三星计划继续扩大AI/HPC应用的订单,目标是到2028年将客户数量较2023年增加四倍,销售额增加九倍。

在扩产动作上,行业消息显示,为了应对人工智能(AI)热潮带动存储芯片需求提升,三星电子决定重启新平泽工厂(P5)基础建设,预计最快将于2024第三季重启建设,完工时间推估为2027年4月,不过实际投产时间可能更早。最新消息显示,该厂将率先生产NAND Flash,但在QLC NAND生产计划不明确的情况下,也有转换为DRAM的可能。

本月下旬,供应链传来消息称,三星电子的HBM3内存芯片首次通过了NVIDIA的认证,目前三星对此消息并未回复。

SK海力士业绩同比大增125%,今年的资本支出可能会比年初计划增加

7月25日,SK海力士发布了截至2024年6月30日的2024财年第二季度财务报告,二季度实现营收16.4233万亿韩元,营业利润为5.4685万亿韩元,净利润为4.12万亿韩元。二季度营业利润率为33%,净利润率为25%。

据悉,该公司此次实现了季度收入创历史新高,大幅超过在2022年第二季度实现的13.8110万亿韩元记录。营业利润也是继2018年第二季度(5.5739万亿韩元)、第三季度(6.4724万亿韩元)之后时隔6年创下了5万亿韩元水平的业绩。

图片来源:SK海力士

对于业绩增长,SK海力士表示,HBM、eSSD等适用于AI的存储器需求表现强势,并且DRAM和NAND闪存产品的整体价格持续上升,收入环比增加32%。与此同时,以高端产品为主的销售增长,再加上汇率效果,第二季度的营业利润率环比上升了10个百分点,达到了33%。

在DRAM上,SK海力士从今年3月份开始量产及供应的HBM3E和服务器DRAM等高附加值产品的销售比重有所扩大。特别是HBM的销售额环比增长80%以上,同比增长250%以上,带动了公司的业绩改善。NAND闪存的销售以eSSD和移动端产品为主增长,特别是eSSD的销售额持续保持快速增长势头,环比增长约50%。

SK海力士预测,下半年支持端侧AI的PC端和移动端新产品将会上市,其所需的高性能存储器销量也将随之增长,同时通用存储器的需求也将呈现明显的上升趋势。顺应趋势,该公司目前已向主要客户提供12层HBM3E样品,计划在第三季度开始量产,从而延续在HBM市场的领导力。

在DRAM上,SK海力士目前提供适用于服务器的最高容量256GB DDR5 DRAM,在NAND闪存方面,公司将继续扩大高容量企业级固态硬盘销售,并且将以60TB产品引领下半年市场。

今年4月,SK海力士公布将投资约38.7亿美元在美国印第安纳州建造一座先进封装厂和AI产品研发设施。近期,SK海力士表示其韩国清州M15X厂近期已正式开工,初步预计明年下半年开始量产。并且龙仁半导体集群目前正在进行用地工程,其第一座工厂也将按原计划在明年3月开工,计划在2027年5月竣工。因此,在资本支出方面,SK海力士表示今年的CAPEX(资本支出)可能会比年初计划增加。

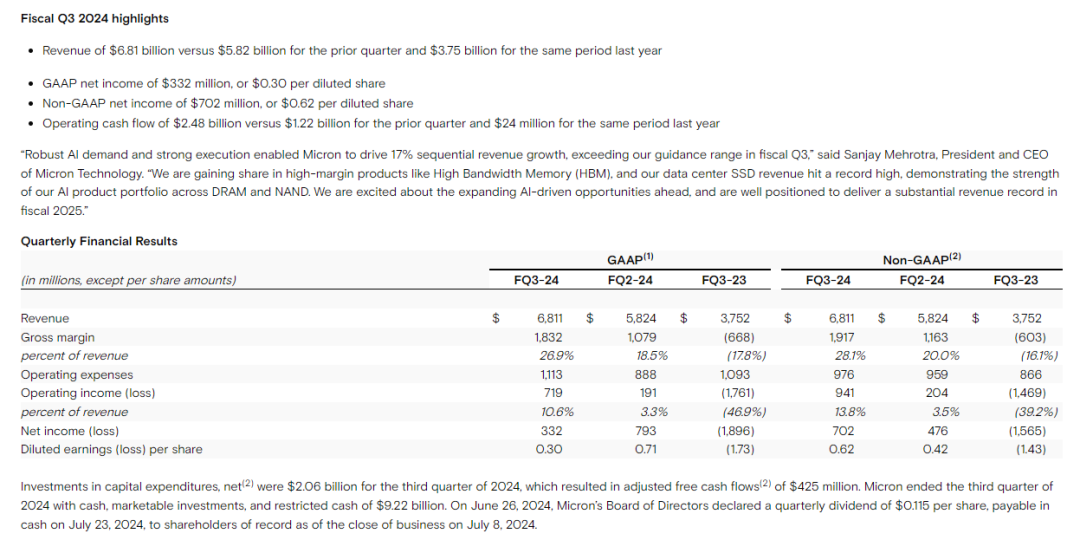

美光第三季度毛利润大增,预计HBM还将涨价

美光6月26日发布了截至5月的2024财年第三季度业绩,公司总营收68.1亿美元,较上年同期的37.5亿美元同比增长81.6%;毛利润18.3亿美元,同比增长374.2%;净利润3.32亿美元,同比增长117.5%。其中,DRAM内存贡献了71%的营收,NAND闪存则贡献了27%的收入。美光预计截止8月份的下个财季调整后营收区间为74亿至78亿美元,运营利润率为33.5%至35.5%。

图片来源:美光

美光在三季报中继续强调AI业务的驱动性,但也承认其智能手机和个人电脑市场仍然低迷。美光补充,数据中心业务环比增长了50%,未来该公司面向人工智能的产品价格可能会上涨。

目前,美光主要为AI芯片龙头英伟达提供其AI图形处理单元(GPU)上的高带宽内存芯片,双方的合作日益密切,美光在高带宽内存(HBM)业务的增长情况备受市场关注。

美光对于HBM市况十分看好。5月,美光高管在投资者会议活动上表示,美光2025年HBM内存供应谈判基本完成,已与下游客户基本敲定了2025年HBM订单的规模和价格。6月,美光宣布,预计2025自然年其HBM市占率将与美光的DRAM市占率相当,达到约为20-25%。

在第三季财报电话会议上,美光宣布该财季内其第五代HBM(HBM3E)营收已经超过1亿美元,并预计下一财年,美光的HBM年收入可能高达“数十亿美元”。

为了应对HBM市场的强劲需求,美光此前还上调了2024财年的资本支出金额,预计从75~80亿美元提升到80亿美元,主要聚焦HBM产能。行业消息显示,目前美光正在考虑将马来西亚工厂转为HBM专用生产线,扩大中国台湾台中的HBM产线。而美光在日本新广岛的工厂也将聚焦HBM生产,产能预计今年第四季提升至2.5万颗,后续将引入EUV制程(1γ、1δ),并建置全新无尘室。

随着高性能运算、人工智能等需求增长,未来HBM市场竞争将会更加剧烈,美光在HBM技术上持续精进,逐渐成长为SK海力士和三星的强大竞争对手。目前美光已经开始批量生产HBM3E,用于英伟达H200。美光还在准备12层垂直堆叠的单品36GB HBM3E芯片,将会在2025年推出。更大变化的将是HBM4,计划在2026年发布。

HBM持续供不应求,行业提出多种替代性方案

据TrendForce集邦咨询研究显示,受惠于位元需求成长、供需结构改善拉升价格,加上HBM(高带宽内存)等高附加价值产品崛起,预估DRAM(内存)及NAND Flash(闪存)产业2024年营收年增幅度将分别增加75%和77%。而2025年产业营收将持续维持成长,DRAM年增约51%、NAND Flash年增长则来到29%,营收将创历史新高,并且推动资本支出回温、带动上游原料需求,只是存储器买方成本压力将随之上升。

目前,行业消息称,由于HBM3e的TSV良率目前仅约40%至60%,且并非所有原厂都已经通过客户验证,HBM供不应求情况还将持续较长一段时间。并且受限于DRAM总产能有限,原厂更多将产能倾斜于获利更高的HBM产能,造成对DDR5和LPDDR5/5X的产能排挤效应。在当下资本支出扩大产能扩产下,该情况有所缓解。具体到价格上,HBM销售单价较传统型DRAM高出数倍,与DDR5的价差大约五倍。为了缓解成本压力,目前业界多方正在有几种有效解决的方法。

虽然HBM在性能方面与DDR5和LPDDR5/5X相比有着较大优势,但对于许多应用来说价格过于昂贵且耗电,因此包括苹果、AMD等在内的公司选择将LPDDR5X用于其带宽要求较高的应用,因为这种类型的内存为他们提供了价格、性能和功耗之间的适当平衡。

比如苹果公司多年来一直在其PC中使用LPDDR内存,至今该公司已经很好地完善了基于LPDDR5的内存子系统,其性能是竞争解决方案无法比拟的。Apple的高端台式机 — 由M2 Ultra SoC提供支持的Mac Studio和Mac Pro—使用两个512位内存接口可拥有高达800 GB/s的带宽。另外,AMD最新的Ryzen Threadripper Pro配备12通道DDR5-4800内存子系统,峰值带宽可达460.8 GB/s。

另外,AI芯片初创公司Tenstorrent也是将LPDDR内存应用于其Grayskull AI处理器的拥护者。其CTO吉姆·凯勒(Jim Keller)为了解决人工智能硬件成本高昂的问题,提出不使用HBM的想法。目前,Tenstorrent准备在今年年底出售其第二代多功能AI芯片,该公司表示,在某些领域,其能效和处理效率优于英伟达的AI GPU。据Tenstorrent称,其Galaxy系统的效率是英伟达AI服务器DGX的三倍,且成本降低了33%。

图片来源:拍信网

除了Tenstorrent外,谷歌TPU第一代设计者Jonathan Ross所创立的Groq公司也提出了相关的用其他内存替代HBM的想法。其新一代LPU在多个公开测试中,以几乎最低的价格,相比GPU推理速度翻倍,后续有三方测试结果表明,该芯片对大语言模型推理进行优化效果显著,速度相较于英伟达GPU提高了10倍。行业人士表示,LPU的工作原理与GPU截然不同。它采用了时序指令集计算机(Temporal Instruction Set Computer)架构,这意味着它无需像使用高带宽存储器(HBM)的GPU那样频繁地从内存中加载数据。Groq选择了SRAM,其速度比GPU所用的存储器快约20倍,这一特点不仅有助于避免HBM短缺的问题,还能有效降低成本。

HBM和LPDDR的行业覆盖度并不完全重合,具体而言,HBM主要面向数据中心,LPDDR主要面向边缘。LPDDR存储芯片的优势之一是其相对广泛的接口和相当快的运行速度。如典型的LPDDR5和LPDDR5X/LPDDR6T IC具有32或64位接口,支持高达9.6 GT/s的数据传输速率,这比批量生产的DDR5数据速率更好。此外,移动内存自然比客户端PC和服务器的主流DDR内存消耗更少的功率。

除了上述的替代方案外,行业希望通过创建规模优势芯片良率,以及HBM芯片架构上的优化来达到降低成本的目的,后者比如台积电不断精进其CoWoS等。

封面图片来源:拍信网