来源:本文授权转载自机器之心 ,谢谢。

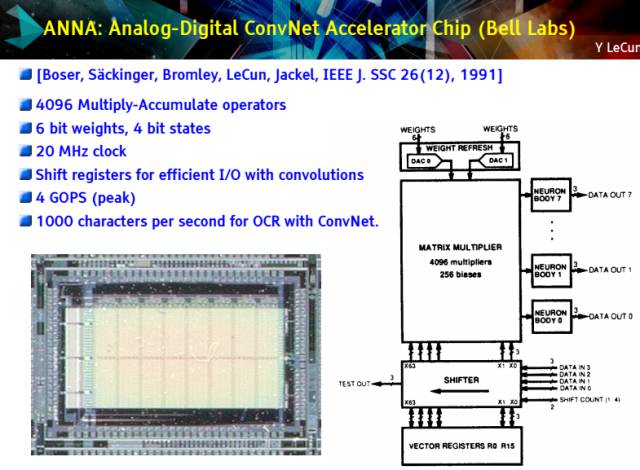

作为机器学习的领军人物,Yann LeCun(杨立昆)曾在 25 年前开发过一块名为 ANNA 的人工智能芯片。而现在,构建适用于深度学习的计算芯片已成为所有科技巨头共同的发展目标。

那是 1992 年,LeCun 还供职于贝尔实验室,这座位于纽约市郊的研发机构举世闻名。他和一群研究者们共同设计了一种适用于进行深度神经网络计算的芯片 ANNA,用于高效处理需要分析大量数据的复杂任务,但 ANNA 从未投入市场。随后的二十多年里,神经网络随着计算机性能的不断提升,开始在识别文字、人脸和语音等任务中达到甚至超越了人类水平。但人工智能还远没有达到威胁人类智能的水平,那些用于特定任务的算法,在执行其他种类任务的时候,不会产生任何有意义的结果。

尽管如此,今天的神经网络还是在重塑着所有科技公司的面貌,谷歌、Facebook、微软都在做着自己的改变。LeCun 现在已经成为 Facebook 人工智能实验室的主任。在那里,神经网络被用于识别人脸、标注图片中的事物、翻译语言甚至更多。在 25 年后,LeCun 认为市场现在非常需要像 ANNA 这样的芯片,很快,它们将大量涌现。

谷歌刚刚有了自己的人工智能芯片 TPU,这种芯片已经广泛用于谷歌的数据中心,成为其网络帝国的引擎。每台安卓手机的谷歌语音搜索指令都会经由 TPU 处理。这只是芯片业巨大变革的开始,CNBC 等媒体 4 月 20 日 的报道指出,谷歌 TPU 的开发者们正在秘密成立的创业公司 Groq 重新集结,开发类似的人工智能芯片;而传统芯片厂商,如英特尔、IBM 和高通也在做着同样的努力。

谷歌在本月初推出 TPU 时称:「它是我们的第一块机器学习芯片。」在谷歌发表的论文中,TPU 在一些任务中的处理速度可达到英伟达 K80 GPU 与英特尔 Haswell CPU 的 15-30 倍。而在功耗测试中,TPU 的效率也比 CPU 和 GPU 高 30-80 倍(当然,作为对比的芯片并不是最新产品)。

谷歌 TPU 芯片已经成为其数据中心的重要组成部分

像谷歌、Facebook 和微软这样的科技巨头当然可以把自己的神经网络任务交给常规计算机芯片来处理(如 CPU),但 CPU 是设计用来处理所有类型任务的,这种方式显得效率很低。当使用特殊设计的芯片进行处理时,神经网络任务会运行得更快,消耗更少的电力。谷歌宣称随着 TPU 的应用,它为谷歌节约的成本可以打造另外 15 个数据中心。而随着谷歌、Facebook 等公司将神经网络应用于手机和 VR 头盔,为了减少延迟,在个人设备上的小型智能芯片也变得迫在眉睫了。「在更加高效的专业芯片方面,市场还有很大一片空白,」LeCun 说道。

技术巨头

在收购了初创公司 Nervana 之后,英特尔正在打造一款机器学习专用芯片。IBM 也是,它正在创建一个可以映射(mirror)神经网络设计的硬件架构。最近,高通已经开始制造执行神经网络的专用芯片,这条消息来自 LeCun,因为 Facebook 正帮助高通开发机器学习相关技术所以他对高通的计划很了解;高通技术部副主席 Jeff Gehlhaar 证实了该计划,他说:「在原型机研发方面,我们还有很多路要走。」

高通一直在和 Yann LeCun 在 Facebook AI 研究机构的团队保持合作,共同开发用于实时推理的新型芯片。高通最近宣布计划花费 470 亿美元收购荷兰汽车芯片公司 NXP。在收购宣布之前,NXP 就在致力于解决深度学习和计算机视觉难题,看来高通希望借助收购加强自动驾驶系统的开发。

自动驾驶是深度学习与人工智能发挥作用的主要领域之一。除此之前,内置芯片有很多其他选择以与真实世界交互,比如手机和虚拟现实耳机。当前技术发展飞快,我们很快就会看到其他实际应用的出现。

很多公司想把握住这一蓝海机遇,比如传统芯片巨头英特尔和 IBM。Big Blue 努力在其 Minsky 人工智能服务器中把 RISC 芯片和英伟达 GPU 结合起来的同时,其研究团队也在探索其他芯片架构。IBM Almaden 实验室探讨了其类脑芯片 TrueNorth 的性能,该芯片具备 100 万个神经元和 2.56 亿个突触。IBM 称在若干个视觉和语音数据集中,TrueNorth 给出了接近当前最高分类精确度的深度网络。

IBM 研究院类脑计算首席科学家 Dharmendra Modha 在其博文中说道:「类脑计算的目标是在不断逼近时间、空间和能量的根本限制的情况下,给出可扩展的神经网络基础(substrate)。」

作为芯片领域最大的玩家,英特尔并没有止步不前,它也正在根据下一代人工智能工作需求开发自己的芯片架构。去年,英特尔宣布其第一个人工智能专用硬件 Lake Crest(其技术基于 Nervana)将在 2017 年上半年推出,并在稍后接着推出 Knights Mill,它是 Xeon Phi 联合处理器架构的下一个迭代。

英伟达已成为人工智能硬件领域的主力军之一。在谷歌、Facebook 等公司能够使用神经网络翻译语言之前,他们必须首先用特殊任务训练神经网络,给神经网络输入现有的大量翻译数据集。英伟达制造了可以加快这一训练进程的 GPU 芯片。LeCun 说,在训练方面,GPU 通常考虑的是市场,尤其是英伟达 GPU。但是 Farabet 的出现也许表明,英伟达正和高通一样,也在探索一旦接受训练就可运行神经网络的芯片。

GPU 最初的设计初衷并非人工智能,而是图形绘制。但是大约 5 年前,谷歌、Facebook 等公司开始使用 GPU 训练神经网络,仅仅因为 GPU 是现有的最佳选择。LeCun 相信 GPU 可以持续发挥这一作用,他说,现在程序员和公司对 GPU 相当熟悉,他们具备使用 GPU 的所有工具;GPU 很难被替代,因为替代它需要换掉全部(整个生态系统)。但是他也认为将会出现一种新型芯片,从数据中心和消费设备两个方面,极大地改变大型公司运行神经网络的方式,从而,从手机到智能割草机再到真空吸尘器的一切也都将会改变。

正如谷歌 TPU 展示的,专用 AI 芯片可以将数据中心的运行效率提高到一个新的层次,特别是对于那些需要进行图像识别的服务器。在执行神经网络任务时,它们消耗更少的电力,发热更小。「如果你不想让一个池塘沸腾,你就需要特殊设计的硬件,」LeCun 说。

与此同时,随着 VR 和 AR 技术的发展,手机与头戴设备也需要同样的芯片。Facebook 上周曾展示了它们的新型增强现实工具,而这种设备需要神经网络来对周围环境进行识别。但增强现实系统的任务不能基于数据中心——传送数据需要时间,延迟会破坏用户体验。正如 Facebook 首席技术官 Mike Schroepfer 所解释的,Facebook 目前正在使用 GPU 和另一种被称为数字信号芯片的设备处理这些任务。但从长远来看,这些设备必须使用全新类型的芯片。

现在,需求已经出现,芯片公司正在争相占领新的市场。

今天是《半导体行业观察》为您分享的第1260期内容,欢迎关注。

【关于转载】:转载仅限全文转载并完整保留文章标题及内容,不得删改、添加内容绕开原创保护,且文章开头必须注明:转自“半导体行业观察icbank”微信公众号。谢谢合作!

【关于征稿】:欢迎半导体精英投稿(包括翻译、整理),一经录用将署名刊登,红包重谢!签约成为专栏专家更有千元稿费!来稿邮件请在标题标明“投稿”,并在稿件中注明姓名、电话、单位和职务。欢迎添加我的个人微信号 MooreRen001或发邮件到 jyzhang@moore.ren

【关于征稿】:欢迎半导体精英投稿(包括翻译、整理),一经录用将署名刊登,红包重谢!签约成为专栏专家更有千元稿费!来稿邮件请在标题标明“投稿”,并在稿件中注明姓名、电话、单位和职务。欢迎添加我的个人微信号 MooreRen001或发邮件到 jyzhang@moore.ren