同 CPU、内存以及 I/O 一样,也是 系统最核心的功能。是一种把不同计算机或设备连接到一起的技术,它本质上是一种进程间通信方式,特别是跨系统的进程间通信,必须要通过网络才能进行。

本文引用地址:网络模型

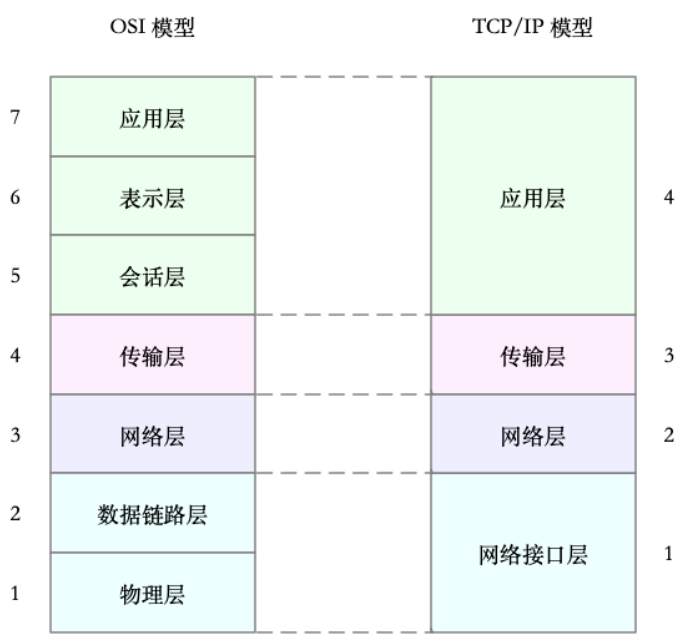

多台服务器通过网卡、交换机、路由器等网络设备连接到一起,构成了相互连接的网络。由于网络设备的异构性和网络协议的复杂性,国际标准化组织定义了一个七层的 OSI 网络模型,但是这个模型过于复杂,实际工作中的事实标准,是更为实用的 TCP/IP 模型。

在计算机网络时代初期,各大厂商推出了不同的网络架构和标准,为统一标准,国际标准化组织 ISO 推出了统一的 OSI 开放式系统互联通信参考模型(Open System Interconnection Reference Model)。

网络分层解决了网络复杂的问题,在网络中传输数据中,我们对不同设备之间的传输数据的格式,需要定义一个数据标准,所以就有了网络协议。

为了解决网络互联中异构设备的兼容性问题,并解耦复杂的网络包处理流程,OSI 模型把网络互联的框架分为应用层、表示层、会话层、传输层、网络层、数据链路层以及物理层等七层,每个层负责不同的功能。其中,

• 应用层:负责为应用程序提供统一的接口。

• 表示层:负责把数据转换成兼容接收系统的格式。

• 会话层:负责维护计算机之间的通信连接。

• 传输层:负责为数据加上传输表头,形成数据包。

• 网络层:负责数据的路由和转发。

• 数据链路层:负责 MAC 寻址、错误侦测和改错。

• 物理层:负责在物理网络中传输数据帧。

但是 OSI 模型还是太复杂了,也没能提供一个可实现的方法。所以,在 中,实际上使用的是另一个更实用的四层模型,即 TCP/IP 网络模型。

TCP/IP 模型,把网络互联的框架分为应用层、传输层、网络层、网络接口层等四层,其中,

• 应用层:负责向用户提供一组应用程序,比如 HTTP、FTP、DNS 等。

• 传输层:负责端到端的通信,比如 TCP、UDP 等。

• 网络层:负责网络包的封装、寻址和路由,比如 IP、ICMP 等。

• 网络接口层:负责网络包在物理网络中的传输,比如 MAC 寻址、错误侦测以及通过网卡传输网络帧等。

TCP/IP 与 OSI 模型的关系如下图:

虽说 实际按照 TCP/IP 模型,实现了网络协议栈,但在平时的学习交流中,我们习惯上还是用 OSI 七层模型来描述。

比如,说到七层和四层负载均衡,对应的分别是 OSI 模型中的应用层和传输层(而它们对应到 TCP/IP 模型中,实际上是四层和三层)。

Linux网络栈

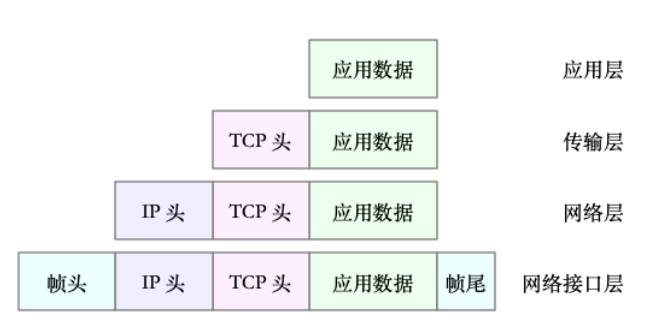

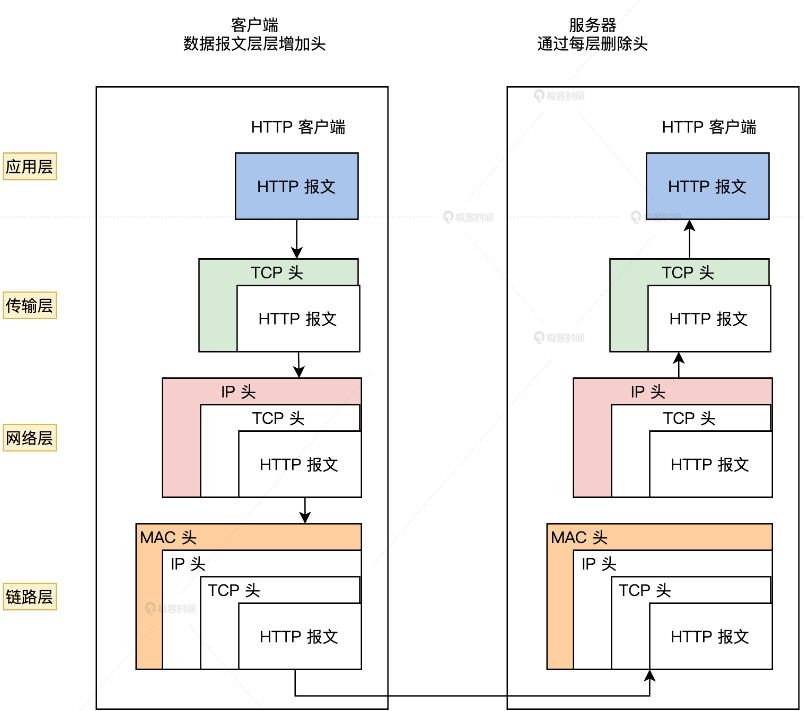

有了 TCP/IP 模型后,在进行网络传输时,数据包就会按照协议栈,对上一层发来的数据进行逐层处理;然后封装上该层的协议头,再发送给下一层。

当然,网络包在每一层的处理逻辑,都取决于各层采用的网络协议。比如在应用层,一个提供 REST API 的应用,可以使用 HTTP 协议,把它需要传输的 JSON 数据封装到 HTTP 协议中,然后向下传递给 TCP 层。

而封装做的事情就很简单了,只是在原来的负载前后,增加固定格式的元数据,原始的负载数据并不会被修改。

比如,以通过 TCP 协议通信的网络包为例,通过下面这张图,我们可以看到,应用程序数据在每个层的封装格式。

其中:

• 传输层在应用程序数据前面增加了 TCP 头;

• 网络层在 TCP 数据包前增加了 IP 头;

• 而网络接口层,又在 IP 数据包前后分别增加了帧头和帧尾。

这些新增的头部和尾部,增加了网络包的大小,但我们都知道,物理链路中并不能传输任意大小的数据包。

网络接口配置的最大传输单元(MTU),就规定了最大的 IP 包大小。在我们最常用的以太网中,MTU 默认值是 1500bytes(这也是 Linux 的默认值)。

在Linux操作系统中执行 ifconfig 可以查看到每个网卡的mtu值,有1450、1500等不同的值。

[root@dev ~]# ifconfig

cni0: flags=4163 mtu 1450

inet 10.244.0.1 netmask 255.255.255.0 broadcast 10.244.0.255

inet6 fe80::6435:53ff:fea0:638b prefixlen 64 scopeid 0x20

ether 66:35:53:a0:63:8b txqueuelen 1000 (Ethernet)

RX packets 124 bytes 12884 (12.5 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 122 bytes 29636 (28.9 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

docker0: flags=4099 mtu 1500

inet 172.17.0.1 netmask 255.255.0.0 broadcast 172.17.255.255

ether 02:42:12:9c:9e:91 txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

ens33: flags=4163 mtu 1500

inet 192.168.2.129 netmask 255.255.255.0 broadcast 192.168.2.255

inet6 fe80::a923:989b:b165:8e3b prefixlen 64 scopeid 0x20

ether 00:0c:29:d9:5e:32 txqueuelen 1000 (Ethernet)

RX packets 131 bytes 13435 (13.1 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 73 bytes 17977 (17.5 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0一旦网络包超过 MTU 的大小,就会在网络层分片,以保证分片后的 IP 包不大于 MTU 值。

显然,MTU 越大,需要的分包也就越少,自然,网络吞吐能力就越好。

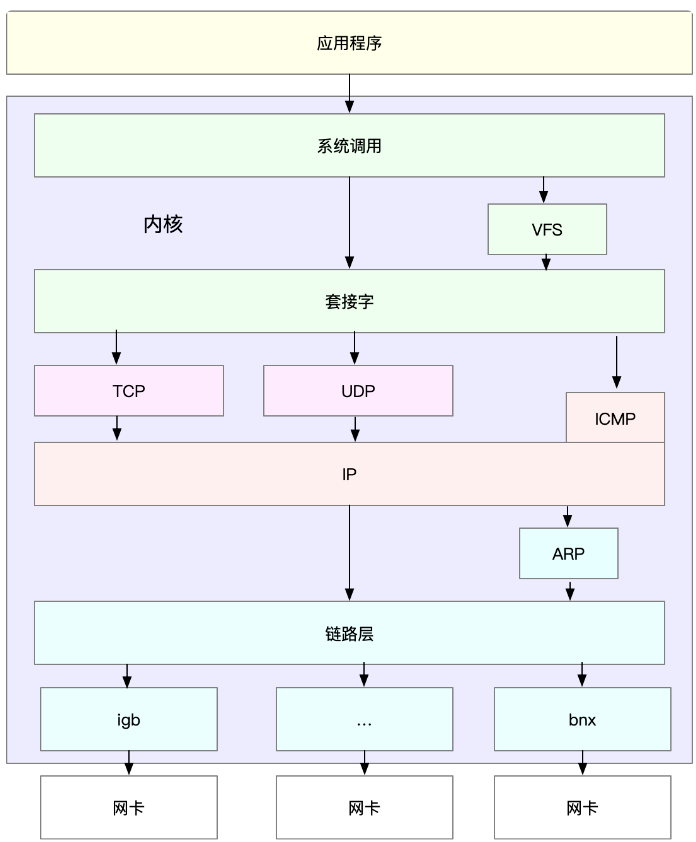

理解了 TCP/IP 网络模型和网络包的封装原理后,对Linux 内核中的网络栈,其实也类似于 TCP/IP 的四层结构。

如下图所示,就是 Linux 通用 IP 网络栈的示意图:

从上到下来看这个网络栈,你可以发现,

• 最上层的应用程序,需要通过系统调用,来跟套接字接口进行交互;

• 套接字的下面,就是我们前面提到的传输层、网络层和网络接口层;

• 最底层,则是网卡驱动程序以及物理网卡设备。

网卡是发送和接收网络包的基本设备。

在系统启动过程中,网卡通过内核中的网卡驱动程序注册到系统中。而在网络收发过程中,内核通过中断跟网卡进行交互。

网络包的处理非常复杂,所以,网卡硬中断只处理最核心的网卡数据读取或发送,而协议栈中的大部分逻辑,都会放到软中断中处理。

Linux网络包收发流程

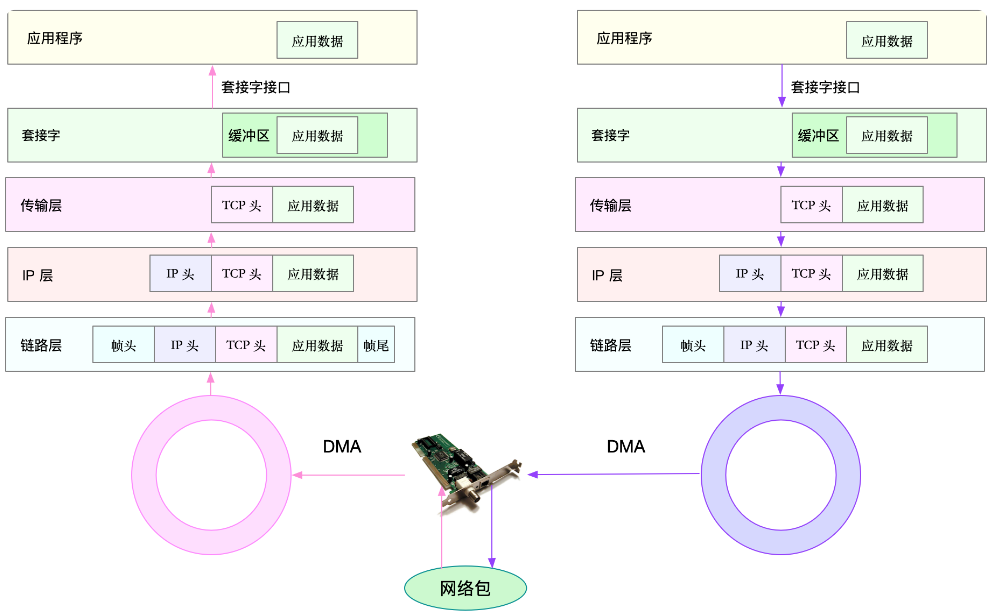

了解了 Linux 网络栈后,我们再来看看, Linux 到底是怎么收发网络包的。

PS:以下内容都以物理网卡为例。Linux 还支持众多的虚拟网络设备,而它们的网络收发流程会有一些差别。

网络包的接收流程

我们先来看网络包的接收流程。

1. 当一个网络帧到达网卡后,网卡会通过 DMA 方式,把这个网络包放到收包队列中;然后通过硬中断,告诉中断处理程序已经收到了网络包。

2. 接着,网卡中断处理程序会为网络帧分配内核数据结构(sk_buff),并将其拷贝到 sk_buff 缓冲区中;然后再通过软中断,通知内核收到了新的网络帧。

3. 接下来,内核协议栈从缓冲区中取出网络帧,并通过网络协议栈,从下到上逐层处理这个网络帧。比如,

在链路层检查报文的合法性,找出上层协议的类型( IPv4 还是 IPv6),再去掉帧头、帧尾,然后交给网络层。

1. 网络层取出 IP 头,判断网络包下一步的走向,比如是交给上层处理还是转发。当网络层确认这个包是要发送到本机后,就会取出上层协议的类型(TCP 还是 UDP),去掉 IP 头,再交给传输层处理。

2. 传输层取出 TCP 头或者 UDP 头后,根据 < 源 IP、源端口、目的 IP、目的端口 > 四元组作为标识,找出对应的 Socket,并把数据拷贝到 Socket 的接收缓存中。

3. 最后,应用程序就可以使用 Socket 接口,读取到新接收到的数据了。

具体过程如下图所示,这张图的左半部分表示接收流程,而图中的粉色箭头则表示网络包的处理路径。

网络包的发送流程

网络包的发送流程就是上图的右半部分,很容易发现,网络包的发送方向,正好跟接收方向相反。

首先,应用程序调用 Socket API(比如 sendmsg)发送网络包。由于这是一个系统调用,所以会陷入到内核态的套接字层中。套接字层会把数据包放到 Socket 发送缓冲区中。

接下来,网络协议栈从 Socket 发送缓冲区中,取出数据包;再按照 TCP/IP 栈,从上到下逐层处理。比如,传输层和网络层,分别为其增加 TCP 头和 IP 头,执行路由查找确认下一跳的 IP,并按照 MTU 大小进行分片。

分片后的网络包,再送到网络接口层,进行物理地址寻址,以找到下一跳的 MAC 地址。然后添加帧头和帧尾,放到发包队列中。这一切完成后,会有软中断通知驱动程序:发包队列中有新的网络帧需要发送。

最后,驱动程序通过 DMA ,从发包队列中读出网络帧,并通过物理网卡把它发送出去。

在不同的网络协议处理下,给我们的网络数据包加上了各种头部,这保证了网络数据在各层物理设备的流转下可以正确抵达目的地。

收到处理后的网络数据包后,接受端再通过网络协议将头部字段去除,得到原始的网络数据。

下图是客户端与服务器之间用网络协议连接通信的过程:

Linux 网络根据 TCP/IP 模型,构建其网络协议栈。TCP/IP 模型由应用层、传输层、网络层、网络接口层等四层组成,这也是 Linux 网络栈最核心的构成部分。

应用程序通过套接字接口发送数据包时,先要在网络协议栈中从上到下逐层处理,然后才最终送到网卡发送出去;而接收数据包时,也要先经过网络栈从下到上的逐层处理,最后送到应用程序。

了解 Linux 网络的基本原理和收发流程后,你肯定迫不及待想知道,如何去观察网络的性能情况。具体而言,哪些指标可以用来衡量 Linux 的网络性能呢?

常用网络相关命令

分析网络问题的第一步,通常是查看网络接口的配置和状态。你可以使用 ifconfig 或者 ip 命令,来查看网络的配置。

ifconfig 和 ip 分别属于软件包 net-tools 和 iproute2,iproute2 是 net-tools 的下一代,通常情况下它们会在发行版中默认安装。

以网络接口 ens33 为例,可以运行下面的两个命令,查看它的配置和状态:

[root@dev ~]# ifconfig ens33

ens33: flags=4163 mtu 1500

inet 192.168.2.129 netmask 255.255.255.0 broadcast 192.168.2.255

inet6 fe80::a923:989b:b165:8e3b prefixlen 64 scopeid 0x20

ether 00:0c:29:d9:5e:32 txqueuelen 1000 (Ethernet)

RX packets 249 bytes 22199 (21.6 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 106 bytes 22636 (22.1 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

[root@dev ~]#

[root@dev ~]# ip -s addr show ens33

2: ens33: mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 00:0c:29:d9:5e:32 brd ff:ff:ff:ff:ff:ff

inet 192.168.2.129/24 brd 192.168.2.255 scope global noprefixroute ens33

valid_lft forever preferred_lft forever

inet6 fe80::a923:989b:b165:8e3b/64 scope link noprefixroute

valid_lft forever preferred_lft forever

RX: bytes packets errors dropped overrun mcast

24877 279 0 0 0 0

TX: bytes packets errors dropped carrier collsns

24616 123 0 0 0 0可以看到,ifconfig 和 ip 命令输出的指标基本相同,只是显示格式略微不同。比如,它们都包括了网络接口的状态标志、MTU 大小、IP、子网、MAC 地址以及网络包收发的统计信息。

有几个字段可以重点关注下:

第一,网络接口的状态标志。ifconfig 输出中的 RUNNING ,或 ip 输出中的 LOWER_UP ,都表示物理网络是连通的,即网卡已经连接到了交换机或者路由器中。如果你看不到它们,通常表示网线被拔掉了。

第二,MTU 的大小。MTU 默认大小是 1500,根据网络架构的不同(比如是否使用了 VXLAN 等叠加网络),你可能需要调大或者调小 MTU 的数值。

第三,网络接口的 IP 地址、子网以及 MAC 地址。这些都是保障网络功能正常工作所必需的,你需要确保配置正确。

第四,网络收发的字节数、包数、错误数以及丢包情况,特别是 TX ( Transmit发送 )和 RX(Receive接收 ) 部分的 errors、dropped、overruns、carrier 以及 collisions 等指标不为 0 时,通常表示出现了网络问题。其中:

• errors 表示发生错误的数据包数,比如校验错误、帧同步错误等;

• dropped 表示丢弃的数据包数,即数据包已经收到了 Ring Buffer,但因为内存不足等原因丢包;

• overruns 表示超限数据包数,即网络 I/O 速度过快,导致 Ring Buffer 中的数据包来不及处理(队列满)而导致的丢包;

• carrier 表示发生 carrirer 错误的数据包数,比如双工模式不匹配、物理电缆出现问题等;

• collisions 表示碰撞数据包数。

套接字信息

套接字接口在网络程序功能中是内核与应用层之间的接口。TCP/IP 协议栈的所有数据和控制功能都来自于套接字接口,与 OSI 网络分层模型相比,TCP/IP 协议栈本身在传输层以上就不包含任何其他协议。

在 Linux 操作系统中,替代传输层以上协议实体的标准接口,称为套接字,它负责实现传输层以上所有的功能,可以说套接字是 TCP/IP 协议栈对外的窗口。

ifconfig 和 ip 只显示了网络接口收发数据包的统计信息,但在实际的性能问题中,网络协议栈中的统计信息,我们也必须关注,可以用 netstat 或者 ss ,来查看套接字、网络栈、网络接口以及路由表的信息。

我个人更推荐,使用 ss 来查询网络的连接信息,因为它比 netstat 提供了更好的性能(速度更快)。

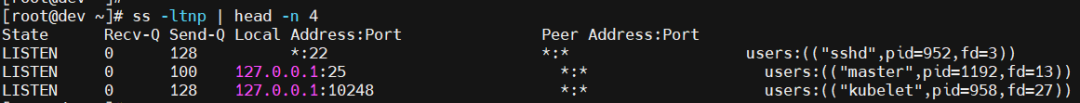

比如,你可以执行下面的命令,查询套接字信息:

# head -n 4 表示只显示前面4行

# -l 表示只显示监听套接字

# -n 表示显示数字地址和端口(而不是名字)

# -p 表示显示进程信息

[root@dev ~]# netstat -nlp | head -n 4

Active Internet connections (only servers)

Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 952/sshd

tcp 0 0 127.0.0.1:25 0.0.0.0:* LISTEN 11/master

# -l 表示只显示监听套接字

# -t 表示只显示 TCP 套接字

# -n 表示显示数字地址和端口(而不是名字)

# -p 表示显示进程信息

$ ss -ltnp | head -n 4

netstat 和 ss 的输出也是类似的,都展示了套接字的状态、接收队列、发送队列、本地地址、远端地址、进程 PID 和进程名称等。

其中,接收队列(Recv-Q)和发送队列(Send-Q)需要你特别关注,它们通常应该是 0。

当你发现它们不是 0 时,说明有网络包的堆积发生。当然还要注意,在不同套接字状态下,它们的含义不同。

当套接字处于连接状态(Established)时,

• Recv-Q 表示套接字缓冲还没有被应用程序取走的字节数(即接收队列长度)。

• Send-Q 表示还没有被远端主机确认的字节数(即发送队列长度)。

当套接字处于监听状态(Listening)时,

• Recv-Q 表示全连接队列的长度。

• Send-Q 表示全连接队列的最大长度。

所谓全连接,是指服务器收到了客户端的 ACK,完成了 TCP 三次握手,然后就会把这个连接挪到全连接队列中。这些全连接中的套接字,还需要被 accept() 系统调用取走,服务器才可以开始真正处理客户端的请求。

与全连接队列相对应的,还有一个半连接队列。所谓半连接是指还没有完成 TCP 三次握手的连接,连接只进行了一半。服务器收到了客户端的 SYN 包后,就会把这个连接放到半连接队列中,然后再向客户端发送 SYN+ACK 包。

连接统计信息

类似的,使用 netstat 或 ss ,也可以查看协议栈的信息:

[root@dev ~]# netstat -s

...

Tcp:

1898 active connections openings

1502 passive connection openings

24 failed connection attempts

1304 connection resets received

178 connections established

133459 segments received

133428 segments send out

22 segments retransmited

0 bad segments received.

1400 resets sent

...

[root@dev ~]# ss -s

Total: 1700 (kernel 2499)

TCP: 340 (estab 178, closed 144, orphaned 0, synrecv 0, timewait 134/0), ports 0

Transport Total IP IPv6

* 2499 - -

RAW 1 0 1

UDP 5 3 2

TCP 196 179 17

INET 202 182 20

FRAG 0 0 0这些协议栈的统计信息都很直观。

ss 只显示已经连接、关闭、孤儿套接字等简要统计,而 netstat 则提供的是更详细的网络协议栈信息,展示了 TCP 协议的主动连接、被动连接、失败重试、发送和接收的分段数量等各种信息。

连通性和延时

通常使用 ping ,来测试远程主机的连通性和延时,而ping基于 ICMP 协议。

比如,执行下面的命令,你就可以测试本机到 192.168.2.129 这个 IP 地址的连通性和延时:

[root@dev ~]# ping -c3 192.168.2.129

PING 192.168.2.129 (192.168.2.129) 56(84) bytes of data.

64 bytes from 192.168.2.129: icmp_seq=1 ttl=64 time=0.026 ms

64 bytes from 192.168.2.129: icmp_seq=2 ttl=64 time=0.016 ms

64 bytes from 192.168.2.129: icmp_seq=3 ttl=64 time=0.015 ms

--- 192.168.2.129 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 1998ms

rtt min/avg/max/mdev = 0.015/0.019/0.026/0.005 msping 的输出,可以分为两部分。

1. 第一部分,是每个 ICMP 请求的信息,包括 ICMP 序列号(icmp_seq)、TTL(生存时间,或者跳数)以及往返延时。

2. 第二部分,则是三次 ICMP 请求的汇总。

比如上面的示例显示,发送了 3 个网络包,并且接收到 3 个响应,没有丢包发生,这说明测试主机到 192.168.2.129是连通的;平均往返延时(RTT)是 0.026 ms,也就是从发送 ICMP 开始,到接收到主机回复的确认,总共经历的时间。