结合夏热冬冷地区的自然条件,介绍了长沙某数据中心的工程概况,简述了该工程冷源、空调水系统及风系统的设计,详细介绍了自然冷却技术、冷水机组的选择、通过CFD仿真模拟,单侧送风情况下,通过封闭冷通道、架空地板下送风的方式,可满足单列21个标准20A机柜的制冷需求,为后续数据中心空调系统设计提供基础数据和分析方法。 关键词:冷水机组 数据中心 封闭冷通道 自然冷却 CFD仿真 机房空调 0引言 随着大数据、云计算、人工智能、5G网络等新兴产业的快速发展,数据处理设备的集成化越来越高,数据中心的能耗也大幅增加。数据中心制冷系统全年运行耗能巨大,因此在保障数据中心安全运行的条件下,采用节能新技术、新工艺,降低数据中心空调系统能耗,对建设绿色节能的数据中心至关重要。本文以长沙某数据中心空调系统为例,从设备选型、系统优化、节能技术应用等方面为数据中心空调系统设计提供整体化的解决方案,供同行参考。

1 工程概述

1.1 工程概况 该工程为长沙某数据中心工程,位于长沙市望城经济开发区(见图1)。该工程一期包含两幢数据中心、一幢动力中心及地下水泵房,一期总建筑面积39290m2, 其中单幢数据中心建筑面积17868.33 m2,建筑高度22.90 m;地上共四层, 1层为冷冻站、ECC机房以及配套辅助用房,标准层为变配电室室、电池室、通信机房。

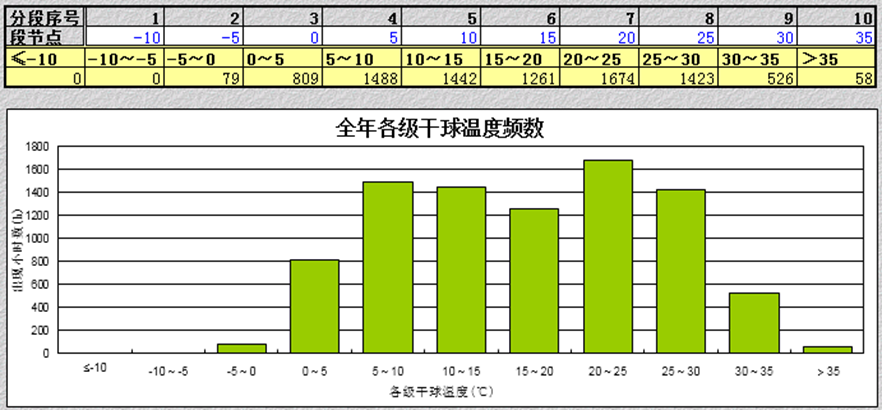

1.2 室内外设计参数 1)室外设计参数 长沙市望城区,属中亚热带季风湿润气候,年降水量为1370 mm左右,全年平均气温17 ℃,日照1610小时,无霜期274天;气候温和,降水充沛,雨热同期,四季分明是其主要的气候特征;全年干球温度时长分布如图 2所示,全年湿球温度时长分布如图3所示,室外设计计算参数见表1。

图2 全年干球温度时长分布

图3 全年湿球温度时长分布 表1 室外设计计算参数[1]

| 夏季 | 冬季 | |

| 干球温度/℃ | 35.8 | —1.9 |

| 湿球温度/℃ | 27.7 | |

| 通风温度/℃ | 32.9 | 4.6 |

| 相对湿度/% | 61 | 83 |

| 室外平均风速/(m/s) | 2.6 | 2.3 |

2)室内设计参数(见表2) 表2 设计参数

| 项目 | 技术要求 | 备注 |

| 冷通道或机柜进风区域的温度 | 18~27℃ | 不得结露 |

| 冷通道或机柜进风区域的相对湿度和露点温度 | 露点温度5.5~15℃,同时相对湿度不大于60% | |

| 辅助区温度、相对湿度(开机时) | 18℃~28℃,35%~75% | |

| 电池室温度 | 20℃~30℃ |

注:主机房内空气含尘浓度,在静态或动态条件下测试,每升空气中粒径≥ 0.5μ m的悬浮粒子数应少于17600粒。

2 空调冷源 2.1 空调系统冷负荷 根据工艺专业规划,该数据中心终期可安装的通信设备功耗为7582 kW,电力电池室及不间断电源等电力设备发热量为848 kW,通过逐项逐时的冷负荷计算得到该数据中心夏季冷负荷为10371 kW,设计冗余系数取1.1,设计容量为11409 kW。 2.2 空调系统冷源 1)冷源设计 根据长沙市气候特点,结合该数据中心的工艺规划及冷负荷,采用集中式水冷冷水系统的空调系统形式,冷水供/回水温度为 14 ℃/20 ℃,空调末端采用房间级冷冻水型机房专用空调。冷水空调系统主机选用4台3 868 kW水冷离心式冷水机组,按三用一备模式配置。每台水冷离心式冷水机组配套1台板式换热器。冷水机房内同时还配有落地式自动补水定压装置、全自动加药装置、微晶旁流水处理器、冷却水循环泵、冷水循环泵等设备[2-3]。冷水机房主要设备如表3所示。 表3 冷水机房主要设备

| 设备参数 | 数量/台 | |

| 水冷式离心冷水机组 | 制冷量3868 kW,输入功率506 kW | 4 |

| 冷却水循环泵 (卧式双吸离心泵) | G=830m³/h,H=34m,N=110kW | 4 |

| 冷水循环泵 (卧式端吸离心泵) | G=600m³/h,H=22m,N=55kW | 4 |

| 冷水循环泵 (卧式端吸离心泵) | G=600m³/h,H=28m,N=75kW | 4 |

| 立式离心泵 | G=2m³/h,H=40m,N=1.5kW | 2 |

| 板式换热器 | 换热量4500kW,T1=18.5℃,T2=12.5℃,T3=14℃,T4=20℃ | 4 |

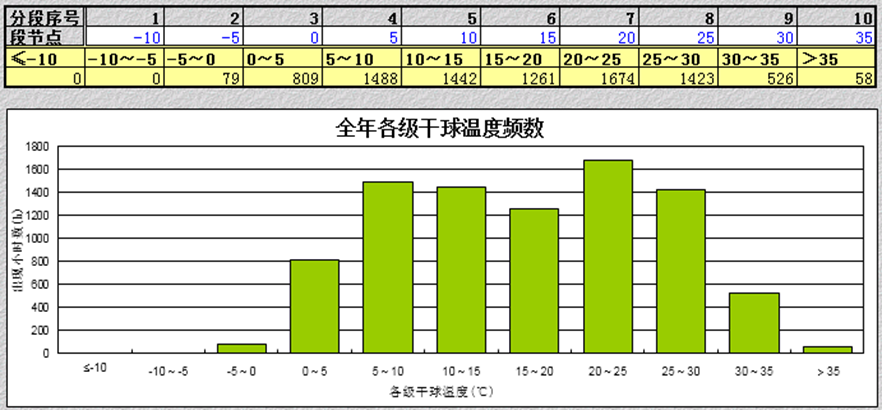

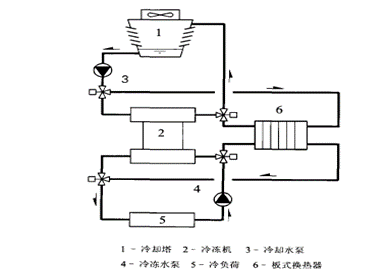

注:G为流量,m³/h;H为扬程,m ;N为输入功率,kW;T1为一次侧出水温度,T2为一次侧进水温度; T3为二次侧出水温度,T4为二次侧进水温度。 2)空调冷源系统流程 空调冷源系统流程如图4所示。

图4 空调冷源系统流程图

3 空调水系统 3.1 冷水系统

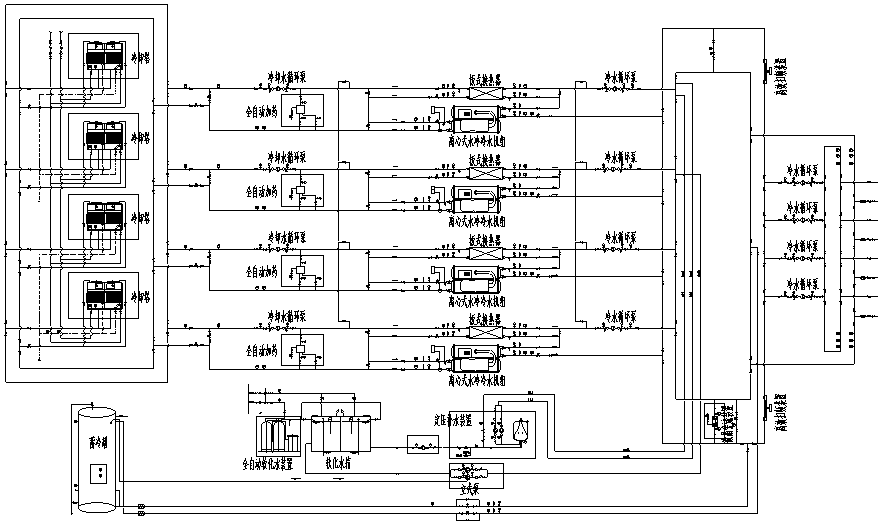

空调冷水侧采用模块化设计,离心式冷水机组、板式换热器、冷水泵组成一个制冷模块。水系统设计采用二级泵环网,一级泵、二级泵均为变频控制, 为提高制冷模块之间的互用性,每个模块之间增设跨接管,在单个模块水泵故障时,只需启用备用模块水泵,无需切换整个制冷模块。末端管路为双路供水,同时在每个末端三通处设置阀门,保证单点故障或单点维护时不影响整个水系统的运行。为防止空调冷水、冷凝水、加湿水管漏水后进入机柜设备区,采用隔墙将空调区和机房区分开,并在空调区地面上均匀排布若干排水口,以保证漏水及时排出。空调末端系统流程图如图5所示。

图5 空调末端系统流程图

3.2 冷却水系统

空调冷却水系统采用环网设计,采用钢制低噪音开式横流塔,将经冷水机组升温至37 ℃的冷却水送至冷却塔进行冷却,水温降至32 ℃,经冷却水环网、冷却水泵加压后再返回冷水机组。冷却水侧同冷水侧一样增设跨接管,保证冷却侧每个制冷模块之间冷却水泵的互用。屋面冷却塔溢流、排污水设置管道单独排放。冷却水系统配置全自动加药处理装置保证冷却水水质。冷却水补水采用市政给水加应急补水源的方式保障,按补12 h冷却水补水量配置应急补水池。

3.3 水蓄冷系统 本工程冷水系统配置1个550 m3的开式蓄冷水罐,以解决市电中断、柴油发电机启动至冷水机组恢复运行这段时间的空调系统供冷(此时二级冷水泵、空调末端风机用电由不间断电源保障),从而保证了空调系统与通信设备不间断地同步运行。蓄冷保障时间按满足整个数据中心15 min的用电配置。

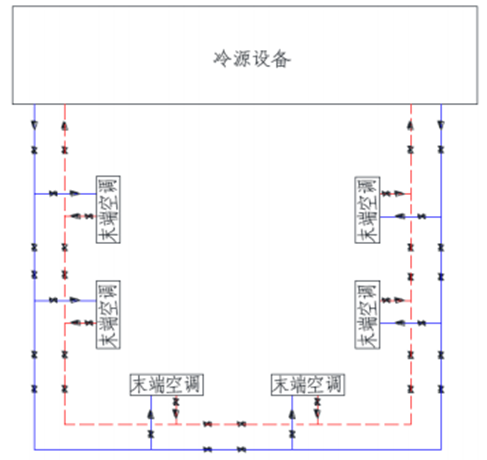

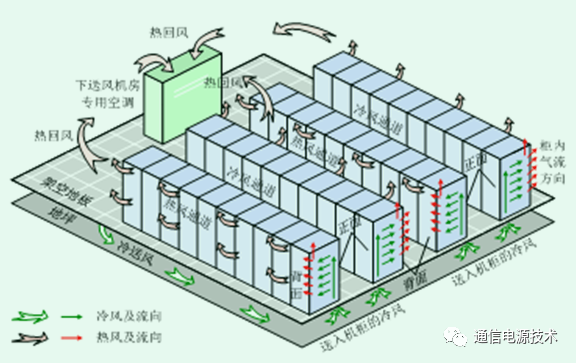

4 空调风系统 电池室和变配电室室内气流组织形式为风管或风帽上送风、机组侧下回风;通信机房气流组织形式为架空地板下送风,机组上部自然回风,并通过封闭冷通道将冷、热气流完全隔离;新风系统采用水环热泵新风机组,维持机房正压(5~10 Pa)及保障人员新风要求。主机房气流组织形式见图6。

图6 封闭冷通道气流组织示意图

5 工程特色和技术创新

5.1提高冷水供/回水温度,采用独立加/除湿一体机 目前,传统数据中心通信机房采用冷冻水型机房专用空调。本工程采用独立的湿膜式恒湿器满足机房湿度要求。采用湿膜加湿,制冷除湿,该方案优点在于:机房空调基本在干工况运行,不产生凝结水,机房加湿量小,这样避免了专用空调降温除湿后再电加湿产生冷量和热量的浪费。水冷空调的冷水供/回水温度的标准工况为7℃/12℃,本项目将空调系统冷水供/回水温度提高到14℃/20℃,可降低冷水机组耗电,同时增加自然冷却时间,提高空调系统运行节能效果。

5.2 自然冷却技术应用 长沙市为夏热冬冷地区,考虑采用自然冷却技术,本工程通过提高冷冻水供回水温度(14/20℃),冬季冷却塔自然冷却选型湿球温度(按6℃湿球温度),延长自然冷却时间。长沙市全年室外湿球温度≤6℃时间为1550小时,可完全关闭制冷机组,采用冷却塔加板式换热器进行换热。当冷却塔出水温度低于制冷机组冷水回水温度,可进行部分自然冷却,这样就大大减少了开启制冷机组的时间,不仅可以延长压缩机使用年限,还能减低制冷系统耗电,节能效果显著。板式换热器自然冷却示意图如图7所示。

图7 板式换热器自然冷却示意图 5.3低压变频冷水机组与高压定频冷水机组分析比较 根据本设计数据空调负荷计算结果,本工程共配置4台离心式冷水机组,单台制冷量为1100RT(3868kW),其中1台为备用。机组相关电气参数如表4所示。 表4 离心式冷水机组参数表

| 机组规格 | 1100RT | |

| 电压等级 | 380V | 10kV |

| 额定电流(A) | 1141 | 42 |

| 启动电流(A) | 7113 | 295 |

| 额定功率(W) | 653.9 | 658.8 |

《民用建筑电气设计规范》JGJ/T16-2008中第3.4.2款:当用电设备总容量在250kW及以上或变压器容量在160kW及以上时,宜以10(6)kV供电。 《民用建筑供暖通风与空气调节设计规范》GB 50736-2012中第8.2.4.3款:当单台冷水机组电动机的额定输入功率大于650kW而小于或等于900kW时,可采用高压供电方式。 根据上述规范要求,本工程冷水机组可采用380V低压与10kV高压两种方式,本次从初投资和运行费用两个方面进行对比分析,从而选择适合本项目的冷源形式。 5.3.1冷水机组设备初投资比较 380V低压变频冷水机组与10kV高压定频冷水机组初投资比较如表5所示。 表5 冷水机组设备初投资比较表

| 机组规格 | 380V供电变频冷水机组 | 10kV供电定频冷水机组 | ||||||||||

| 制冷量 (kW) | 单价 (万/台) | 数量(台) | 小计(万) | 变频启动柜 (万/台) | 数量(台) | 小计 (万) | 单价 (万/台) | 数量(台) | 小计(万) | 启动柜价格 (万/台) | 数量(台) | 小计(万) |

| 3868 | 203.6 | 4 | 814.4 | 32.6 | 4 | 130.4 | 210 | 4 | 840 | 38.7 | 4 | 154.8 |

| 合计(万) | 944.8 | 994.8 | ||||||||||

备注:

1、单价为设备总价,总价包含机组整体价格(含初次充注的冷媒、润滑油)、运费及运输保险、开机调试费、一年的保用。

2、变频增加价格及高压启动增加价格基于与380V/50HZ常规机组的增加的价格。

5.3.2冷水机组变配电设备初投资比较 10KV高压定频冷水机组需配置启动柜、电抗柜、无功补偿柜,380V低压变频机组需占用变压器容量,同时后期需要进行谐波治理,变配电设备初投资比较如表6、表7所示。 表6 冷水机组设备初投资比较表

| 供电方案 | 10kV电机方案 | 380V电机方案 |

| 方案内容 | 10kV冷水机组需配置启动、电抗、无功补偿柜 | 380V冷水机组需占用3000kVAx2(2N配置)变压器的容量 |

| 10kV中置柜 | 每套冷水机组配置3个10kV中置柜 | 无 |

| 15万x3x4=180万 | ||

| 2000kVA变压器 | 无 | 3000kVAx2(2N配置)变压器 |

| 25万x1.5x2=75万 | ||

| 低压开关柜 | 无 | 每套冷水机组配置1台低配柜,共需3台300kvar补偿柜 |

| 10万x7=70万 | ||

| 低压电缆 | 16根ZR-YJY-1-3*185+2*95低压电缆 | |

| 16x60x0.05万=48万 | ||

| 合计(万) | 180万 | 198万 |

表7 低压变频机组谐波治理费用

| 机组规格 | 谐波治理费用 | |||

| 制冷量(kW) | 单价(万/台) | 数量 (台) | 小计 (万) | 合计 (万) |

| 3868 | 30 | 4 | 120 | 120 |

5.3.3 冷水机组运行费用比较 本工程终期冷水机组运行模式为四台冷水机组均为主用,备用机组处于热备模式,每台机组的负载率为75%,提高空调系统的运行效率。冷水机组运行费用如表8所示。 表8 冷水机组运行费用比较表

| 制冷量(kW) | 室外湿球温度(℃) | 冷却水进水温度(℃) | 运行时间(h) | 运行工况点 | 机组运行功耗(kW) | 电费单价(元/kWh) | 台数 | 运行费用 (元/kWh) | 备注 | ||

| 380V低压变频机组 | 10kV高压机组 | 0.8 | 380V低压变频机组 | 10kV高压机组 | |||||||

| 3329 | >28 | 32 | 47 | 75% | 368.3 | 392.1 | 4 | 55392.32 | 58971.84 | 主机制冷 | |

| 25≤28 | 28 | 924 | 75% | 307.2 | 353.5 | 908329 | 1045229 | 主机制冷 | |||

| 20≤25 | 24 | 2047 | 75% |

文章来源于: 电子工程世界

原文链接

本站所有转载文章系出于传递更多信息之目的,且明确注明来源,不希望被转载的媒体或个人可与我们联系,我们将立即进行删除处理。 | |||||||