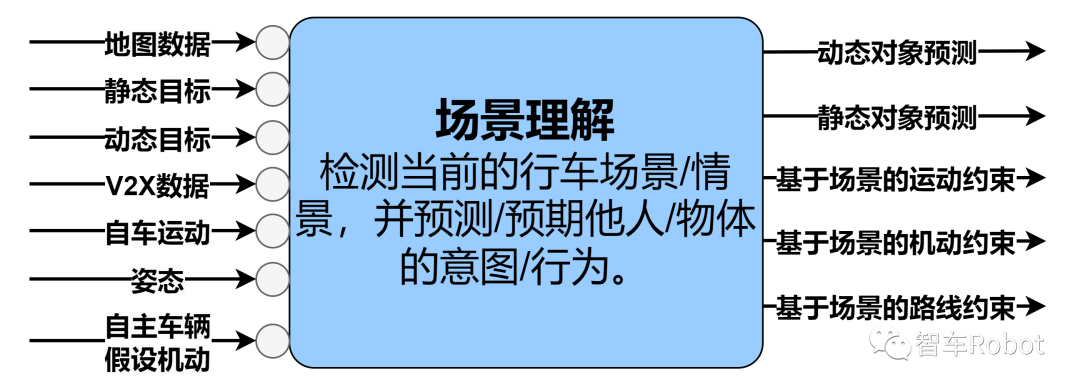

场景理解

场景理解功能模块图场景理解功能模块体现了负责“理解”当前驾驶场景的算法。如果自主车辆要在共享的驾驶空间中进行智能操纵,则有必要预测/预见该空间内其他实体的行动。场景或方案理解不仅仅是识别当前情况的“状态”,还包括对其演变方式的预测。

此功能模块中的算法可能能够模拟多种因果场景,以帮助为自主车辆选择最佳行动方案。然而,场景理解本身不会对自主车辆应该采取的行动做出任何决定,也不会选择要模拟的行动方案。

场景理解输入:

•地图数据:提供当前驾驶场景中基础设施的布局。对预测其他道路使用者/实体的意图/行为有用。

•静态对象:识别驾驶场景中对自主车辆和其他道路实体可能占用的可行驶空间有影响的不可移动对象。静态对象可能具有动态变化的状态,如交通灯变红或收费站变为关闭。

•动态对象:用于预测当前驾驶场景可能如何演变,主要关注动态对象的轨迹和状态变化。动态对象的一个预测示例是车辆刚打开左转灯然后左转。

•V2X数据:可能提供可以利用的信息来预见当前驾驶场景的演变,如即将改变的交通灯。

•自车运动:为预测引擎提供自主车辆自车运动信息。

•姿态:允许预测引擎在地图上放置自主车辆。

•自主车辆假设机动:为预测引擎提供自主车辆的假设机动。这种机动可能会引发其他道路使用者的反应,需要预测。例如,改道可能会强迫该车道上迎面而来的另一个道路使用者进行危险制动。在行为规划做出决定之前,可能会向场景理解功能模块提交多个自主车辆机动假设。

场景理解输出:•动态对象预测:用于安全计划改变自主车辆当前轨迹。

•静态对象预测:用于安全计划改变自主车辆当前轨迹。

•基于场景的运动约束:根据驾驶场景条件约束自主车辆的运动。

•基于场景的机动约束:根据驾驶场景条件约束自主车辆的计划机动。

•基于场景的路线约束:根据驾驶场景对自主车辆的路线规划加以约束。

•场景数据:提供可以利用的集体驾驶条件视图,以确保自主车辆在其设计参数内运行。