AI服务器浪潮席卷全球,带动AI加速芯片需求。DRAM关键性产品异军突起,成为了半导体下行周期中逆势增长的风景线。业界认为,是加速未来AI技术发展的关键科技之一。

本文引用地址:近期,市场动静不断。先是SK海力士、美光科技存储两大厂释出2024年HBM产能售罄。与此同时,HBM技术再突破、大客户发生变动、被划进国家战略技术之一...一时间全球目光再度聚焦于HBM。

1

HBM:三分天下

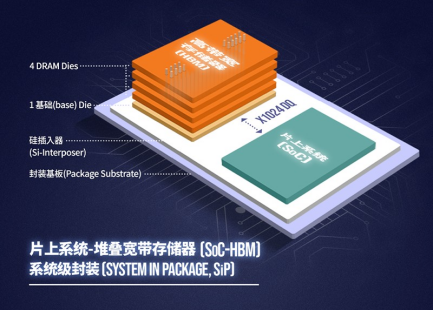

HBM(全称为High Bandwidth Memory),是高带宽存储器,是属于图形DDR内存的一种。从技术原理上讲,HBM是将很多个DDR芯片堆叠在一起后,再和GPU封装合成,通过增加带宽,扩展内存容量,组成DDR组合阵列,以此实现让更大的模型、更多的参数留在离核心计算更近的地方,从而减少内存和存储解决方案所带来的延迟。

图片来源:SK海力士官网

通俗来讲,传统DDR内存芯片是一层平房结构,具备HBM结构的内存是现代化的摩天大楼,在占地面积不变的基础上,向三维高度发展。

与传统DRAM芯片相比,HBM具有高带宽、高容量、低延时与低功耗等优势,可以加快AI数据处理速度。业界指出,HBM可以将专用数据处理器直接集成在DRAM中,将部分数据计算工作从主机处理器转移到存储器当中,从而满足AI芯片训练的高宽带要求,也因此更适用于ChatGPT等高性能计算场景。

目前,HBM市场高度集中,呈现三足鼎立的态势。此前据TrendForce集邦咨询研究显示,2022年三大原厂HBM市占率分别为SK海力士(SK hynix)50%、(Samsung)约40%、美光(Micron)约10%。

图片来源:拍信网

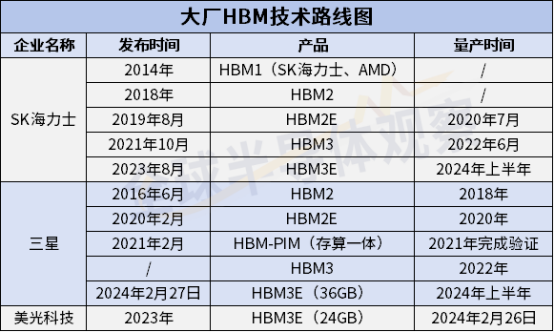

从技术迭代上看,自2014年全球首款硅通孔(TSV, Through Silicon Via)HBM产品问世以来,HBM已经从HBM、HBM2、HBM2E,发展至被业界认为即将成为市场主流的HBM3、HBM3E。未来或将到达HBM4,甚至HBM4E。

图表来源:全球半导体观察制表

2

大厂冲锋,HBM3E扛技术大旗

从存储大厂HBM布局路线来看,率先走在起跑线上的是SK海力士。2013年,SK海力士与AMD合作开发了全球首款HBM。作为领跑者,SK海力士不负众望陆续成功研发出HBM迭代产品HBM2、HBM2E、HBM3、HBM3E。该公司计划在2024年上半年将HBM3E投入量产。

则从HBM2起跑,虽是后起之军,却也不堪落后。于2016年推出HBM2,2020年2月HBM2E,2021年2月推出了HBM-PIM(存算一体),实现内存半导体和AI处理器合二为一,其HBM3也于2020年量产。今年2月27日三星发布了首款36GB HBM3E 12H DRAM,这是三星目前为止容量最大的HBM产品。目前,三星已开始向客户提供HBM3E 12H样品,预计于今年下半年开始大规模量产。

另一大厂美光科技开始出击,该公司选择跳过第四代HBM3,直接布局第五代HBM3E。美光于2023年9月推出HBM3E,并于今年2月26日宣布已开始批量生产HBM3E解决方案。其中24GB 8-High HBM3E将成为NVIDIA H200 Tensor Core GPU的一部分,该GPU将于 2024 年第二季度开始发货;而36GB 12-High HBM3E样品扩大了其领先地位,与竞争解决方案相比,该产品预计将提供超过1.2 TB/s的性能。

图表来源:全球半导体观察制表

从规格上看,目前HBM市场主流为HBM2E,包含NVIDIA A100/A800、AMD MI200以及多数CSPs自研加速芯片皆以此规格设计。不过随着各大原厂不断加速突破技术堡垒,业界称未来HBM3与HBM3E将挑起大梁。

TrendForce集邦咨询预估,2024年HBM供给情况可望大幅改善。以规格而言,伴随AI芯片需要更高的效能,HBM主流也将在2024年移转至HBM3与HBM3E。整体而言,在需求位元提高以及HBM3与HBM3E平均销售价格高于前代产品的情形下,2024年HBM营收可望有显著的成长。

此外,关于业界十分关心的HBM4问题,据TrendForce集邦咨询预计,HBM4有望于2026年推出。目前包含NVIDIA以及其他CSP(云端业者)在未来的产品应用上,规格和效能将更优化。例如,随着客户对运算效能要求的提升,HBM4在堆栈的层数上,除了现有的12hi (12层)外,也将再往16hi (16层)发展,更高层数也预估带动新堆栈方式hybrid bonding的需求。HBM4 12hi产品将于2026年推出;而16hi产品则预计于2027年问世。

3

大头客户策略有变,或牵动HBM

AI模型复杂化正推动HBM发展。从应用领域看,HBM主要应用领域AI服务器在单条模组上则多采用64~128GB,平均容量可达1.2~1.7TB之间。TrendForce集邦咨询认为,相较于一般服务器而言,AI服务器多增加GPGPU的使用,因此以NVIDIA A100 80GB配置4或8张计算,HBM用量约为320~640GB。未来在AI模型逐渐复杂化的趋势下,将刺激更多的存储器用量,并同步带动Server DRAM、SSD以及HBM的需求成长。并预期AI服务器2023~2027年出货量年复合成长率约12.2%。

从大头客户产品规格来看,AI服务器GPU市场中配备了HBM的主要以NVIDIA H100、A100、A800以及AMD MI250、MI250X系列为主。展望2024年,英伟达的产品所采用的HBM将升级至HBM3E,此外新一代B100产品将进一步拉升市场对HBM的容量需求;AMD产品仍采用HBM3,预计下一代MI350将升级为HBM3E;而英特尔产品仍将使用HBM2E。

具体来看,自去年发酵至今,HBM市场仍旧火热,而上游关键客户英伟达的H100与200依旧是市面上最抢手的GPU产品。据TrendForce集邦咨询最新预估,以2024年全球主要云端服务业者(CSP)对高端AI服务器(包含搭载NVIDIA(英伟达)、AMD或其他高端ASIC芯片等)需求量观察,搭载NVIDIA GPU的AI服务器机种占大宗。

根据去年11月底TrendForce集邦咨询的研究数据显示,2023年,NVIDIA高端AI芯片(采用HBM)既有产品包括A100/A800以及H100/H800,2024年该公司将再推出使用6颗HBM3E的H200以及8颗HBM3E的B100,并同步整合NVIDIA自家基于Arm架构的 CPU与GPU,推出GH200以及GB200。

TrendForce集邦咨询最新研究指出,NVIDIA 2024年起将正式替换A100产品,而以价格更高的H100系列为主轴。除H100,预估自今年第二季末开始小量出货搭载更高HBM3E规格的H200产品。另预估NVIDIA未来在价格上将更积极采差别订价,H100采部分折价策略,H200应维持约H100原价格水位,以提供更高性价比方式,稳固云端CSP客户。除此之外,NVIDIA将采用NRE(一次性工程费用;Non-recurring engineering Expense)模式,与Meta、Google、AWS及OpenAI等厂商展开洽谈,并将目标扩及电信、车用及电竞客户。

TrendForce集邦咨询预期,NVIDIA自2024年下半年将推出新一代B100产品,相较H系列可望在效能上又有所提升,在HBM存储器容量将高出H200约35~40%,以应对更高效能HPC或加速LLM AI训练需求。而在中低端产品上,除L40S针对企业客户做边缘端较小型AI模型训练或AI推理外,另亦规划以L4取代既有T4,作为云端或边缘AI推理应用。

值得注意的是,为避免2023年GPU供应不足问题,NVIDIA亦积极参与CoWoS及HBM等扩建产能需求,预期今年第二季在相关原厂产能逐步开出后,原交付Lead Time平均约40周也将减半,逐步去除下游供应链因GPU短缺而使AI服务器供应进度受阻问题。

在AMD和Intel方面,TrendForce集邦咨询此前指出,AMD 2024年出货主流为MI300系列,采用HBM3,下一代MI350将采用HBM3E,预计2024下半年开始进行HBM验证,实际看到较明显的产品放量(Ramp Up)时间预估应为2025年第一季。Intel Habana 2022下半年推出的Gaudi 2采用6颗HBM2E,2024年中预期在新型号Gaudi 3持续采取HBM2E,但将用量升级至8颗。

4

列为国家战略,韩国重点发力

存储器是韩国的支柱型产业之一,2024年AI浪潮更顺势拉动了HBM的市场比重,在此背景下,韩国将HBM指定为国家战略技术,并列出多项措施鼓励相关企业。

2月27日,韩国企划财政部公布了《2023年税法修正案后续执行规则修正案草案》,旨在对被纳入韩国国家战略技术的高带宽存储器(HBM)、有机发光二极管(OLED)和氢相关设施,进一步扩大税收支持。

其中,韩国国家战略性技术产业研发投资税收抵免,中小企业为40%至50%,大中型企业为30%至40%。据悉大中型企业包括三星、SK海力士等。

5

结语

值得一提的是,大厂财报透露,营收亏损幅度均有所收窄,其中HBM已成为拉动大厂们业绩回升的主力。目前消费电子已出现复苏信号,行业新的转机正在孕育生成,AI催生存力新需求,2024年存储市场有望迎来新的转机。

总体而言,受生成式AI大模型等领域的驱动,HBM逐渐发展成为新兴热门产业之一,随着上游客户不断发出新的需求,目前HBM市场正释放出供不应求的信号。对此,上述各方瞄准HBM积极布局,大厂们继续埋头攻破技术壁垒,以迅速抓住市场新机遇,属于HBM市场的一场争夺战正式开启。