0 引言

随着社会迅速发展私家车数量不断增长,频发交通事故不仅带来人身伤害和不良影响[1]。因此,智能交通系统研究已得到越来越多的关注[2],主要包括道路管控智能化,交通资源最优化和管理决策科学化,集成信息技术和图像处理技术等技术[3-4],重要前提基础就是实现车辆跟踪监测[5],通过摄像头采用图像处理技术[6],获得道路车辆行动轨迹[7]。

19 世纪中期瓦克斯首先提出运动目标跟踪,19 世纪60 年代Sittler 提出了目标轨迹概念并对瓦克斯提出的基础理论进行改进和补充。10 年后,卡尔曼滤波在目标跟踪领域取得突破后,该技术才真正走进大众视野并获得研究人员的普遍关注[8],粒子波跟踪算法[9]、Kalman 滤波,Meanshift 算法等经典传统算法[10] 被相应提出。

近年来,随着机器学习不断深入[11-12],TLD 算法因其可进行长时间的目标跟踪而得到广泛应用[13-14]。2012 年的CSK 算法,改进了训练样本集,一定程度上降低了算法运行所需的时间和资源,也提高了目标跟踪的精准程度;2015 年利用方向梯度直方图来代替单通道的灰度特征,进一步提升运行效率和性能[15]。此外,国内重点大学和重点研究室如中科院、清华大学、浙江大学等纷纷在手势识别、人脸识别或姿态识别等领域取得了重大突破[16-17]。针对不同的车辆具有不同的车辆特征,较为常见的车辆跟踪算法[18-20]有区域匹配跟踪算法、特征匹配算法、轮廓匹配跟踪算法和3D 跟踪算法。

然而目前采用的车辆跟踪技术大多只适用于特定环境或场合,实际道路交通中非常复杂有很多影响因素,车辆跟踪要适应场景的变化,如光照条件变化;其他物体的干扰如阴影、来往人群、车辆在场景中的镜面反射等;监控场景中的庞大的车辆数量、车辆进出场景、尺度变化、视角变化及物体遮挡等[21-22]。若在车辆突然拐弯,车身被行人或路边标志牌遮挡,太阳光线在多云季节因为云层移动而导致光照强度发生变动等复杂场景下,则无法做到精确跟踪车辆轨迹。为方便追踪车辆行动轨迹和车辆具体状况,复杂场景下的车辆跟踪系统一直是研究热点和话题,本文针对复杂场景下车辆运动展开研究,针对目标车辆的跟踪构造相应框架和模块并设计算法流程。

1 复杂场景下的车辆跟踪系统

1.1 系统整体框架

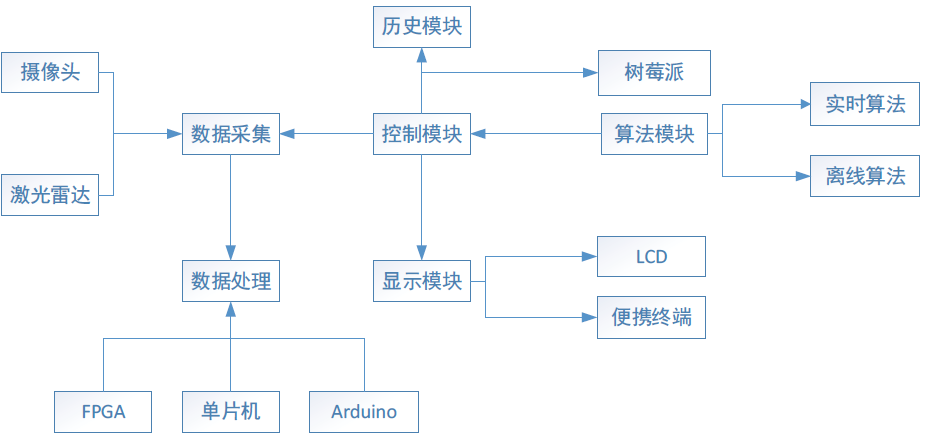

本系统整体框架如图1所示,控制模块是整个系统的核心部件,既包含相应的硬件设施也包含了实时算法和离线算法,实时算法通过图像处理进行,而离线算法通常使用数模转换算法;具备数据采集、数据显示、存储历史信息等功能。控制模块还可以通过手机、液晶显示屏或LCD 等便携终端实现信息的实时显示,而历史模块则是通过专门的历史记录模块进行存储。

图1 系统整体框架图

数据采集功能主要通过摄像头和激光雷达捕捉目标车辆的行驶轨迹和实时位置来完成,之后再将数据传递给FPGA、单片机或Arduino平台,利用可编程电子平台对采集到的数据进行处理。主要是车辆在行驶过程中的轨迹、速度、位置等信息,目前常用器件为摄像头或激光雷达。激光雷达探测范围广,精度高,鲁棒性好,利用高精地图可实现自动定位和目标跟踪。

系统利用FPGA、单片机和Arduino进行数据处理,并利用历史模块存储数据信息。目标车辆的历史信息包括运动轨迹、车辆状态、速度等均保存在历史模块中,该模块可保持数据历史信息的严密性、准确性和完整性。

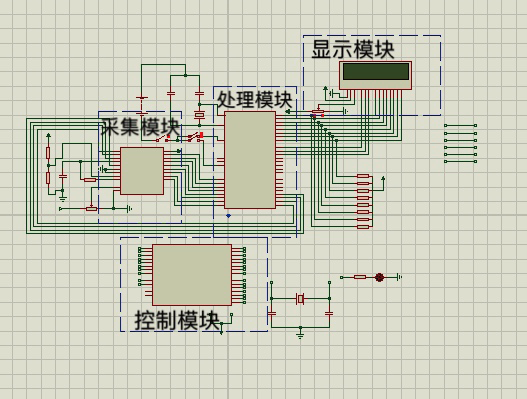

显示模块是在数据采集处理后再进行的,通常显示平台为LCD 显示屏。该系统通过显示模块可显示目标车辆具体信息,可显示由数据采集模块被车辆遮挡的盲区图像和目标车辆的行驶参数。对系统模块的部分功能利用Proteus 进行电路设计如图2 所示。

图2 电路设计图

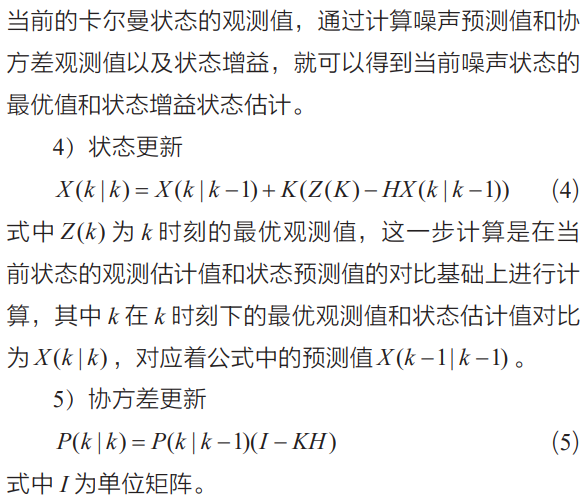

整个过程主要包括五个方面的计算:

1)状态预测

![]() (1)

(1)

其中,X (k −1| k −1)是利用上一时刻所在状态预测得到的最优化结果,这一步实际是更新系统结构。

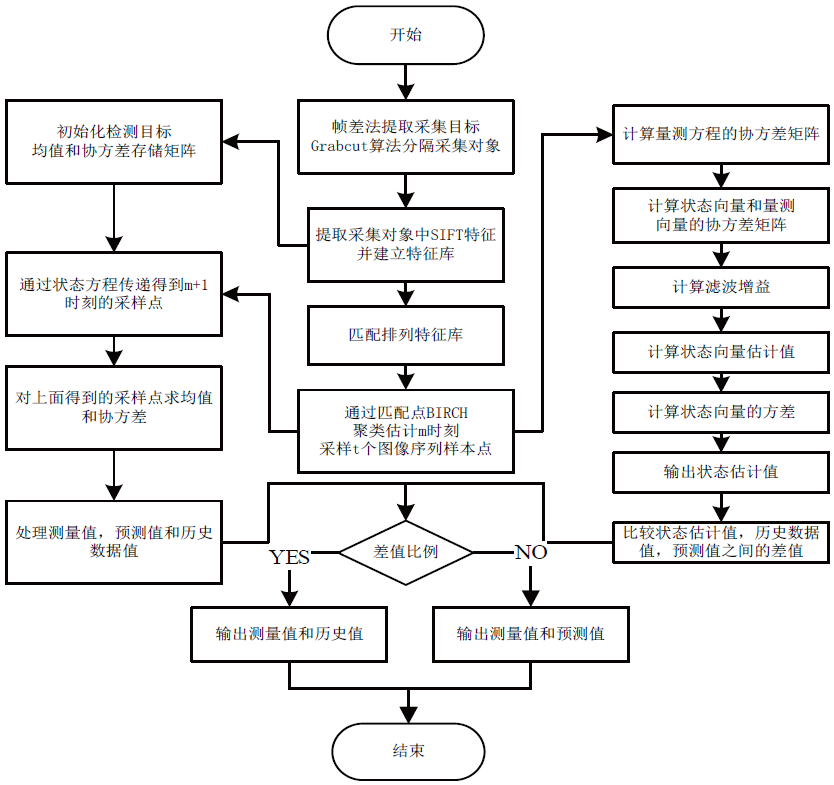

本系统算法流程如图3 所示,通过算法估计进一步预测目标车辆位置进行跟踪,可在测量方差已知的情况下去估计运动目标的状态。首先利用帧差法提取采集目标即目标车辆并利用Grabcut算法进行图像分割,然后提取采集车辆中的SIFT 特征并建立特征库,初始化检测车辆的均值和协方差存储矩阵。建立特征库后进行匹配排列再通过聚类估计某时刻的序列样本点,一方面通过状态方程得到下一时刻的样本点并依次计算出均值和协方差,另一方面计算量测方程的协方差矩阵并依次计算滤波增益、状态向量估计值、状态向量的方差,然后输出状态估计值。对两个方向的测量值、预测值、历史数据值进行处理,最后通过比较差值比例选择合适的输出值。

图3 系统算法流程图

目标车辆在行驶过程中,摄像头角度位置不会发生变化,则每一帧图片中的位置都不相同,则对当前所在帧和下一帧的图像进行差分运算,提取目标车辆所有数据信息,其流程如图 4 所示。算法按过程分为图像初始化的过程和迭代的过程。此算法在系统中利用Grabcut切割算法对采集对象的像素点即目标车辆进行图像分割。系统初始化图像分割完成后,进入迭代分割区,系统对迭代区域中未知分割像素点的能量值进行重新分配。

图4 帧差法提取采集对象

首先对目标车辆的SIFT特征进行提取并建立特征库,然后匹配排列特征库,再进行聚类估计序列样本点。针对两个时刻对目标车辆跟踪进行比较选择。首先,计算m时刻样本点的量测方程的协方差矩阵、状态向量和量测向量的协方差矩阵、滤波增益、状态向量估计值和状态向量的方差。再者通过初始化目标车辆存储历史数据和协方差矩阵,得到并计算m+1时刻样本点的均值和协方差。最后处理两个时刻得到的测量值、预测值和历史数据值,对预测值、历史数据值、测量值三者之间的差值进行比例分析。若差值比例高,输出测量值和历史值;若差值比例不高,则输出测量值和预测值。

2 结束语

本文主要研究了复杂环境下如何对车辆进行跟踪和检测,本文首先对国内外研究现状做出了大量研究,分析了实现车辆跟踪检测的研究意义,然后介绍了车辆跟踪中常用的一些算法,并在此基础上针对车辆跟踪中的难点进行相应的算法改进。针对车辆在跟踪过程中容易发生“姿态变化”导致跟踪难以实现,本文引入SIFT算法提取目标特征点,为保证SIFT 所提取的兴趣点位于图片前景,利用Grabcut 算法对图片进行背景分离处理,此外加入BIRCH 算法实现目标车辆的聚类估计。本课题后续研究的内容将准备在如下方面继续深入研究,一是在使用SIFT 算法提取目标特征点的基础上,进一步引入车辆自身特征进行深层次分析。二是在日常生活中,摄像头多是可以变换拍摄角度的,利用这类摄像头实现车辆动态跟踪更为困难,这也是本课题后期将拓展研究的地方。

参考文献:

[1] 程腾, 等. 一种基于数字图像相关的高精度车辆跟踪算法[J]. 汽车工程, 2018, 40(8): 942-946,980.

[2] 侯潇潇. UKF和小波变换结合的车辆跟踪算法的研究[D]. 淮南:安徽理工大学, 2017.

[3] 吴宁强, 等. 重载AGV车辆跟踪算法和运动特性研究[J]. 重庆理工大学学报(自然科学版), 2018, 32(10): 53-57.

[4] 宋国浩. 基于机器视觉的智能车辆跟踪方法研究与应用[D]. 太原:中北大学, 2017.

[5] 施毅等. 基于时空马尔可夫随机场模型的车辆跟踪算法研究[J].土木工程学报, 2007, 40(1): 74-78.

[6] 林明秀, 刘伟佳, 徐心和. 基于模板匹配的多模式车辆跟踪算法[J]. 系统仿真学报, 2007, 19(7): 1519-1522.

[7] 周俊静, 段建民, 杨光祖. 基于改进的确定性目标关联的车辆跟踪方法[J]. 模式识别与人工智能, 2014(1): 89-95.

[8] 袁基炜, 史忠科. 一种基于灰色预测模型GM(1,1)的运动车辆跟踪方法[J]. 控制与决策, 2006(3): 300-304.

[9] 郭新新. 基于粒子滤波的车辆跟踪算法研究[D].济南:山东师范大学, 2018.

[10] 顾鹏笠. 基于机器学习的车辆跟踪与道路场景理解研究[D]. 杭州:浙江科技学院, 2019.

[11] 陈梦. 基于深度学习的车辆跟踪的研究[D]. 南京:南京邮电大学, 2018.

[12] 卜旭辉,等. 基于迭代学习的农业车辆路径跟踪控制[J]. 自动化学报, 2014, 40(02): 368-372.

[13] 张帅领. 基于TLD的视频目标跟踪算法的研究[D]. 西安:西安电子科技大学, 2014.

[14] 李敏敏. 基于TLD模型的目标跟踪方法[D]. 西安:西安电子科技大学, 2013.

[15] 权义萍,等. 基于Mean-Shift的卡尔曼粒子滤波车辆跟踪算法研究[J]. 计算机应用与软件, 2014(9): 236-239,252.

[16] 李文辉, 陈昱昊, 王莹. 自适应的免疫粒子滤波车辆跟踪算法[J]. 吉林大学学报(理学版), 2016, 54(5): 1055-1063.

[17] 范玉贞, 李海军. 基于改进分水岭算法的多目标车辆的跟踪研究[J]. 电子世界, 2013(3): 1-2.

[18] 李娟. 基于数据融合的危险驾驶行为识别与车辆跟踪算法研究[D]. 武汉:武汉工程大学, 2017.

[19] 纪筱鹏, 魏志强. 基于轮廓特征及扩展Kalman滤波的车辆跟踪方法研究[J]. 中国图象图形学报A, 2011, 16(2): 267-272.

[20] 童宝锋. 基于视觉传感器的前方车辆跟踪定位方法研究[D]. 长春:吉林大学, 2014.

[21] 杨敏,等. 一种基于运动目标检测的视觉车辆跟踪方法[J]. 北京理工大学学报, 2014, 34(4): 370-375.

[22] KOLLNIG H, H H NAGEL, M OTTE. Association of motion verbs with vehicle movements extracted from dense optical flow fields[A]. Computer Vision - ECCV’94, Third European Conference on Computer Vision, Stockholm, Sweden, May 2-6, 1994, Proceedings, Volume II[C]. 1994.