IT之家 3 月 19 日闪讯速报,发布最强 AI 加速卡--Blackwell GB200,今年发货。

本文引用地址:在今天召开的 GTC 开发者大会上,正式发布了最强 AI 加速卡 GB200,并计划今年晚些时候发货。

GB200 采用新一代 AI 图形处理器架构 Blackwell,黄仁勋在 GTC 大会上表示:“Hopper 固然已经非常出色了,但我们需要更强大的 GPU”。

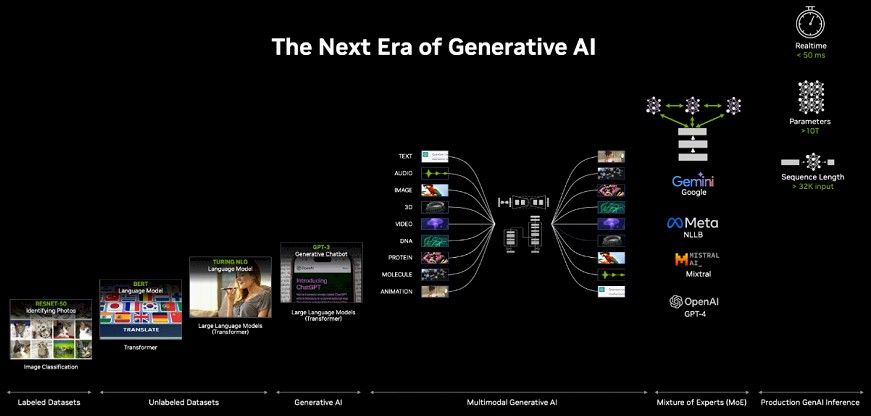

目前按照每隔 2 年的更新频率,升级一次 GPU 架构,从而大幅提升性能。英伟达于 2022 年发布了基于 Hopper 架构的 H100 加速卡,而现在推出基于 Blackwell 的加速卡更加强大,更擅长处理 AI 相关的任务。

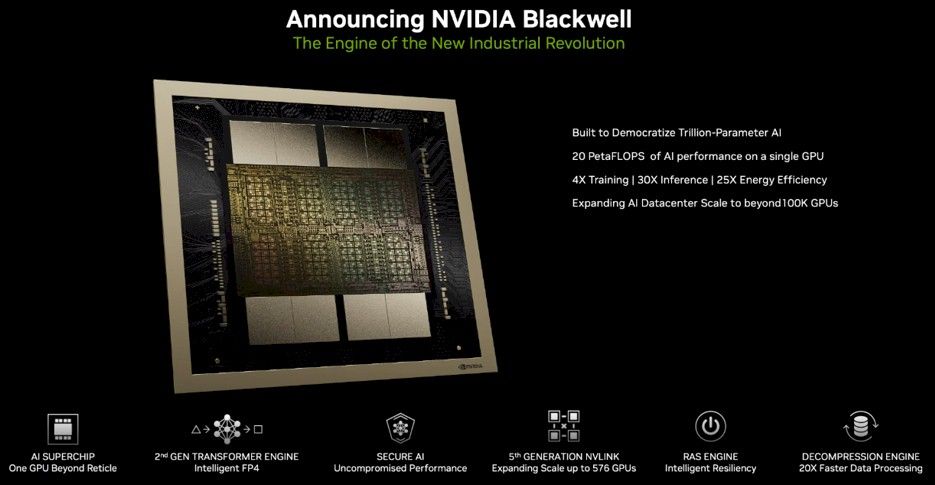

Blackwell GPU

黄仁勋表示,Blackwell 的 AI 性能可达 20 petaflops,而 H100 仅为 4 petaflops。Nvidia 表示,额外的处理能力将使人工智能公司能够训练更大、更复杂的模型。

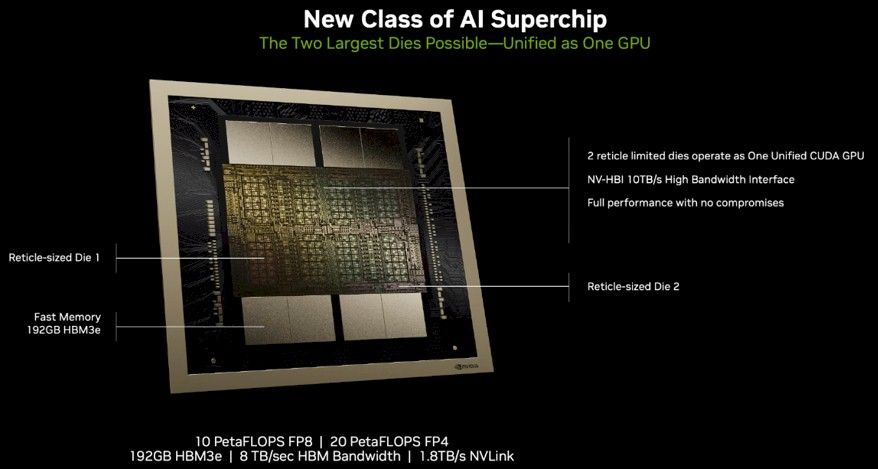

Blackwell GPU 体积庞大,采用台积电的 4 纳米(4NP)工艺蚀刻而成,整合两个独立制造的裸晶(Die),共有 2080 亿个晶体管,然后通过 NVLink 5.0 像拉链一样捆绑芯片。

英伟达表示每个 Blackwell Die 的浮点运算能力要比 Hopper Die 高出 25%,而且每个封装中有两个 Blackwell 芯片,总性能提高了 2.5 倍。如果处理 FP4 八精度浮点运算,性能还能提高到 5 倍。取决于各种 Blackwell 设备的内存容量和带宽配置,工作负载的实际性能可能会更高。

英伟达使用 10 TB / sec NVLink 5.0 连接每块 Die,官方称该链路为 NV-HBI。Blackwell complex 的 NVLink 5.0 端口可提供 1.8 TB / 秒的带宽,是 Hopper GPU 上 NVLink 4.0 端口速度的两倍。

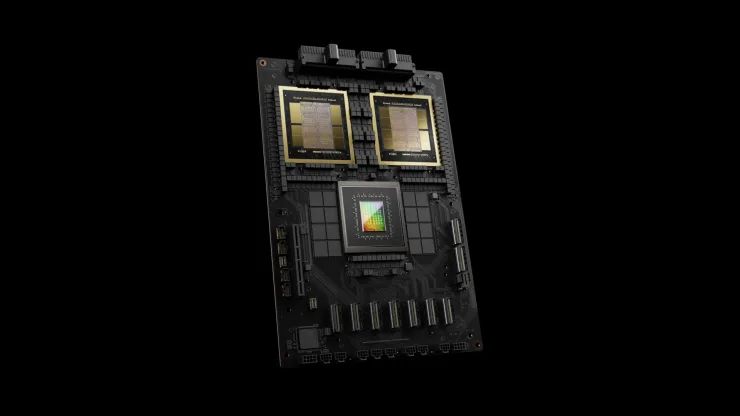

GB200

英伟达表示 GB200 包含了两个 B200 Blackwell GPU 和一个基于 Arm 的 Grace CPU 组成,推理大语言模型性能比 H100 提升 30 倍,成本和能耗降至 25 分之一。

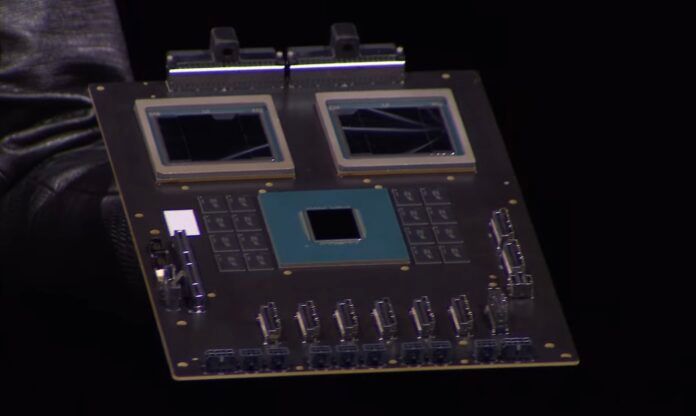

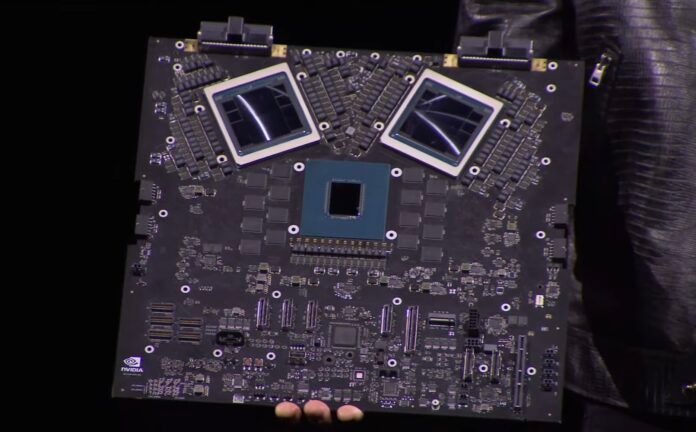

NVIDIA Grace Blackwell 生产板

NVIDIA Grace Blackwell 开发板

IT之家援引英伟达官方报告,训练一个 1.8 万亿个参数的模型以前需要 8000 个 Hopper GPU 和 15 兆瓦的电力。如今,Nvidia 首席执行官表示,2000 个 Blackwell GPU 就能完成这项工作,耗电量仅为 4 兆瓦。

在参数为 1,750 亿的 GPT-3 LLM 基准测试中,Nvidia 称 GB200 的性能是 H100 的 7 倍,而训练速度是 H100 的 4 倍。

英伟达还面向有大型需求的企业提供成品服务,提供完整的服务器出货,例如 GB200 NVL72 服务器,提供了 36 个 CPU 和 72 个 Blackwell GPU,并完善提供一体水冷散热方案,可实现总计 720 petaflops 的 AI 训练性能或 1,440 petaflops(又称 1.4 exaflops)的推理性能。它内部使用电缆长度累计接近 2 英里,共有 5000 条独立电缆。

机架上的每个托盘包含两个 GB200 芯片或两个 NVLink 交换机,每个机架有 18 个 GB200 芯片和 9 个 NVLink 交换机,英伟达称,一个机架总共可支持 27 万亿个参数模型。而作为对比,GPT-4 的参数模型约为 1.7 万亿。

该公司表示,亚马逊、谷歌、微软和甲骨文都已计划在其云服务产品中提供 NVL72 机架,但不清楚它们将购买多少。

英伟达表示亚马逊 AWS 已计划采购由 2 万片 GB200 芯片组建的服务器集群,可以部署 27 万亿个参数的模型。

Nvidia 也乐于为公司提供其他解决方案。下面是用于 DGX GB200 的 DGX Superpod,它将八个系统合而为一,总共拥有 288 个 CPU、576 个 GPU、240TB 内存和 11.5 exaflops 的 FP4 计算能力。

英伟达称,其系统可扩展至数万 GB200 超级芯片,并通过其新型 Quantum-X800 InfiniBand(最多 144 个连接)或 Spectrum-X800 以太网(最多 64 个连接)与 800Gbps 网络连接在一起。

英伟达目前并未公布 GB200 以及整套方案的售价信息。