现在各大车企在智能辅助驾驶方面宣传尤为看种,不少的用户也是从中得知了摄像头、毫米波雷达、激光雷达等名词,但其实际怎么运转,有何作用,又有什么优劣,大家也是一无所知,今天梳理如下:

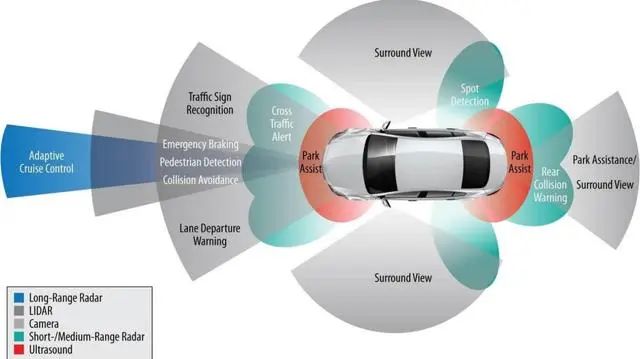

目前汽车中使用的传感器主要是雷达、LiDAR和摄像头。它们各有长短,用处不同。这些传感器协同工作,提供外部世界车辆、行人、骑自行车的人、标志等原始数据,其重叠功能会产生冗余(图中颜色重叠部分),确保一个系统出现故障时,另一个系统继续运行。

ADAS完整愿景将融合多种RF技术和立体视觉等传感器,形成一个完整的360°数字处理环境。

01

毫米波雷达

毫米波雷达是一种使用毫米波段进行测距、探测、跟踪、成像的主动传感器。它可主动发射电磁波,穿透烟尘,几乎不受光线和天气影响,帮助车辆实时感知周围物体并提供较为准确的距离和速度信息。

毫米波雷达里,77GHZ毫米波雷达是智能汽车上必不可少的关键部件,是能够在全天候场景下快速感知0-200米范围内周边环境物体距离、速度、方位角等信息的传感器件。那么它是如何计算被监测目标的位置、速度和方向的呢?

1、位置

毫米波雷达通过发射天线发出相应波段的有指向性的毫米波,当毫米波遇到障碍目标后反射回来,通过接收天线接收反射回来的毫米波。根据毫米波的波段,通过公式计算毫米波在途中飞行的时间&TImes;光速÷2,再结合前车行驶速度和本车的行驶速度因素,就可以知道毫米波雷达(本车)和目标之间的相对距离了,同时也就知道目标的位置。

2、速度

此外,根据多普勒效应,毫米波雷达的频率变化、本车及跟踪目标的相对速度是紧密相关的,根据反射回来的毫米波频率的变化,可以得知前方实时跟踪的障碍物目标和本车相比的相对运动速度。因此,表现出来就是,传感器发出安全距离报警时,若本车继续加速、或前监测目标减速、或前监测目标静止的情况下,毫米波反射回波的频率将会越来越高,反之则频率越来越低。

3、方位角

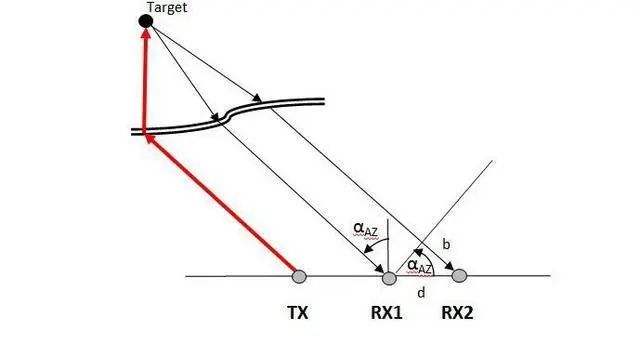

关于被监测目标的方位角测量问题,毫米雷达的探测原理是:通过毫米波雷达的发射天线发射出毫米波后,遇到被监测物体,反射回来,通过毫米波雷达并列的接收天线,通过收到同一监测目标反射回来的毫米波的相位差,就可以计算出被监测目标的方位角了。原理图如下:

方位角αAZ是通过毫米波雷达接收天线RX1和接收天线RX2之间的几何距离d,以及两根毫米波雷达天线所收到反射回波的相位差b,然后通过三角函数计算得到方位角αAZ的值,这样就可以知道被监测目标的方位角了。

位置、速度和方位角监测是毫米波雷达擅长之处,再结合毫米波雷达较强的抗干扰能力,可以全天候全天时稳定工作,因此毫米波雷达被选为汽车核心传感技术。

但是,毫米波雷达的感知精度并不理想,不具备图像级的成像能力。因为毫米波雷达是利用在目标物体表面的反射、漫反射和散射来进行目标检测和跟踪,所以对于像行人、动物、自行车这一类低反射率的目标,探测准确度也会大打折扣,路面上的静态物体也可能被当成杂波过滤掉了。

另外,4D毫米波雷达其实也是毫米波雷达的一种,并非什么新物种。相比传统 3D 毫米波雷达而言,4D 毫米波多加了一个高度信息,但是分辨率相比激光雷达来说还是有很大差距。

目前市场上的4D 毫米波雷达每帧约输出 1000 多点,而一个 128 线激光雷达每帧输出可达十几万点,二者输出的数据量相差了 2 个数量级之多。

02

激光雷达

激光雷达也是一种主动传感器,最常见的ToF (Time of Flight) 测距法,就是通过主动发射激光光束,并测量他们与周围物体反射往返的时间来确定距离和位置。激光雷达通过向外界发出每秒数百万个激光点,可以获取到这些点的三维定位信息,清晰呈现出行人、斑马线、车辆、树木等物体细节,达到图像级分辨率。而且,激光点越密集,分辨率就越高,越能完整且清晰地重构真实世界。

由于其“主动发光”的特性,激光雷达受周围环境光线变化的影响非常小,在一片漆黑的夜间环境也能够“精准洞察”。此外,激光雷达能够直接获取到物体的体积和距离,不像摄像头要靠“猜”,因此针对小型、异形障碍物的检测,应对近距离加塞、隧道、车库等复杂场景,都会有更好的发挥。不过,激光雷达的性能在大雨、雪、雾等极端天气下也会受到一定程度的影响。

真实点云图

LiDAR是通过多个旋转(物理或通过逻辑)的激光器来实现的,以360度视野扫描车辆周围环境。在自动驾驶发展史上,LiDAR一直是一项重要的传感技术。开创性的自动驾驶原型依靠LiDAR实现了精确的距离测量、可靠性和易用性。

例如,2004年开始的由美国国防部高级研究计划局(DARPA)赞助的自动驾驶挑战赛中,大多数参赛者都依赖LiDAR技术。LiDAR没有辜负人们的期望,优势显而易见,包括:

高精度(测量精度达到厘米级)

高数据速率(机械式旋转LiDAR每秒旋转20转以上)

经验证稳定可靠

感测效果不受温度和光照的影响

尽管LiDAR有诸多优点,但也确实有一定的技术局限性:

在雨、雾和灰尘等恶劣天气条件下会因反射造成误报。专用算法处理可能解决这些问题,但比较复杂

眼睛安全条例对LiDAR的信号强度有所限制,使分辨率限制了视场和视场之间的距离

LiDAR测量的有效性与物体的反射率有关。如果信号遇到反射性差的障碍物,如黑色车辆,信号的能量只返回很小一部分,因此感测的可靠性会降低。幸运的是,大多数交通参与者都有足够的反射能力,所以LiDAR在的应用相当广泛。

03 摄像头

摄像头是最常见的汽车传感器,装在车身四周可以从多角度捕捉环境图像,在90 年代就已开始进入商用并逐渐普及。它也是最接近人眼的传感器,能够获取到丰富的色彩和细节信息,比如车道线,指示标志,红绿灯等等。

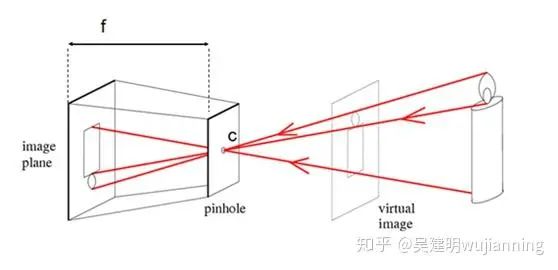

摄像头单目测距原理及实现:

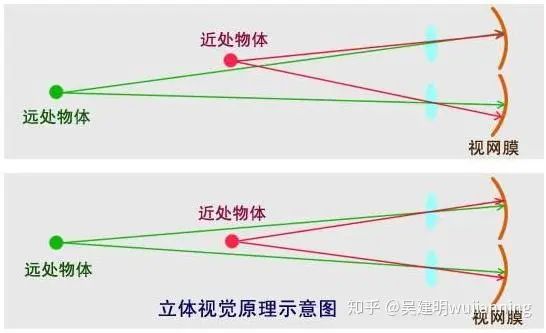

人的眼睛长在头部的前方,两只眼的视野范围重叠,两眼同时看某一物体时,产生的视觉称为双眼视觉。双眼视觉的优点是可以弥补单眼视野中的盲区缺损,扩大视野,并产生立体视觉。也就是说,假如只有一只眼睛,失去立体视觉后,人判断距离的能力将会下降。这也就是单目失明的人不能考取驾照的原因。

单纯的单目视觉测距,必须已知一个确定的长度。

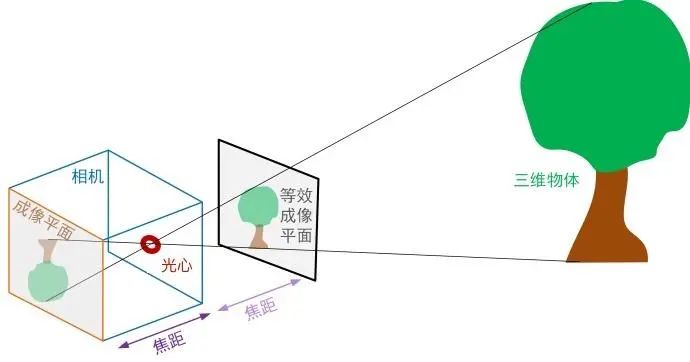

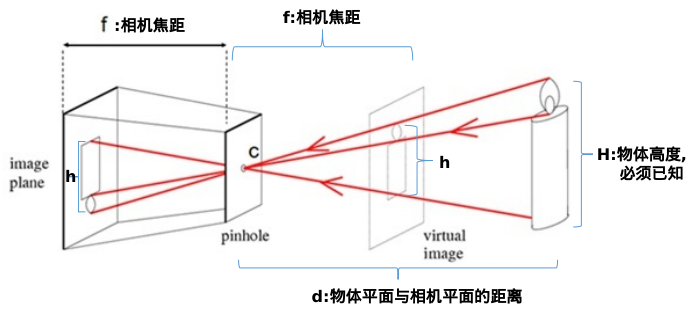

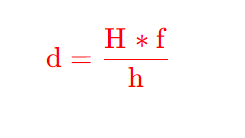

f为摄像头的焦距,c为镜头光心。物体发出的光经过相机的光心,然后成像于图像传感器或者也可以说是像平面上,如果设物体所在平面与相机平面的距离为d,物体实际高度为H,在传感器上的高度为h,H一定要是已知的,我们才能求得距离d。

下面的相机焦距f并不是透镜的焦距,而是焦距+z0,这个我们必须要清楚。因为成像是在像平面,并不是成像在焦平面,焦平面的距离才是f,但是我们下面的模型不需要知道实际的f,所以就使用了像平面的距离焦距f+z0作为相机焦距f。

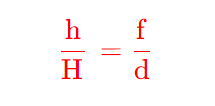

由相似三角形,可以得到:

同时,摄像头其局限性也非常明显,如果遇到会暗光、逆光等影响“视线”的情况,摄像头也会像人眼一样看不清从而丢失目标。

第一步,求相机焦距:

对于蜡烛,我们可以:

1.测量蜡烛的高度 H 作为先验知识;

2.测量蜡烛到相机光心的距离 d;

3.通过相机拍摄的这一帧蜡烛图像,可以得到蜡烛在图像中的高度所占像素个数 h ;

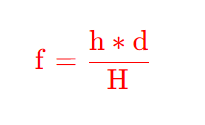

知道三个量,就可以求出相机的焦距f,即:

需要注意,相机的焦距是个固定值,只要使用该方法求出焦距后,以后就不用再求了。但是,可能需要多次测量求平均值。

第二步,求物体距离相机的实际距离:

得到了相机焦距f ,对于放在其他位置的任意物体,就可以根据:

1.该物体的先验值高度 H ;

2.统计出该物体在该帧图像中的高度所占像素个数 h ;

3.前面求出来的相机焦距固定值 f ;

得到物体距离相机的实际距离d :

出隧道时的逆光可能会让摄像头“致盲”

出隧道时的逆光可能会让摄像头“致盲”

同时,视觉感知技术的核心在于通过软件算法去解析高密度的信息,也就是通过“识别”这些物体并“估测”它们的距离。如果遇到一些“不认识”的物体,比如道路上的异形障碍物等,可能会因为无法全面而准确地感知,从而导致系统做出错误的决策。

也正因如此,仅基于摄像头的智能驾驶方案大多停留在L2 阶段,涉及 L3 级别以上的自动驾驶功能仍存在许多 corner case 无法完美解决。这时,就需要其他传感器来进行“互补”。

04

雷达、LiDAR和摄像头孰优孰劣?

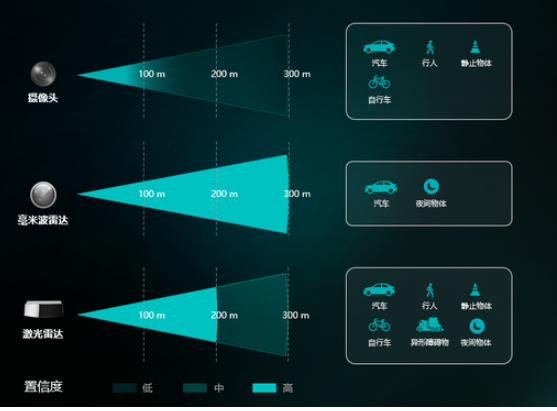

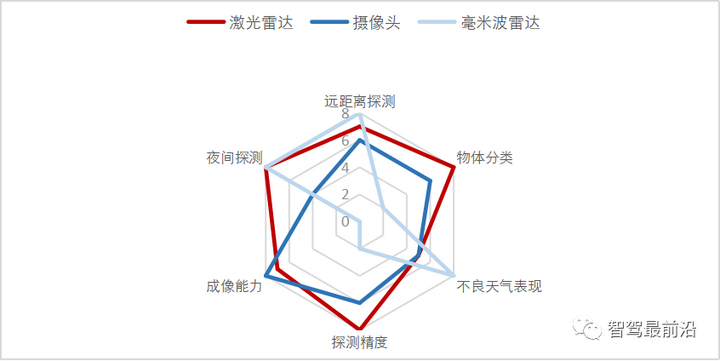

其实摄像头、毫米波雷达、激光雷达这三种智能汽车上最常见的传感器,各有优缺点。但三个传感器叠加在一起,就能发挥更大的作用。

摄像头是被动传感器,能识别丰富的色彩信息,但受光线影响显著,在一些光线不好的环境下置信度相对较低。毫米波雷达的置信度高,但因分辨率较低,能够识别出的物体类型较少,无法有效感知行人、自行车或更小的物体。激光雷达不论是从测距能力、置信度、可感知物体细节,综合实力都很出色,可能最大的缺点,就是有点“贵”。

但毫无疑问的是,激光雷达的成本正在迅速降低,越来越多的汽车厂商已经将激光雷达集成至了量产车型中,提升智能驾驶系统的安全性与舒适性。随着芯片化技术在不断进化,激光雷达的元器件数量已大幅减少,而且自动化产线的效率上升,也有助于生产成本的下降。激光雷达已经从几年前的百万元级别,降至了目前的几千元级别,成为普通消费者也能用上的“汽车黑科技”。

最后回归到用户需求,一个智能驾驶系统是不是“好用”,还是用户说了算。在感知层面,传感器各有长短版,如何让它们更好地“各司其职”,发挥各自最大的优势才是关键。随着智能驾驶软件能力的不断迭代,相信未来也会逐渐“解锁”更多的硬件潜力,进而赋予消费者更丝滑、更舒适的智驾体验。