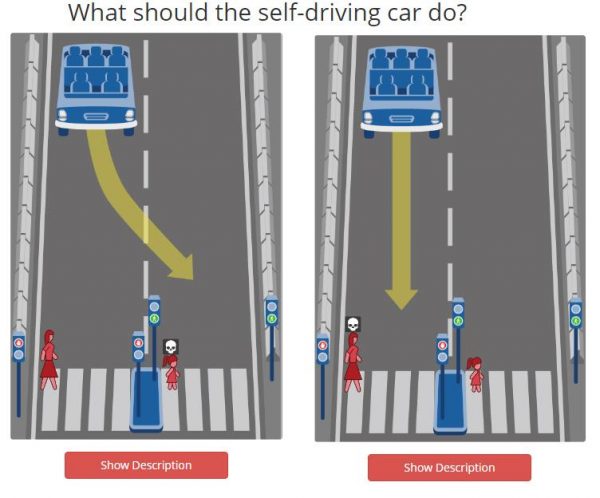

如果你能设定自动驾驶系统,当自动驾驶车煞车失灵时,会选择撞上路人还是路障?又或者,你会选择撞上小孩还是老人?麻省理工学院(MIT)Media Lab 发布线上测验“Moral Machine”,让人选择在不同情境下,煞车失灵的自动驾驶车应该撞上哪一侧,希望当自动驾驶车面临生死攸关的两难抉择时,能做出更具有人性的选择。

▲ 你会选择撞上一群小孩(左),还是撞上一群老人(右)?(Source:MIT Moral Machine)

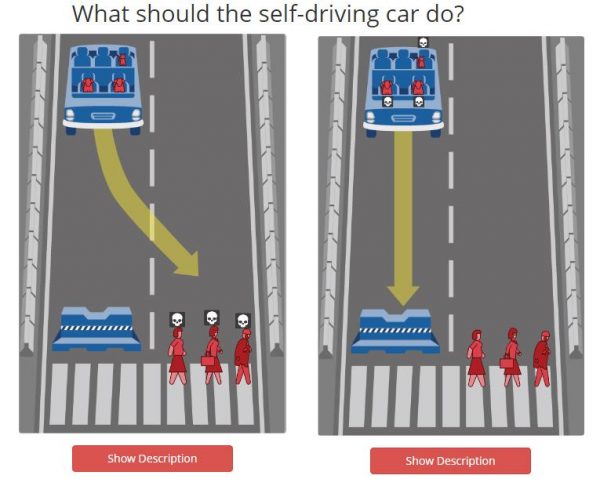

在测验中,自动驾驶车可选择直行或转弯,不过不论选择哪种都会造成死亡,可能是乘客、路人或动物。测验中也将人细分为男女、小孩或老人、身材胖或瘦、动物或人类、罪犯或守法人士、社经地位高或低等,这些都会影响判断,人数多寡也列入考虑。

▲ 你会选择撞上闯红灯的成人(左),还是撞上一名守法的儿童(右)?(Source:MIT Moral Machine)

▲ 你会选择撞上 3 名路人(左),还是选择直行让车内的动物死亡(右)?(Source:MIT Moral Machine)

最后,测验会将个人结果和其他人的平均结果比较,看你的道德观是否和其他人相仿。结果显示,比起男性,多数参与调查的人会倾向救女性;比起动物,更倾向救人类;比起老人,更倾向救年轻人;比起窃盗,更倾向救社经地位更高的人;不过当面临该救乘客还是行人的问题时,结果显示各半。

▲ 测验结束可和其他人的测验结果相比。(Source:MIT Moral Machine)

MIT 在结果页面下方提醒,这份测验只是参考用,“我们的目标不是去评断任何人,而是希望帮助反映出大众对重要且困难的议题态度为何。”

多数人希望自动驾驶车可将伤亡减到最低,但却希望他们的汽车不计成本来保护他们。MIT 教授 Iyad Rahwan

过去,Gizmodo 曾报导,尽管多数人希望自动驾驶车应该预设为“尽可能减低伤亡人数”,不过,当询问自己是否愿意搭乘这种自动驾驶车时,多数人却不愿意。进行这份调查的 MIT 教授 Iyad Rahwan 表示:“多数人希望自动驾驶车可将伤亡减到最低,但却希望他们的汽车不计成本来保护他们。”

或许这项测验现在看来像是个小游戏,但在自动驾驶车普及的将来,自动驾驶系统的程序码就是判断行人或乘客的生命孰轻孰重的依据。道德议题对人类来说始终是难解的问题,尤其当生死攸关时更是如此,而这却是自动驾驶系统开发者需要正视的问题。

- MIT wants humans’ input on who self-driving cars should kill

- Should a Self-Driving Car Kill Two Jaywalkers or One Law-Abiding Citizen?

(本文由 数码时代 授权转载;首图来源:Pixabay)

如需获取更多资讯,请关注微信公众账号:半导体行业观察

相关文章

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服