ChatGPT引发的AI大模型概念已经持续火爆一年,直至今日,AI的热度不仅没有下降,行业也迸发出越来越多具有颠覆性的应用。2024年初以来,AI PC、AI手机、AI边缘等产品相继开售,过年期间,Sora又引发了大规模讨论。

可以说,AI领域,永远都在革新。但随着大模型对算力需求的高速增长,现阶段生产的芯片很难满足业界需求。

在AI热潮之中,GPU、AISC等加速器是行业中的主角。而事实上,任何数据中心都无法脱离CPU,比喻起来就是鱼和水的关系。去年12月,英特尔第五代至强可扩展处理器(代号为Emerald Rapids)正式面世,它有着许多令人惊喜的AI秘籍。

做AI,只有一个选择?

众所周知,面对大模型这一新风口,全球科技公司均将目光投向了AI芯片,特别是GPU。但GPU的产量与HBM,或者说2.5D封装能力直接挂钩。这让本就供应吃紧的GPU再遇瓶颈,导致供需严重失衡。

与之相悖的是,眼下AI大模型“拼杀”的关键在于做大参数量,用“力大砖飞”实现更为强大的智能涌现。可以说,即便是面对AI芯片涨价,多少公司也会选择购买,毕竟错过这个风口,或许就会失去竞争力。

对于大型数据中心来说,每颗芯片都在牟足力气,全功率地运行着,如果能拥有更多AI性能,那么,还需要额外购置一批GPU吗?

事实上,我们都陷入了一种思维定势,其实跑AI并非只有GPU一个选择,CPU也已经具备很强大了AI性能。

亚信科技就在自家OCR-AIRPA方案中采用了CPU作为硬件平台,实现从FP32到INT8/BF16的量化,从而在可接受的精度损失下,增加吞吐量并加速推理。将人工成本降至原来的五分之一到九分之一,效率还提升5~10倍。

被改变的,不只是互联网和通信领域,AI制药被看作是终结药物研发“双十定律”的希望,在这个领域中AlphaFold2 这类大型模型被视为最重要的算法。去年开始,至强可扩展平台就开始使AlphaFold2端到端的通量提升到了原来的23.11倍,而第四代可扩展处理器让这个数值再次提升3.02倍。

可以说,将CPU用于AI推理正在不断证实可行。而现在,第五代至强可扩展处理器能够在无需添加独立加速器的前提下,运行高达200亿参数的模型推理,且延迟低于100毫秒。一款为AI加速而生,且表现更强的处理器诞生了。

CPU,怎么让AI跑起来

很多人会奇怪,为什么第五代至强作为一个通用处理器,能够运行AI负载?事实上,除了本身落在第五代至强的AI负载,其中内置的一系列的加速器是关键。

这种设计可以与时下MCU(单片机)的流行做法进行对比,通过内置DSP、NPU,分走一部分部分AI负载,让AI任务跑得更高效,从而更省电,至强也是类似的原理。

这种设计在早期的至强可扩展处理器中就出现过,只不过,那时候大家没有过多关注,也没有那么AI任务需要跑。

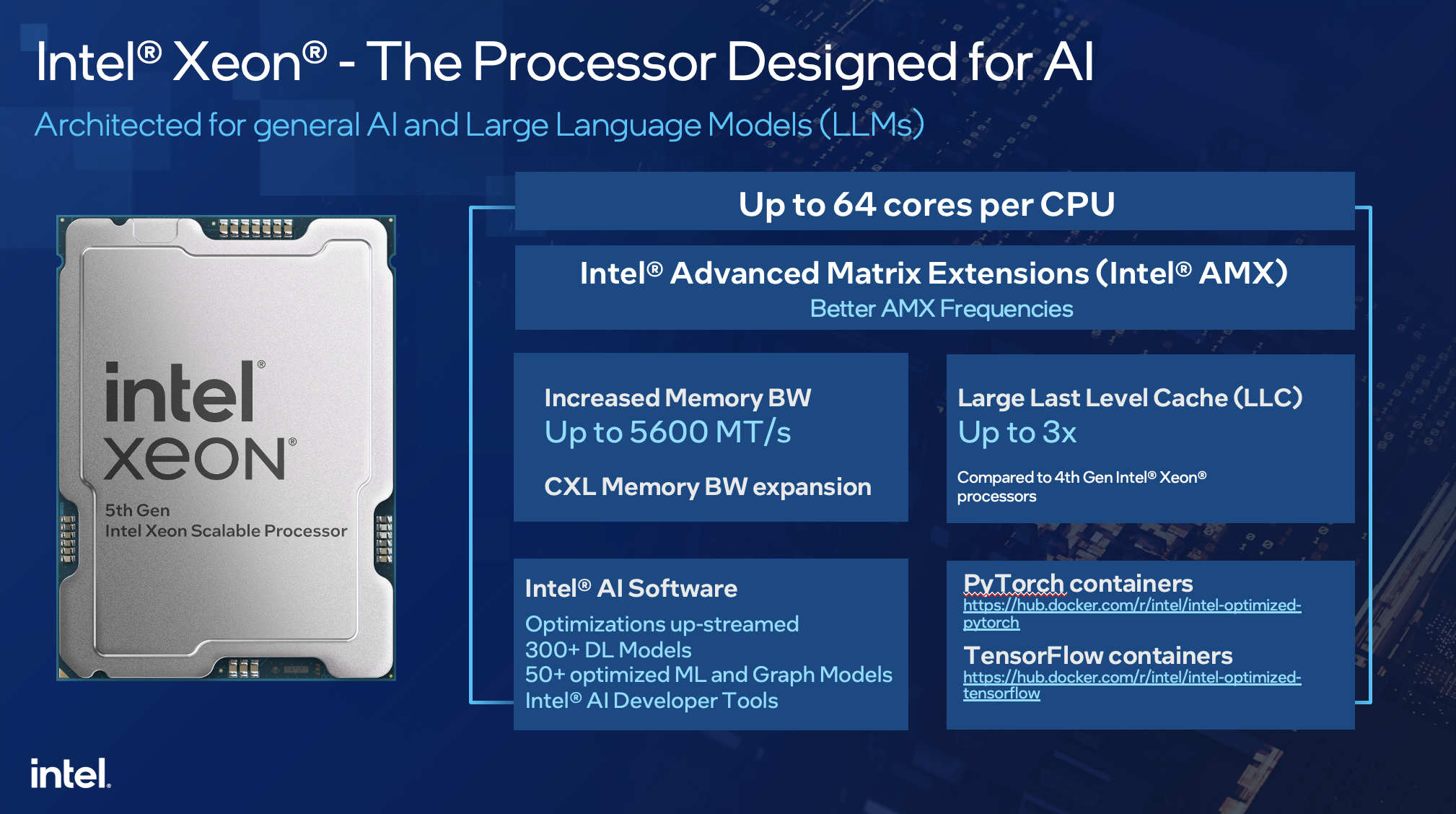

具体看第五代至强,其内置的英特尔AVX-512及英特尔® AMX(英特尔®高级矩阵扩展)功能是关键,这两个加速器在第四代至强中就已搭载,而在第五代至强中,AMX支持新的FP16指令,同时混合AI工作负载性能提高2~3倍。

加之第五代至强本身性能的提升,使其本身性能就能更从容应对AI负载:CPU核心数量增加到64个,单核性能更高,每个内核都具备AI加速功能;采用全新I/O技术(CXL、PCIe5),UPI速度提升。

根据行业人士分析,CPU做大模型推理,最大的难点不在计算能力,而在内存带宽。第五代至强的内存带宽从4800 MT/s提高至5600 MT/s,三级缓存容量提升至近3倍之多,同时插槽可扩展性,支持从一个插槽扩展至八个插槽,这些都为第五代至强支持大模型提供了坚实的后盾。

从数据上来看,与上一代产品相比,第五代至强相同热设计功耗下平均性能提升21%;与第三代产品比,平均性能提升87%。相较于前一代产品,第五代至强不仅迭代了性能,还带来了42%的AI推理性能提升。

此外,在一系列加速器中,英特尔®可信域拓展(英特尔® TDX)提供虚拟机(VM)层面的隔离和保密性,从而增强隐私性和对数据的管理。

不止如此,第五代至强还是迄今为止推出的最“绿色”的至强处理器,它能够帮助用户管理能耗,降低碳足迹。可以说,软件只是一方面,归功于第五代至强内的多种创新技术和功能,搭配干活,效率更高,最终体现出来的就是更低的功耗。

CPU未来发展趋势,一定是拼功耗,这需要全方位发力。首先是工艺,随着工艺逐渐提升到Intel 3、Intel 20A、Intel 18A,功耗会越来越低,每一代都会有两位数的功耗降低。封装也一样,使用先进的封装技术把不同制程的芯片通过Chiplet架构放在一起,进行一个运算,并不需要把所有地方都用起来,而是只使用对应的区域,这样功耗自然就降低了。还有,就是针对不同的工作负载做优化。

有时候调整应用程序的架构也可以最大限度地降低功耗。举例来说,如果要训练大模型,假设总共有20个大模型,每个模型的训练周期为3个月,需要1000台机器来训练,每台机器功率为1万瓦。如果规定只需训练其中的5个模型,而剩下的15个模型不需要训练,这样就能节省75%的电能。因此,有时候通过调整应用程序的架构,可以更有效地降低功耗。

“随着算力的持续高速发展,如何实现数据中心的节能减碳,改变‘电老虎’的形象,对寻求采用可再生能源和更环保的技术方面有了更高的需求。”英特尔数据中心与人工智能集团副总裁兼中国区总经理陈葆立对AI大模型时代提出了这样的担忧,第五代至强就是节能减碳的关键。

与此同时,英特尔也有一系列的产品和技术创新,如通过更高效的冷却技术、智能能源管理系统等推动新型和存量数据中心进行节能减排,并携手中国合作伙伴推动应用落地。

英特尔如何支撑起AI开发

GPU的发展,软件生态也起到了至关重要的作用,比如行业无人不知的CUDA。对英特尔来说,软件一直以来都是强项,与此同时,英特尔发力软件堆栈,不断加大投资,这为第五代至强在AI方面的发展带来了巨大的天然优势。

英特尔一直以来,都比较强调统一性和易用性,在AI方面亦如如此。开发者可以通过利用OpenVINO,实现“一次编写,随处部署”的愿景。英特尔开发的基础软件和数据库通过Pytorch和ONNX Runtime等流行框架支持自身的 CPU、GPU、IPU和AI加速器。

此外,英特尔还提供了PyTorch和TensorFlow的库扩展,这将有助于开发者使用默认安装运行这些扩展以获得最新的软件加速。这意味着,用户既可以继续使用PyTorch或TensorFlow,也可以利用OpenVINO进行开发,掌握不同语言的开发者都能在同样一个平台下开发。

值得一提的是,OpenVINO 2023.1版本正在加速英特尔追求的“任何硬件、任何模型、任何地方”的目标实现,即逐步扩展OpenVINO成为跨客户端与边缘端的、针对推理与部署运行AI模型的完整软件环境。

“我认为ChatGPT技术不仅仅是关于人类语言、英语语言,还有编程语言。因此,可以实现生产力的提高。你可以从ChatGPT和其他类似的技术中生成自动代码审查。我认为这里有许多机会,但我认为它存在于行业领先公司正在使用的Python编程模型中。它不是刚刚兴起的,已经出现了一段时间,我们极客称为SMLAR技术。”英特尔专家曾经这样分享道。

简单解释,就是“鸡生蛋、蛋生鸡”的关系,也就是说,未来AI大模型还会用在开发AI大模型上。现在CUDA就已经开始有了这样的动作,英特尔也正蓄势待发。

在2月末刚刚结束的MWC2024上,英特尔展示了最多具备288个核心的能效核(E-core)处理器Sierra Forest,性能核(P-core)处理器Granite Rapids 也正蓄势待发。可以说,未来在AI推理领域,至强还会更强。

相关文章

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服