IT之家 10 月 22 日消息,今年第三季度,实现净利润 2579 万元,同比下降 81.86%;前三季度净利润 9936 万元,同比下降 76.36%。

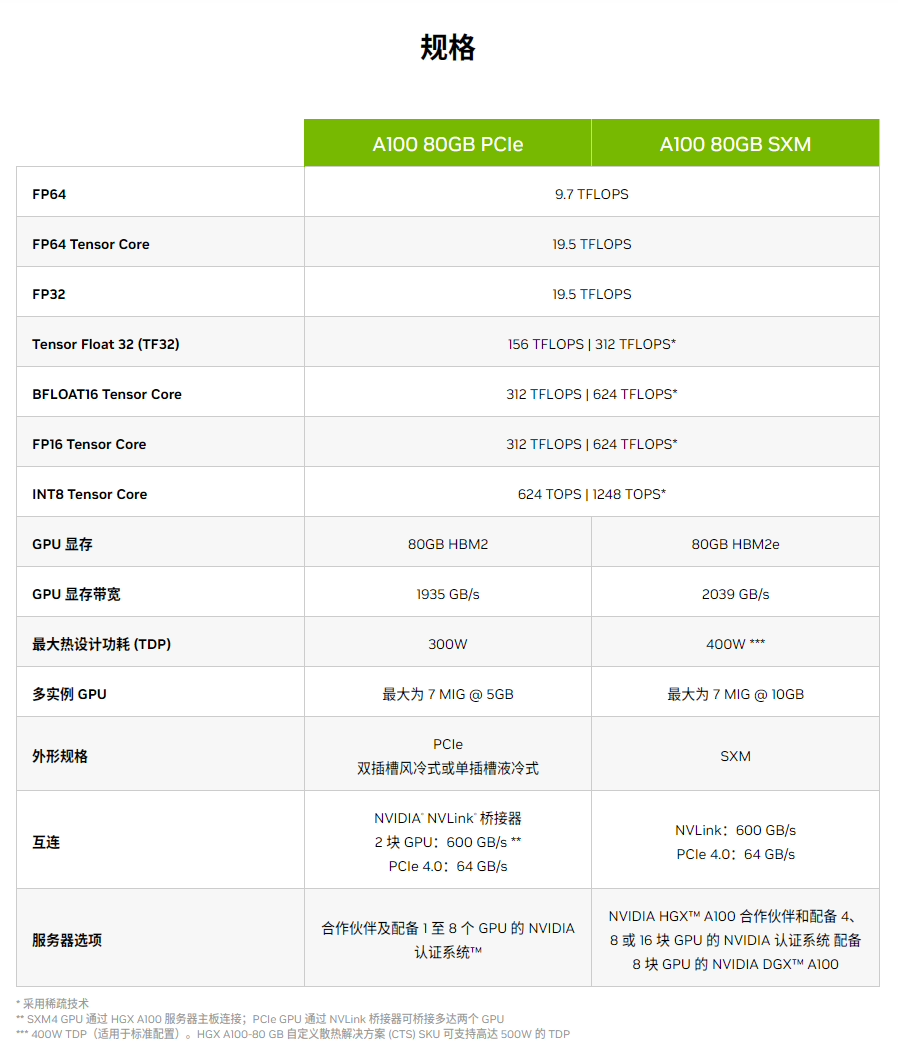

本文引用地址:副总裁江涛在 Q3 业绩说明会上透露,讯飞已于 2023 年初与华为昇腾启动专项攻关,与华为联合研发高性能算子库,合力打造我国通用人工智能新底座,让国产大模型架构在自主创新的软硬件基础之上。

他指出,目前华为昇腾 910B 能力已经基本做到可对标英伟达 A100。在即将举行的 1024 全球开发者节上,讯飞和华为在人工智能算力底座上将有进一步联合发布。

他还提到,该公司一直致力于实现算法提升和工程技术方面的加速。自 2019 年被列入美国实体清单后,公司于 2022 年 10 月 7 日再次被美国对包括科大讯飞在内的 28 家中国人工智能、高性能芯片、超级计算机领域的头部企业和机构加码制裁。

IT之家查询公开资料发现,海思昇腾 910 发布于 2019 年,同时还推出了与之配套的新一代 AI 开源计算框架 MindSpore,而 MindSpore 也已经于 2020 年完成开源。

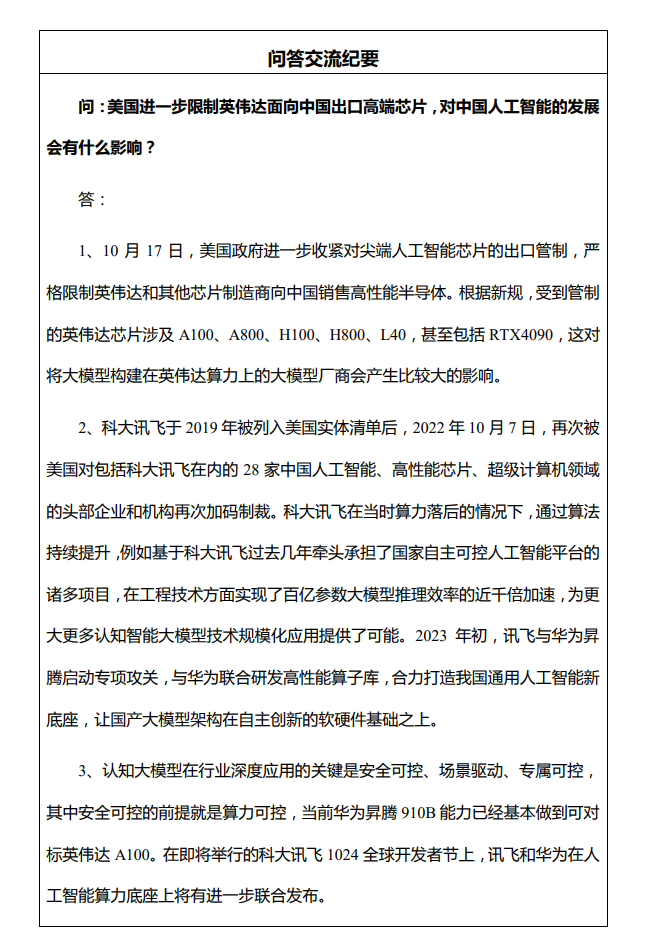

目前,华为昇腾社区已公开 Atlas 300T 产品有三个型号,分别对应昇腾 910A、910B、910 Pro B,最大 300W 功耗,前两者 AI 算力均为 256 TFLOPS,而 910 Pro B 可达 280 TFLOPS(FP16)。

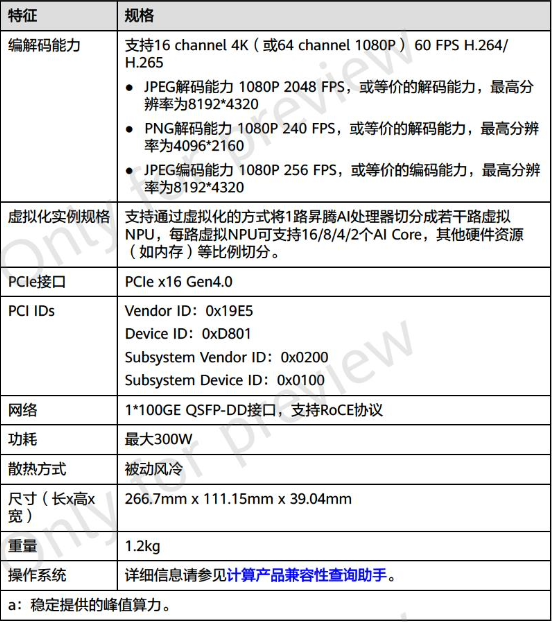

作为对比,NVIDIA A100 发布于 2020 年,采用双精度 Tensor Core,基于 Ampere 架构,功耗达到了 400W,FP32 浮点性能 19.5TFLOPS,FP16 Tensor Core 性能可达 312TFLOPS。

按照华为官方给出的规格,昇腾 910 Pro B 要比 A100 慢 18% 左右。

说到这里也顺便提一下 A800 芯片。这颗芯片是为了解决去年的美国商务部的半导体出口规定特意推出的一款型号,算力等参数完全不变,只是传输速率为从每秒 600GB 降至 400GB,所以美国本周发布的半导体出口新规封堵了这一漏洞。

根据知乎上 AI 从业者的反馈,哪怕昇腾 910B 目前还有不少小问题、单卡性能落后于 A800、Arm 生态有所欠缺(应该是指 CANN 对比 CUDA),但随着英伟达先进产品被禁,后续国内厂商只能被迫选择昇腾,相信昇腾产品会更加完善,并且国产厂商还可以通过堆量、增加算力集群规模的方式完成替换,至少在大模型训练领域整体差距不大。

值得一提的是,PyTorch 基金会本周三正式宣布华为作为 Premier 会员加入基金会,这也是中国首个、全球第十个 PyTorch 基金会最高级别会员。

除此之外,PyTorch 最新的 2.1 版本已同步支持昇腾 NPU,并在华为的推动下更新了更加完善的第三方设备接入机制。基于该特性,三方 AI 算力设备无需对原有框架代码进行修改就能对接 PyTorch 框架,昇腾也提供了官方认证的 Torch NPU 参考实现,可以指导三方设备便捷接入。

基于新版本,用户可以在昇腾 NPU 上直接享受原生 PyTorch 的开发体验,获得高效运行在昇腾算力设备上的模型和应用。