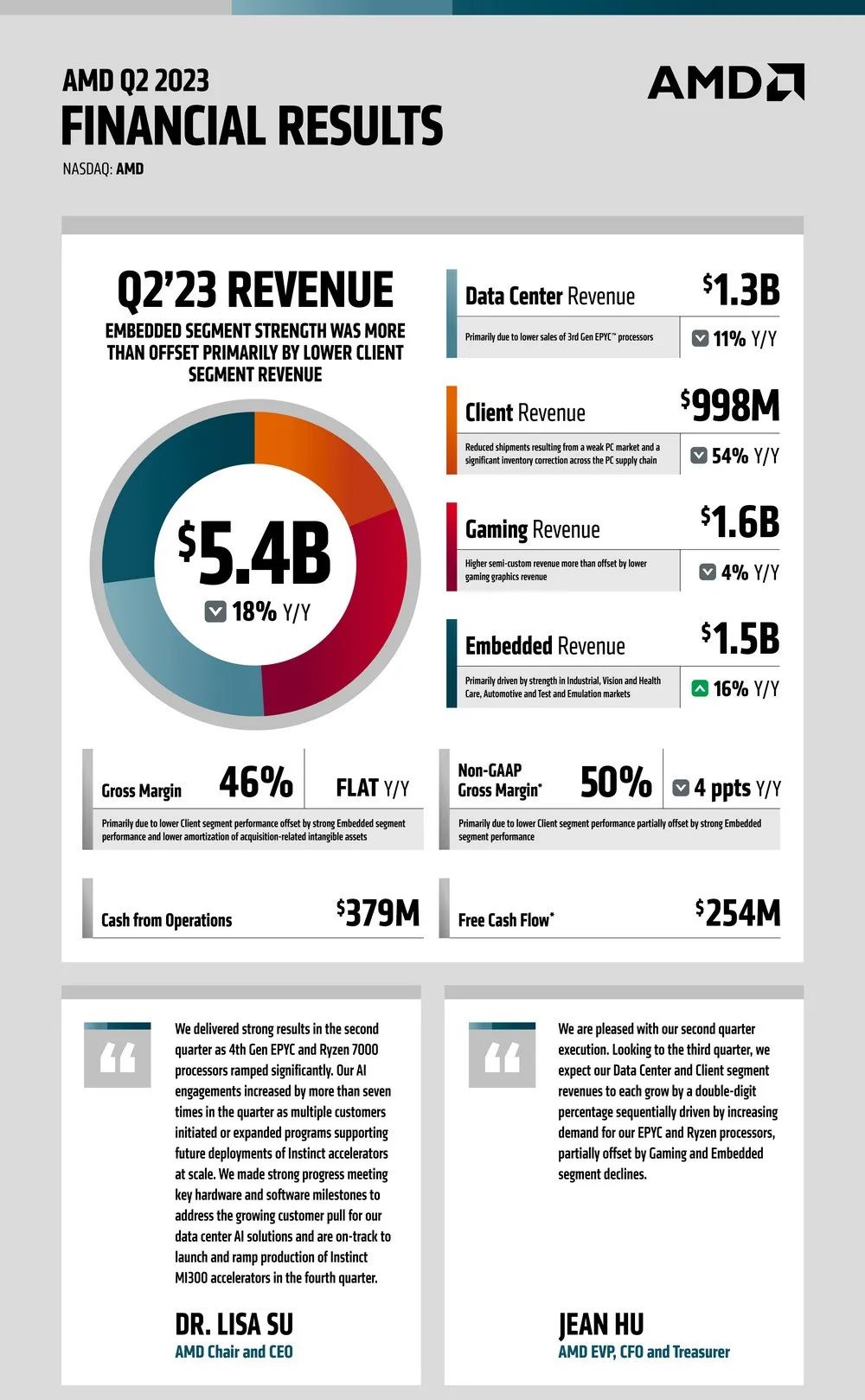

财报显示,D第二季度的收入和盈利均两位数下滑,但还没有华尔街预期的降幅大:D当季营收54亿美元,分析师预期53.2亿美元;二季度调整后运营利润率20%,分析师预期19.5%。

本文引用地址:D首席执行官苏姿丰(Lisa Su)指出,二季度业绩强劲得益于,数据中心业务中的第四代EPYC CPU和PC业务相关的Ryzen 7000 CPU销售大幅增长。

同时,苏姿丰在与分析师的电话会议上表示,到2027年,数据中心的人工智能加速器市场可能会超过1500亿美元。个人电脑是推动半导体处理器销量的传统产品,但随着个人电脑销量下滑,人工智能成为半导体行业的新亮点之一。

生成式和大语言模型(LLM)需要的算力和内存大幅提高。预计今年,数据中心加速器的市场将达到300亿美元左右,到2027年将超过1500亿美元,复合年增长率超过50%。这意味着未来四年的CAGR将会超过50%。

AMD实现硬软件关键里程碑

在今年5月公布一季度财报后,苏姿丰就曾表示,现在是AMD的头号优先要务,“虽然我们仍处于人工智能新时代的早期阶段,但很明显,人工智能为AMD带来了数十亿美元的增长机会”。

AI是塑造下一代计算的决定性技术,也是AMD最大的战略增长机会。AMD正在增加AI相关的研发支出,并已经制定AI战略 —— 包括AI专用和软件的开发,在实现硬软件关键里程碑方面取得了巨大进展。

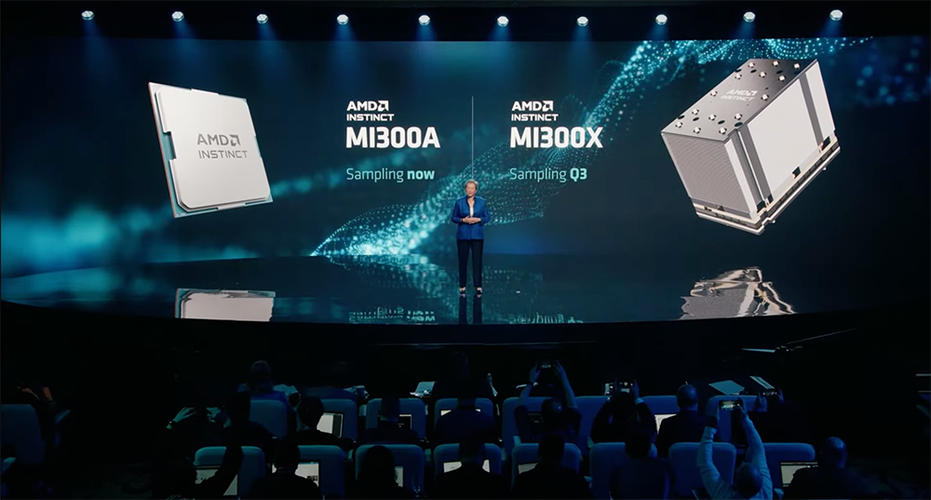

· A:A是AMD为AI和高性能计算(HPC)打造的一系列最新APU加速卡之一,采用3D堆叠技术和Chiplet设计,配备了基于5nm制程的9个组,置于基于6nm制程的4个芯片组之上,其晶体管数量达到1460亿。其中有24个Zen 4 CPU核心,一个CDNA 3图形引擎,内置128GB的HBM3内存。相较上一代的MI250X,在AI上的算力(TFLOPS)预计能提升8倍,能耗性能(TFLOPS/watt)将优化5倍。

· MI300X:MI300X是针对LLM设计的MI300A优化版本,内部没有集成CPU内核,而是采用基于CDNA 3架构8个GPU芯粒以及另外4个I/O内存芯粒组成的芯片,晶体管达到1530亿个,是目前全球最大的逻辑处理器。内存达到了192GB,内存带宽为5.2TB/s,Infinity Fabric带宽为896GB/s,高内存密度和高内存带宽使得MI300X在运行大模型(如GPT-3、PaLM2等)方面更具优势。

基于MI300X,AMD还宣布了Instinct平台,其搭载8颗MI300X,提供总计1.5TB的内存,意味着该计算平台能训练参数规模更大的大语言模型。

除了硬件,AMD也在加大软件生态的投入,推出了用于数据中心加速、一套完整软件栈工具AMD ROCm系统,包括为PyTorch 2.0提供即时“零日”支持,AI模型“开箱即用”等。ROCm软件栈可与模型、库、框架和工具的开放生态系统配合使用,TensorFlow和Caffe深度学习框架也已加入第五代ROCm。

去年11月ChatGPT发布以来,人工智能领域对算力的需求空前提升,提供底层算力的是最大的受益者,其GPU产品在AI大模型训练上几无替代品。随着AMD收购赛灵思完成后,其在AI领域的力度明显加大,也希望把握生成式AI带来的重大机遇。

此次MI300X新一代服务器处理器系列等产品披露进展后,AMD的计算产品线将从CPU、GPU、FPGA、DPU延伸至软件平台,形成与的全面竞争格局。

欲与试比高

目前,英伟达在AI领域处于制霸地位,它在AI处理器市场上占据大约80%的份额,其高端处理器已被用于训练和运行各种聊天机器人。

在2016年的GTC China大会上,黄仁勋就表示:“AI算力将是未来科技发展的核心,因此英伟达不再是一个半导体公司,而是一家AI计算公司”。之后一直专注于提升AI算力,成功搭上ChatGPT的浪潮,在2023年5月30日,英伟达市值突破万亿美金。再回过头,英伟达已经顺AI之势成了难以撼动的巨无霸。

面对五年复合增幅可达50%以上的市场需求量,AMD很难不心动,MI300新系产品线的亮相,或将成为能够与英伟达一决高下的“终极武器”。值得注意的是,因为多个客户启动或扩大支持AMD Instinct加速器未来大规模部署的计划,AMD的AI参与度在二季度增长了七倍多。

对标英伟达AI芯片H100的大模型专用芯片,AMD的MI300X号称HBM密度高达英伟达H100的2.4倍,HBM带宽高达H100的1.6倍,单个芯片可运行多达800亿参数的模型,可以运行比H100更大的模型,相比之下,H100芯片只能支持120GB的内存。虽然英伟达在这一点上可能将很快迎头赶上,甚至在相同的时间框架内实现反超,但在这一新兴市场的主导地位仍将受到挑战。

随着模型规模越来越大,需要多个GPU来运行最新的大型语言模型,而当MI300X配置更大的内存,生成式AI模型可能就不再需要数目那么庞大的GPU,意味着可以节约成本。

AMD尚未公布MI300定价,但不难预测很可能将延续往日的高性价比定价风格,重点关注先把市场打开。在全球算力紧张、英伟达芯片价格居高不下的情况下,很可能选择在英伟达产品的价格上给压力。

此前,AMD表示MI300系列芯片将于第三季度开始批量生产,并将于第四季度开始量产,并没有透露具体有哪些公司将计划购买MI300X或MI300A。

AMD真的能逆袭英伟达吗?

AMD的MI300系列是目前从硬件水平上最接近H100的产品,但MI300X并没有像H100的Transformer Engine(用加速Transformer大模型的引擎),H100可以将大语言模型(LLM)的性能提高两倍,这也意味着用同样数量的MI300X将花费更长的训练时间。

同时算力的比拼,除了硬件端,其实还有软件端的较量。MI300系列的发布虽然在硬件参数上努力实现对标,而在软件端存在不少的差距,需要更多的时间来追赶。

英伟达CUDA软件生态帝国早在2007年就开始起步,AMD的ROCm在2016年才发布,ROCm操作系统长期只支持Linux,最近才登录Windows,但由于前期积累的较少,在开发者数量和软件包数量上远远落后。在Github上,贡献CUDA软件包仓库的开发者超过32600位,而ROCm只有不到600个,这很大程度影响了客户的使用。

CUDA是一个完全封闭的系统,绑定了百万计的开发者。从2017年推出V100,到2020年推出A100,再到2022年推出H100,现如今英伟达的CUDA生态已经积累了近250万开发者,建立了其他竞争对手短时间难以逾越的护城河。

与英伟达独有的CUDA生态不同,AMD推出ROCm生态圈,并实现通过HIP完全兼容CUDA,同时也与客户包括微软等合作重构自己的生态。虽能完全兼容CUDA,为AMD提供了说服客户迁移的条件和理由,但兼容只属权宜之计,进一步建立属于自己的生态才能形成竞争优势。

目前可以真正兼容CUDA的除英伟达自身外就只有AMD一家,AMD和英伟达之间有相关的IP授权,这样AMD的MI系列GPU可以使用CUDA,其他初创企业都不能直接使用CUDA。

从技术层面来看,兼容意味着被动、落后,因为CUDA每一次升级,ROCm都需要做出对应升级,技术团队无法将所有精力用于ROCm生态圈的迭代上,应用场景和使用体验都会落后于英伟达。

相比于英伟达,AMD无疑落后了半个身位。此外,英伟达已经在交付H100,并表示在未来几个季度会增加产量,其产品已得到客户的认可和接受,并且已经有完整的产业链为其供货;而AMD的新品仍在试验阶段,还尚未披露任何基准测试,可能到下半年才会交付,还有许多问题仍待解决。这或是市场有所保留的原因,新品推出都需要经过市场长时间的验证。

在行业景气度持续上升的背景下,谁能率先完成独有的软件生态,谁就有可能挑战英伟达在训练芯片的市场地位,目前看最有机会的就是AMD。期待今年晚些时候能够看到一些与同业竞争对手的比较。

有望带动良性竞争

因为英伟达在算力芯片上具有绝对领先的地位,而当前AI需求的激增让A100、H100等产品供不应求,其订单已经排至2024年,像H100在明年一季度之前都处于售罄状态。

MI300X的推出给市场带来打破英伟达“一家独大”局面的希望,大模型玩家渴望通过使用更优秀产品,以减少与OpenAI等厂商算力支持差距。虽然从短期看,两家之间仍有不小的差距,但中长期的角度,市场追赶者的出现还是能加剧算力端的竞争,有助于降低AI芯片的价格,更利于技术的迭代和进步。

潜在客户对MI300非常感兴趣,希望能够在英伟达的芯片之外,还有一个替代的选项。如果AMD的MI300系列被开发者和服务器制造商当成英伟达产品的替代品,就很可能意味着AMD将迎来一个有待开发的巨大市场。

AI芯片的竞争还是处在一片正在快速扩张的蓝海之中,随着AI应用越来越深入我们的生活,更加难以想象AI芯片市场的规模极限,其中留给AMD和英伟达的空间自然也足够大。英伟达尽管通过长期积累建立了强大的优势,但还有足够的市场需求等待AMD满足,这也是后者的机会所在。

AI市场的竞争也是一场持久战,AMD在不断进行技术创新和市场布局,未来也有可能实现逆袭。无论是英伟达还是AMD,谁能笑到最后还是看长期的发展潜能。

另外,还有中央处理器巨头英特尔最近也正调整发展战略,以把握AI发展的契机,开始发力人工智能芯片。AMD面对的竞争将会加剧,AI的战役或才刚刚展开。