在2024年即将到来之际,多家机构给出预测,认定生成式将成为2024年的增长重点之一。回顾2023年,年初的ChatGPT引爆了今年的生成式热潮,不仅仅是下游市场的应用,这股大火一直烧到了上游芯片领域,根据权威机构预测,2023年和2024年,AI服务器将有38%左右的增长空间。随着等AI芯片走向高峰的同时,也极大带动了市场对新一代内存芯片(高带宽内存)的需求。

本文引用地址:

是何方神圣?

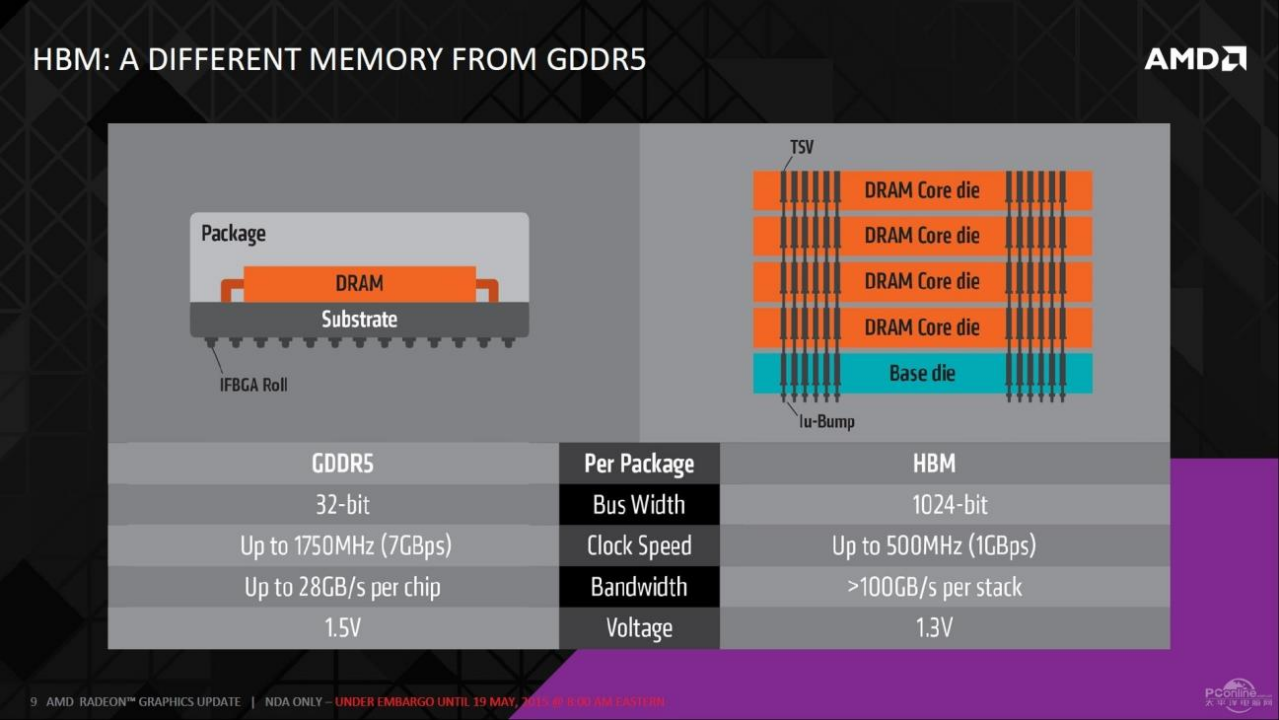

首先,我们先来了解一下什么是。HBM全称为High Bandwich Memory,直接翻译即是高带宽内存,是一款新型的CPU/内存芯片。其实就是将很多个芯片堆叠在一起后和封装在一起,实现大容量、高位宽的组合阵列。这么说可能有一些不明所以,简单来讲,如果说传统的内存芯片是一层的平房结构,那么采用了HBM结构的内存就是现代化的摩天大楼,占地面积不变的基础上,向3维高度发展,从而可实现了更高的性能和带宽。

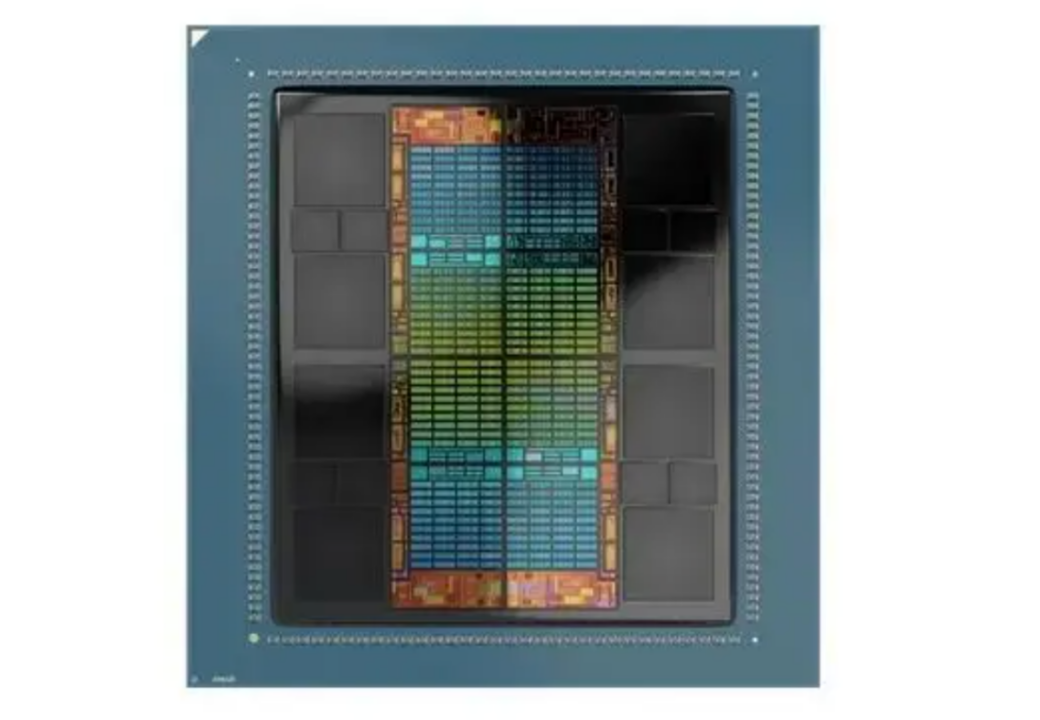

我们以上图中AMD专为AI训练打造的旗舰GPU MI300X为例,彩色部分是GPU单元,而两侧就是AMD为其配备的8个HBM 3堆栈,每个堆栈为 12-Hi,同时集成了 16 Gb IC,每个 IC 为 2 GB 容量或每个堆栈 24 GB。

我们不难发现,随着AI应用的越来越广泛,HBM的相关应用也是越来越多,需求水涨船高,这篇文章就带各位读者介绍一下HBM相关知识,让各位大致了解一下,为什么我们的AI需要HBM。

在文章开头笔者就说明了简单来讲,HBM技术就是把传统的DDR内存从“平房”改成了“楼房”。从土木工程的角度来看,建一个楼房可要比建一个平房要困难很多,从底层地基到布线都需要重新设计。而同样地,作为微观结构上的“楼房”,想要实现将DDR盖成楼房的HBM技术也是困难重重。

使得HBM技术得以实现的是基于TVS技术的3D封装技术的成熟,对于封装技术的阐述,各位读者感兴趣可以移步笔者之前写过的另一篇文章:

本篇就不再过多赘述,在这篇文章中,笔者来简单说明一下HBM中的TVS技术的应用。

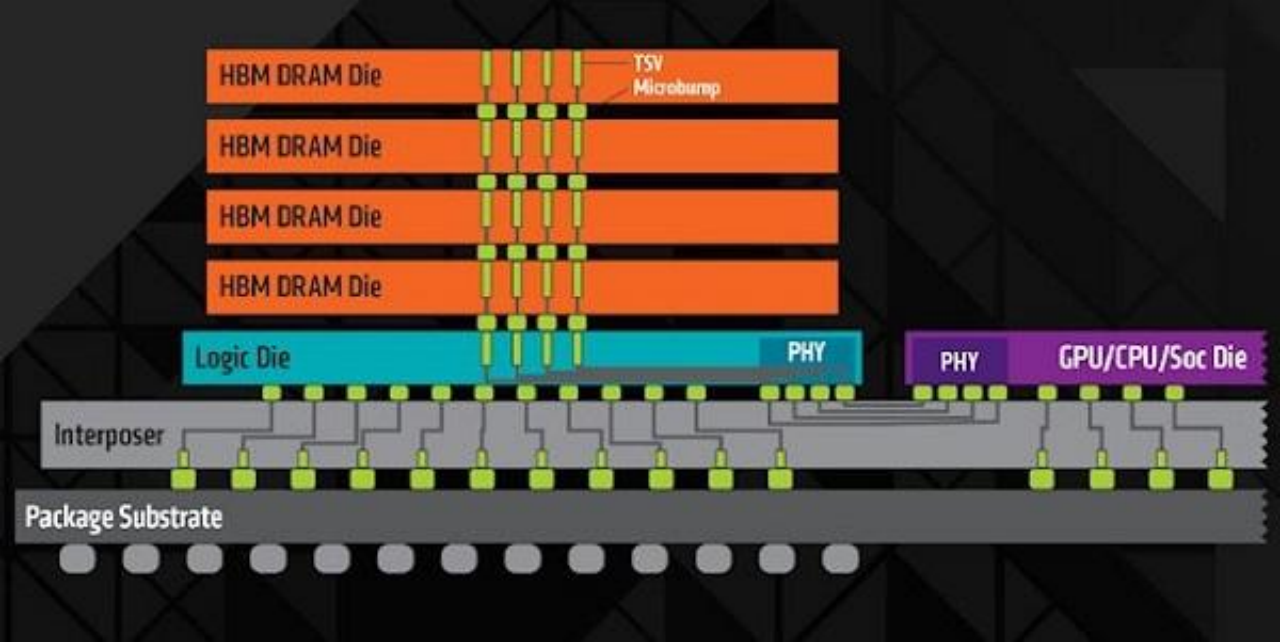

首先,在这个由DRAM组成的微观“大楼”中,DRAM被堆叠在一起,并且每个DRAM芯片之间使用TVS(Transient Voltage Suppressor)连接方式进行连接。在DRAM下方是DRAM逻辑控制单元,该单元负责对DRAM进行控制。GPU与DRAM之间通过uBump和Interposer(一种具有互联功能的硅片)进行连接。Interposer再通过Bump与Substrate(封装基板)连接,最终连接到BGA(球栅阵列)BALL上。最后,BGA BALL连接到PCB(印刷电路板)上。就如下图所示:

得益于这种堆栈结构,HBM通过中介层实现紧凑而快速的连接,节省了94%的表面积,其具备的特性几乎与芯片集成的RAM相同,可实现更多的IO数量。此外,HBM重新调整了内存的功耗效率,使每瓦带宽比GDDR5高出3倍以上,这意味着功耗降低了3倍以上。

为什么AI需要HBM?

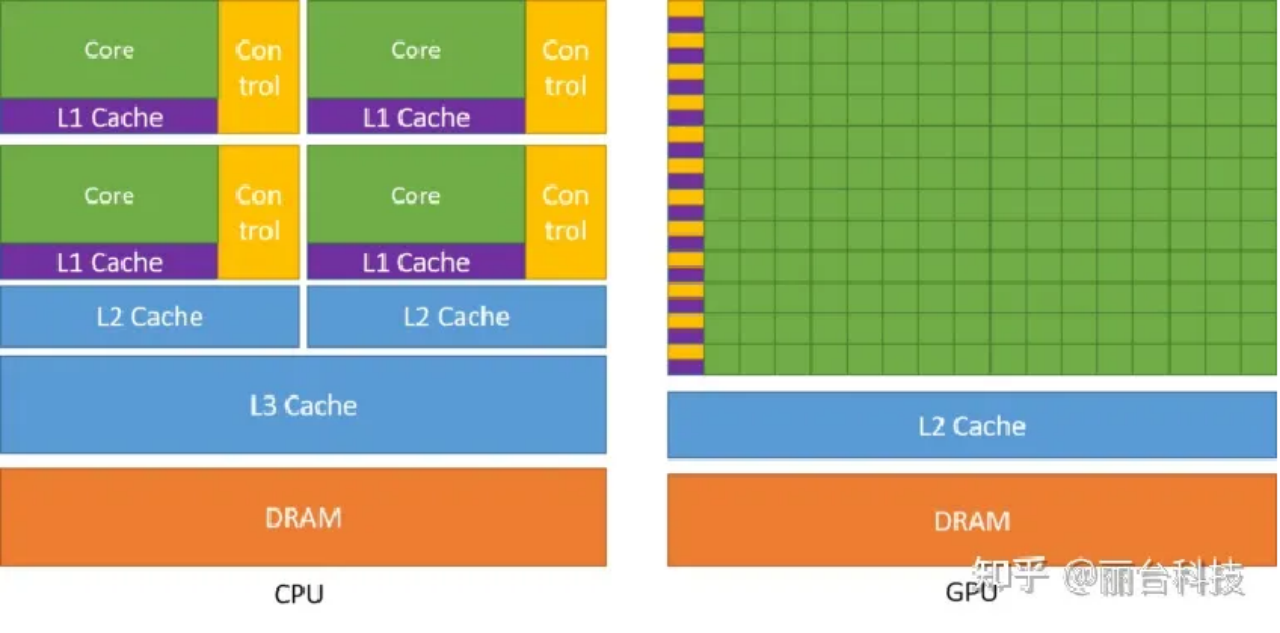

为了回答这个问题,我们需要先认识到另一个现实:为什么GPU相比CPU更加适合AI训练?

我们可以举一个有趣的例子:

CPU是一个多才多艺的博士,但通常都是独自工作或最多与几个博士伙伴一起(多核心多线程)。有一天,操作系统带来一个新任务,列出了一系列的简单的百以内加减乘除运算。CPU看到这个任务感到虽然简单,但是自己一个人一道一道算,有些吃力。这时,显卡找上门来,告诉CPU说:“CPU,我这里有几百个只会做加减乘除的小学生(GPU核心),他们做得又快又准。你可以指挥他们来做,这样会轻松很多。” CPU觉得这个主意不错,于是显卡就把那本册子拿走了,并让那几百个孩子开始工作,任务很快就完成了。没过多久,操作系统又来了,手里拿着一本新册子。CPU一看,封面写着“AI训练”。他心里有些不安,不知道这次又是什么新挑战。他打开册子一看,还是那些加减乘除的运算。

从上述的这个小故事中,我们可以简单总结一下GPU更适合训练AI的主要原因,主要有这两点:首先,GPU具备强大的并行计算能力,使其能够同时处理多个任务,从而加速AI模型的训练过程;其次,GPU的显存相较于CPU的系统内存在处理大规模数据时更为高效,这使得GPU能够更有效地处理AI训练所需的大量数据。

回答本节之中所提出的问题,为什么AI需要HBM技术呢?HBM可以为显卡带来更大的显存容量和显存传输带宽,而一旦GPU拥有更高的内存带宽和更大的显存容量,这就会使得它能够更快地读取和写入数据,提高数据吞吐量。对于处理大规模数据的AI任务来说,这是非常重要的。因此HBM技术所带来的显存性能的显著提升,对于显卡完成AI任务来说十分重要。

不仅如此,在深度学习中,需要频繁地访问内存进行数据传输。GPU通过HBM技术获得得更高的内存带宽和更快的内存访问速度,就能够更快地进行数据传输,提高计算效率。此外,HBM带来的更大容量显存也可以使得GPU在AI任务中能够处理更大规模的数据集和模型,在如今生成式AI向着越来越大数据规模的方向发展之中,起到了重要的支持作用。

HBM技术的演进

在HBM技术的开发过程中,有两个厂商功不可没,它们就是AMD和。一些信息表明,AMD在2009年就意识到DDR的局限性并产生开发堆叠内存的想法,后来其与SK联手研发HBM。并于2013年,推出了首款HBM1技术的显卡,即Radeon R9 290X。这款GPU采用了4颗HBM芯片,总容量为4GB,可以提供更高的显存带宽和更高的内存容量,从而提高了GPU的性能和效率。不仅如此,这项全新技术,还被定为JESD235行业标准:HBM1的工作频率约为1600 Mbps,漏极电源电压为1.2V,芯片密度为2Gb(4-hi),具有4096bit的带宽,远超过了GDDR5的512bit。

可以说在当时,认定了这才是未来的显存,但是AMD却在2016年发布完产品后完全转向,近乎放弃了HBM。唯一仍然保留HBM技术的是用于AI计算的加速卡。因此,在第二代HBM技术问世的2016年,这个赛道中变成了海力士和新加入的三星之间的对决。

2016年1月,三星宣布开始量产4GB HBM2 DRAM,并在同一年内生产8GB HBM2 DRAM;2017年下半年,被三星赶超的SK海力士开始量产HBM2;2018年1月,三星宣布开始量产第二代8GB HBM2"Aquabolt";2019年8月,SK海力士宣布成功研发出新一代"HBM2E";2020年2月,三星也正式宣布推出其16GB HBM2E产品"Flashbolt",于2020年上半年开始量产;到了2022年,JEDEC组织正式发布了新一代高带宽内存HBM3的标准规范,这一新标准在存储密度、带宽、通道、可靠性、能效等各个层面都进行了扩充和升级。JEDEC表示,HBM3是一种创新的方法,是更高带宽、更低功耗和单位面积容量的解决方案。对于那些需要处理大量数据和高数据速率的应用场景来说,HBM3十分重要,比如图形处理和高性能计算的服务器。

从HBM1到HBM3,SK海力士和三星一直是HBM行业的领军企业。而对于AMD来说,可谓是起了个大早,赶了个晚集。AMD既没有凭借HBM在游戏显卡市场中反杀英伟达,反而被英伟达利用HBM巩固了AI计算领域的地位,煞是可惜。

HBM领域市场分析

在本文开头笔者就已经提到,生成式AI的火热同时也带动了HBM领域的热度,那就有必要在年末之时粗略向各位读者分析一下目前以及未来HBM市场的竞争格局。

调研机构TrendForce集邦咨询也指出,预估2023年全球HBM需求量将年增近六成,来到2.9亿GB,2024年将再增长三成。2023年HBM将处于供不应求态势,到2024年供需比有望改善。据其他权威机构预测,预计 2024 年随着各原厂 积极扩产的效果显现,HBM 供需比有望获改善,预估将从 2023 年的-2.4%,转为 0.6%。而从各产品的占比来看,2023 年主流 HBM 需求从 HBM2E 升级为 HBM3 甚至 HBM3E,HBM3 需求比重预估约为 39%,较 2022 年提升超 30%,并在 2024 年达到 60%,届时份额比重也将超过 HBM2E。

目前,HBM的平均售价至少是DRAM的三倍,而由于ChatGPT的拉动和产能不足的限制,HBM的价格一路上涨,与性能最高的DRAM相比,HBM3的价格上涨了五倍。而在即将到来的2024年,可以预见的是高端AI服务器GPU搭载HBM芯片将成为主流,这进一步推动了HBM市场的增长。根据TrendForce的数据,2022年全球HBM容量约为1.8亿GB,2023年增长约60%达到2.9亿GB,2024年将再增长30%。如果以HBM每GB售价20美元进行测算,2022年全球HBM市场规模约为36.3亿美元。预计到2026年,市场规模将达到127.4亿美元,对应年复合增长率(CAGR)约为37%。

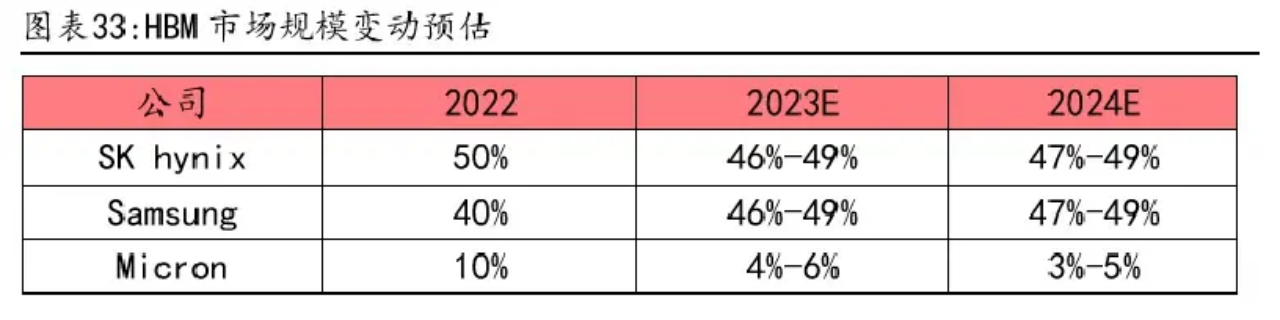

而其市场格局也将形成三足鼎力的形势。海力士作为将HBM技术最早商业化的厂商将继续领先,而三星将紧随其后,2023年海力士和三 星的 HBM 份额占比约为 46-49%,而的份额将下降至 4%-6%,并在 2024 年进 一步压缩至 3%-5%。

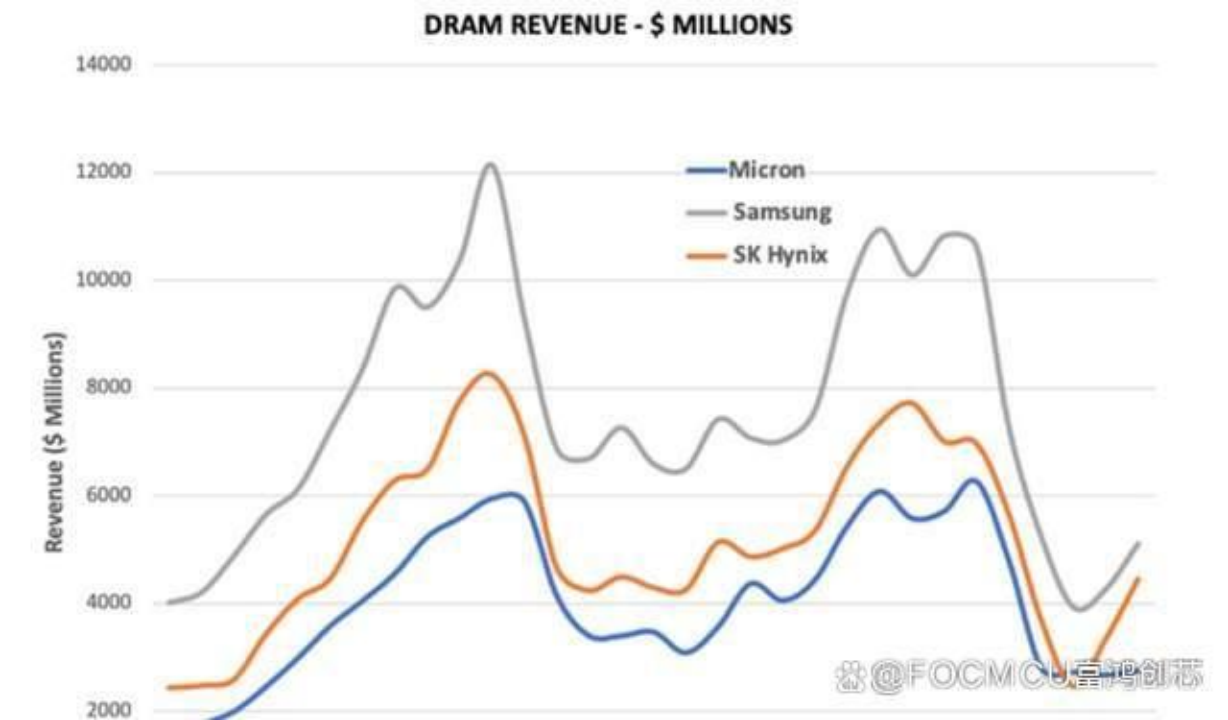

在这三家争霸的局势之中,科技由于起步较晚,在2022年仅仅占据了HBM市场份额的10%,而未来还有继续下降的趋势。最近的科技财报电话会议数据显示,美光的DRAM业绩明显不如SK海力士和三星。美光2024财年的资本支出预计将比2023财年略有增长,不过WFE支出将再次同比下降。

在美光2023年第四季度的DRAM收入显示,美光的DRAM收入增长率仅为3%,明显低于竞争对手。而考虑到采用了HBM技术的DRAM价格约为普通DRAM的7倍,而美光的DRAM业务仅仅微涨了3%。在业内,美光是首家拿出HBM3e样品的公司,其性能和能效在业内均处于行业领先地位。其技术能力于其他在HBM领域的竞争对手相比并不落下风。因此笔者认为,美光的HBM产品在客户接受度上,还有很高的提升空间。

未来进入2024年,有权威机构分析表示:美光科技在HBM方面将继续面临逆风。SK海力士是全球唯一一家大规模生产HBM3的公司,并为英伟达独家供应H100 Tensor Core GPU。美光公司也表示自己将要推出的HBM3 Gen2产品将有更好的性能,其预计引脚速度将超过9.2GB/s。但是随着海力士与英伟达强强联合之下,这对于美光来说,2024年的HBM领域也是面临严峻挑战的一年。

但是面对逆境挑战,美光CEO Mehrotra乐观表示:“这就是创建人工智能软件的计算机所需要的超快访问芯片类型。AI给我们所带来的高营收、高利润机会才刚刚开始。”

而HBM技术在国内发展,整体上并不乐观,目前HBM相关产业链布局相对较小,只有一些企业涉及封测领域。在国内涉及HBM产业链的公司主要包括雅克科技、中微公司、和拓荆科技等公司。其中,雅克的子公司UP Chemical是SK海力士的核心供应商,为其提供HBM前驱体。

在更远的未来,预计AI的浪潮还将继续愈演愈烈,而HBM今后的存在感或许会越来越强。据semiconductor-digest预测,到2031年,全球高带宽存储器市场预计将从2022年的2.93亿美元增长到34.34亿美元,在2023-2031年的预测期内复合年增长率为31.3%。笔者相信,HBM技术将在很长一段时间中都会是AI硬件领域的重要技术,随着越来越多的厂商入局HBM,HBM一定会受到持续的关注和更快的发展。