2023年科技产业备受关注的人物与企业,莫非NVIDIA与其CEO黄仁勳莫属。2月间,黄仁勳宣称「AI的iPhone时刻」已经到来,半年之后,外界用连续2季的财报业绩检视NVIDIA,NVIDIA也在抱回外界难以想像的获利。

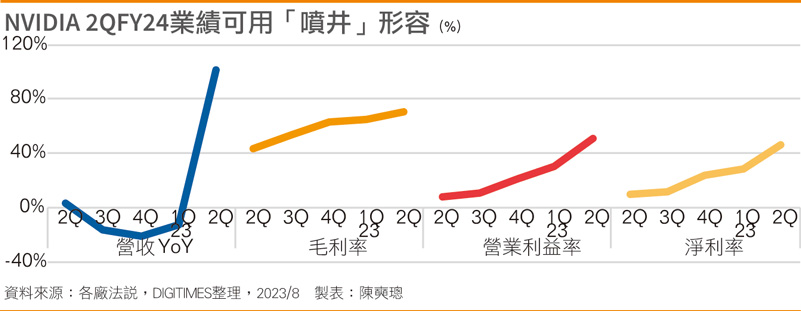

NVIDIA公布的2024会计年度第2季(2QFY24)财报数据,揭示营收年增101%、净利年增422%、毛利率高达71.2%的炸裂式业绩,各项指标均远超预期,而H100系列芯片在AI热潮推动的大型语言模型训练(LLM)市场中一卡难求。

NVIDIA 2QFY24业绩可用「井喷」形容

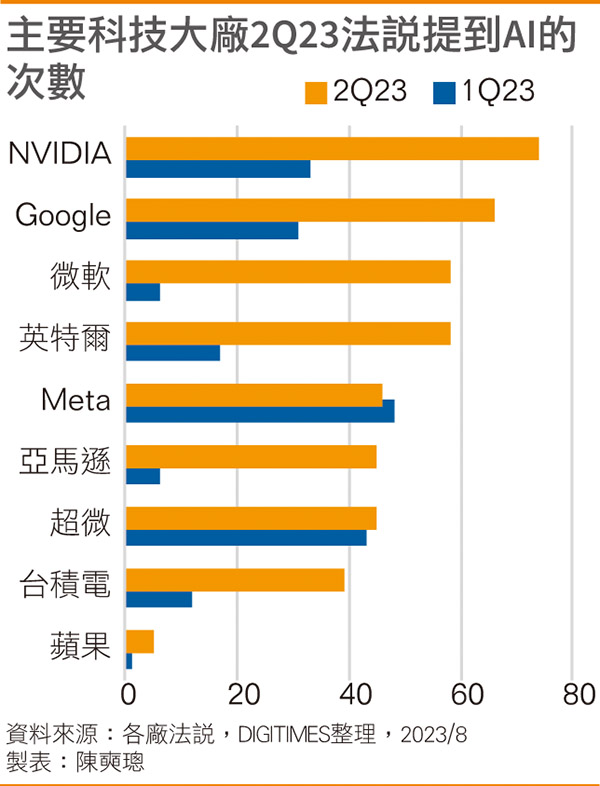

主要科技大厂2Q23法说提到AI的次数

AI算力需求呈现爆炸式成长,对云端业者而言,只能不断采购AI服务器;然对于LLM开发厂商来说,NVIDIA的数据中心业务疯狂吸金,而客户却还未实现获利。眼前LLM大浪未至,钱却都被NVIDIA赚走了。

在财报公布前,NVIDIA高端AI GPU不断传出涨价声,Barrron's引述分析师报告,H100制造成本为3,320美元,而售价则高达2.5万~3万美元,利润接近成本的10倍;毛利率超过70%,对芯片产品而言,有些不可思议。

对此黄仁勳强调,NVIDIA提供的是软件生态系统和硬件平台,具备软件生态架构的灵活性、多功能性,再加上广大的安装基础及涵盖范围,程序码数量和应用程序组合的类型相当疯狂,简单说,卖的是「准系统」而非「单一芯片」,但NVIDIA花了20年才走到这一步。

外界分析,NVIDIA构建的CUDA软件生态,不仅让旗下GPU受青睐,也是客户无法轻易转向超微(AMD)等竞争对手的主因。原因在于,AI算力的配置绝非简单的硬件堆叠,即便把重达30多公斤、多达3.5万个零件组成的NVIDIA HGX平台层层堆起来,也堆不出LLM必须的AI算力。

要把1,000张加速卡、100台AI服务器放在一起,跑同一个LM训练或推论任务,还需要大量的配套软件、通讯网络,还不包括客户的大量数据。这是一系列软硬件联合调用的复杂过程,黄仁勳把H100这类AI GPU称为「技术奇蹟」,并非没有原因。

H100从2022年9月量产投入市场,至今供不应求,甚至上一代的A100至今仍是抢手货。NVIDIA聚焦于系统级服务器产品,最新款DGX产品GH200集结256块H100和Grace CPU,预料会在2023年下半量产后将跃居业绩新推手。

至于H100为何价格高昂?在硬件层面上,H100采用了四大先进技术。第一是台积电4纳米制程(N4),要让这一颗长26.8厘米、宽11.1厘米、含有800亿个晶体管的H100发挥前所未有的效能,举世当今非台积电代工莫属。

第二是连接技术,每张H100包含3个NVLink连接,这是NVIDIA独家的数据传输技术,第四代NVlink可提供每秒900GB的GPU对GPU互连带宽,以便将更多H100互连使用,获得倍增的效能。

第三是80GB的HBM2e高带宽存储器,目前仅SK海力士(SK Hynix)、三星电子(Samsung Electroics)可供应,值得注意的是,NVIDIA刚刚宣布将最新的HBM3e植入最新GH200,是全球第一个支持HBM3e的GPU产品。

第四是台积电的CoWoS封装技术,台积电正积极扩建CoWoS产能,但供不应求情况恐将持续到2024年。

这四大技术每一项均属尖端领域,付出代价所费不赀,如果说LLM推动AI GPU加速运算时代来临,但让NVIDIA站在当前科技舞台上独舞的关键,却是黄仁勳领导团队的长期押注与心血累积。

相关文章

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服