作为全球资本市场的风口,自动驾驶从来都不曾离开舞台的中央。

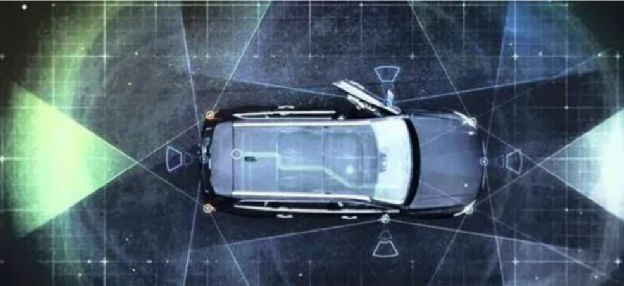

自动驾驶主要包括感知、决策和执行三个环节。其中,周边态势的感知,作为自动驾驶控制系统的输入,重要性不言而喻。更早以及更加精准的信息输入,将帮助自动驾驶控制器尽快做出一个准确的决策,调整车辆姿态来实现自动驾驶功能。

但在汽车自动驾驶领域,周边态势感知的技术路线选择之争从来就没有停歇过。以特斯拉为最知名的代表是纯视觉方案的坚定拥护者,至于国内很多企业则是视觉加雷达融合方案的拥趸。在线控底盘方案已经非常成熟且自动驾驶软件平台日趋完善的大背景下,对于周边态势的感知正在成为自动驾驶领域中的一个受到越来越多关注的分支。

得到全球公认的NuScenes数据集

NuScenes数据集是由现代汽车集团和Aptiv资成立的一家无人驾驶公司Motional开发,该数据集在2019年3月开源,填补了彼时自动驾驶汽车行业尚无大规模多模态数据集的空白。目前,NuScenes是被全球各大自动驾驶领域相关公司引用最多的数据集,其权威性得到各方的认同。

基于NuScenes数据集的NuScenes挑战赛,也已经成为检验感知算法在自动驾驶相关任务性能的试金石。我们所熟知的全球范围内多家自动驾驶领域的知名企业及知名高校在NuScenes挑战赛中进行了相关测试结果的提交,诸如卡内基梅隆大学、加利福尼亚大学伯克利分校、MIT等。作为自动驾驶AI感知算法的一个重要的比拼舞台,大家通过NuScenes挑战赛这样一个“试金石”平台,同场竞技,来了解自己所处的位置以及竞争对手的状态,进而达到共同促进自动驾驶感知技术发展的目标。

3D目标检测任务是自动驾驶感知性能的关键指标

在NuScenes数据集中,相关评测任务包括了3D 目标检测、3D 目标跟踪、预测轨迹 、激光雷达分割、全景分割和跟踪。其中, 3D目标检测任务是最为重要的一个评测指标。

和普通的对于周边物体感知不同,自动驾驶所面临的是一个包含时间轴在内的4维坐标空间。所以自动驾驶感知系统不仅需要判断周边物体的远近和大小,同时也还需要判断这些物体是静止的还是运动的,以及他们的运动方向和速度。这对于自动驾驶软件算法进行下一步路径的预判至关重要。

NuScenes数据集的3D目标检测任务,覆盖了包括汽车、卡车、公交车、行人等10种我们在日常出行中会遇到的绝大部分检测对象。通过为它们标出3D目标框,并估计出相应类别的属性信息和当前的速度信息等,NuScenes提出了一个综合指标NDS (NuScenes Detection Score, NDS)。这个指标由平均精度(mAP)、平均平移误差(ATE)、平均尺度误差(ASE)、平均方向误差(AOE)、平均速度误差(AVE)和平均属性误差(AAE)综合计算得到,成为衡量自动驾驶对于周边物体识别的一个比较客观公正的评价指标。

纯视觉方案的优势在哪里?

在自动驾驶系统中,感知系统的硬件是由一系列的传感器组成,主要包括摄像头、超声波雷达、毫米波雷达和激光雷达等。它们作为自动驾驶系统的“眼睛”,构成了整个自动驾驶系统的输入,其中最核心的就是摄像头和激光雷达。

当前,在自动驾驶领域,感知系统的技术路线选择的争议从来没有平息过。作为全球知名的车企,特斯拉一直是纯视觉方案坚定的支持者。而国内不少整车企业,目前都采用了采用雷达加摄像头的融合方案来实现3D目标任务检测。

两种技术路线各有优劣:

视觉+雷达方案的最大优势来源于激光雷达。激光雷达采集的点云信息与生俱来就存储了三维空间信息,因此基于激光点云信息的3D目标检测任务实现出来相对就简单了许多。但是这套方案也有自己比较明显的劣势:

1.较高的成本:激光雷达较高的成本,始终是阻碍其在车型上商业化部署的最大制约因素。最早的Velodyne的激光雷达高达8万美元一个,让其始终停留在测试车上。而如今虽然固态激光雷达成本大幅下降,但依然是整车不可忽视的一个零部件成本支出。

2.数据融合难度不小:摄像头和雷达的数据结构并不相同,将两者采集的数据进行融合,给到自动驾驶控制器最为准确的黄静信号输入,对数据融合算法也是不小的考验。

至于纯视觉解决方案,其最大的优势在于较低的成本。特斯拉所使用的单目摄像头单件成本不过25美元,全车搭载8个的话,费用也只有200美元。对于需要大规模商业化部署的整车,成本从来就不是一个可以忽略的难题。过高的成本,必然会阻碍消费者的购买意愿,让相关的技术方案只能停留在实验室阶段。另外,纯视觉解决方案依托技术可带来比较客观的迭代提升及较大的上升空间。随着AI技术的提升,纯视觉3D目标检测算法能够得以优化提升。

但视觉方案也有自己的不足,这个来源于摄像头自身的缺陷:无论是对于静态的物体还是对于识别纹理或者色彩信息较为丰富的物体时,都会显得力不从心。但摄像头的天生缺陷也可以用来弥补。通过更为强大的AI算法以及更多的实际道路场景数据的积累,能够帮助纯视觉方案在辨识周边道路情况时能够更加游刃有余。所以当AI算法达到一定的成熟度可以满足自动驾驶对于周边环境态势感知的要求之后,纯视觉方案就可以被部署在高等级自动驾驶系统上,来为整车企业提供一个可以同时兼顾商业化部署和周边态势感知要求的技术方案。

浪潮信息AI算法实现监测精度大幅度提升

今年10月,在最新一期NuScenes所公布的竞赛测评榜单中,浪潮信息凭借DABNeT4D登顶自动驾驶数据集NuScenes 纯视觉3D目标检测任务榜单,引发了极大的关注。

在这次3D目标检测任务中,浪潮信息的DABNet4D算法的NDS检测精度达到了0.624,相比于年初的NDS精度是0.474的BEV3D算法提升了15%。在同一时期,激光雷达的NDS精度从年初的0.685提升到0.728,提升约4个点。通过简单的数据比对就可以发现,浪潮信息AI的纯视觉检测精度在数值上正在大幅迫近激光雷达,而这背后都是AI算法的功劳。

浪潮信息此次所提交的算法DABNet4D是Depth-awared BEVNet 4D的缩写,即深度感知的四维鸟瞰图(bird’s eye view, BEV)神经网络,其核心本质就是鸟瞰图。

传统的纯视觉方案,是依靠布置在车身的摄像头来采集信息。然后通过对于每个摄像头数据的融合,来实现对车辆周边态势的感知。但这种策略最大的一个弊端在于一旦遇到比较体积较大的卡车时,会导致每个摄像头只能捕捉到卡车的一部分的情况,以致出现错判和漏检的情况发生。这种情况下,浪潮信息AI团队引入了鸟瞰图,即通过上帝视角,来把不同水平视角的图像融合成一个统一的以自动驾驶车辆为中心的俯视视角的特征图。这样就可以最清晰和完整地为自动驾驶控制器提供车辆周边的情况。在遇到体积较大的物体时,3D目标检测以及其他的检测、分类、分割等视觉感知任务就能够非常轻松地完成。

但要获得上帝视角的鸟瞰图的构建并非一蹴而就。浪潮信息AI团队早在今年年初就构建了一个基于Transformer架构的多视角特征融合模型CBTR、MASTER(Multi-camerA Spatial and Temporal feature ExtractoR,多相机时空特征提取器)算法、并在MASTER算法的基础上进一步引入了深度估计网络等等,最终实现了更为高效稳定的BEV(鸟瞰图)输出。此外,通过图像数据增强、BEV特征增强和样本贴图增强等多尺度的数据增强技术等,提升模型的检测效果,进而持续助力DABNet4D算法在NuScenes数据集中的优异表现。

总结

浪潮此次打榜成功的DABNet4D算法,让我们看到了感知层的另一个解决思路方案:通过对于态势感知算法的持续优化,来不断提升纯视觉方案的辨识精度,为纯视觉方案在自动驾驶领域的部署蹚出了一条新的道路。

在滚滚向前的自动驾驶浪潮中,作为全球领先级AI算力基础设施提供商,浪潮不仅在于利用自己过往在服务器这样的硬件领域的优势,持续强化自己硬件平台协同优势,同时也正在大力提升自己在AI算法方面的竞争力,通过算法优化来提升相关的效率,双向赋能,提升横跨软硬件的集群优势。从NuScenes榜单技术的快速迭代来看,我们有理由相信,随着算力、算法的持续型突破,自动驾驶产业化落地进程也将多一层“腾飞动力之源”。而这些,也都是车企所关注的方向,也是未来车企发展智能驾驶能力的关键。