6 月 13 日,在美国旧金山举办的“数据中心和人工智能技术首映式”活动上,AMD正式透露了 Instinct™ MI300 系列加速器家族的新细节,包括推出 AMD Instinct MI300X 加速器,这是世界上最先进的生成 AI 加速器。MI300X 基于下一代 AMD CDNA™ 3 加速器架构,支持高达 192 GB 的 HBM3 内存,以提供大型语言模型训练和生成 AI 工作负载推理所需的计算和内存效率。

借助 AMD Instinct MI300X 的大内存,用户可以在单个 MI300X 加速器上安装 Falcon-40 等大型语言模型,40B 参数模型.。AMD 还推出了 AMD Instinct™ 平台,该平台将八个 MI300X 加速器整合到一个行业标准设计中,为 AI 推理和训练提供终极解决方案。

活动上AMD 董事长兼首席执行官苏姿丰( Lisa Su)称,MI300X是AMD真正为生成式人工智能设计的产品,比起英伟达的H100芯片,MI300X提供了2.4倍多的内存和1.6倍多的内存带宽,生成式AI和大语言模型需要电脑的算力和内存大幅提高。此前,路透报导称亚马逊旗下云计算业务正考虑使用AMD的新款人工智能(AI)芯片。

AMD Instinct MI300X 加速器展示

AMD Instinct MI300X 加速器展示

此外,AMD 还宣布,全球首款用于 HPC 和 AI 工作负载的 APU 加速器 AMD Instinct MI300A现已向客户提供样品。MI300X 从第三季度开始向主要客户提供样品。

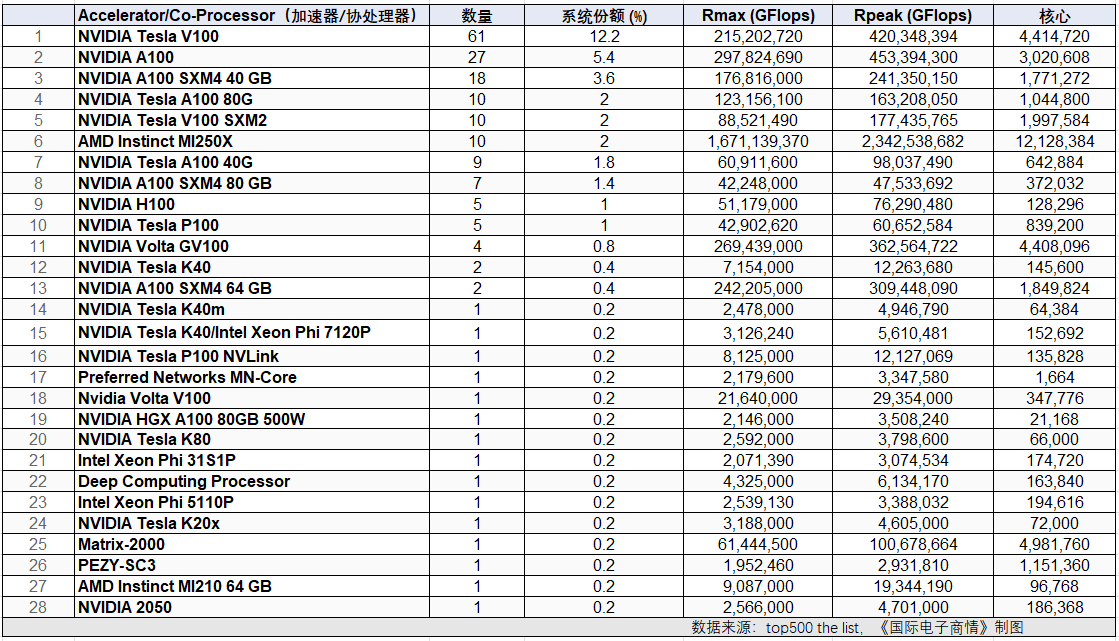

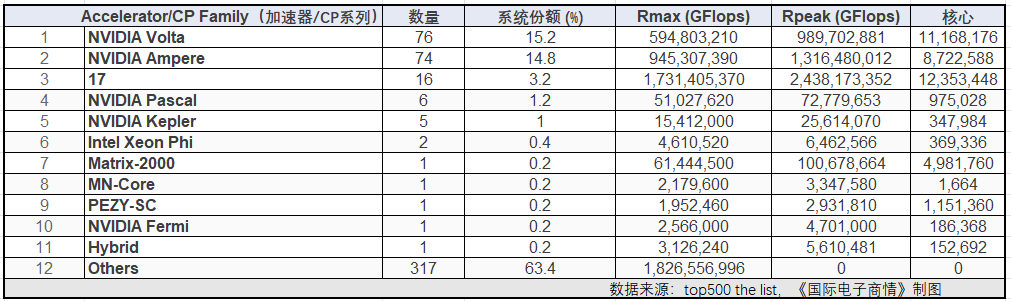

此前,在6月初发布的第 61 期全球超级计算机TOP500信息显示,在所有超算采用的加速器/协处理器(Accelerator/Co-Processor)数量上,NVIDIA(英伟达)为最大赢家。在前28大加速器/协处理器产品中,有20款来自NVIDIA,仅1款来自AMD。

其中,NVIDIA Tesla V100、NVIDIA A100、 NVIDIA A100 SXM4 40GB、NVIDIA Tesla A100 80G、 NVIDIA Tesla V100 SXM2及AMD Instinct MI250X 位居前六名,安装量分别为61套、27套、18套、10套、 10套、10套,对应占比分别为12.2%、5.4%、3.6%、2%、2% 、2%.

随着人工智能大模型的快速发展,中国本土云计算企业和大型互联网公司正在加大对加速卡的投入。

据环球网科技综合报道,字节跳动公司今年已向英伟达订购了价值超10亿美元(约为70亿元人民币)的GPU产品。

报道称,据知情人士透露,字节跳动已经采购了10万块A100与H800加速卡,其中H800于今年3月才开始生产。目前,仅这一家公司今年的采购数额就已接近英伟达去年在中国销售的商用GPU总销售额。