为了不断满足人工智能和机器学习需求的迅速增长,算力在快速增长,数据量也在快速增长。

现在ChatGPT等人工智能相关的应用程序,它的增长速度以及对数据的需求更是非常庞大,而且ChatGPT-3是以1750 亿个参数进行训练的。这些人工智能应用的快速发展,也对处理器及带宽提出了更高的要求和标准。

“市面上越来越多的客户和公司都开始专注于开发自己个性化、定制化的处理器产品,以更好地满足神经网络以及专属应用的需求。”Rambus IP核产品英雄高级总监Frank Ferro说道。

此时,内存墙问题越来越成为制约算力的重要问题。Frank表示:“尽管算力的增长非常显著,但是带宽上的进步却无法改善,也就是造成两者间的不匹配,很多计算资源并没有被充分利用到。”

正是由于对带宽需求更加进一步的增加,以及对需求的上涨,驱动了像Rambus公司一样不断打造新一代的产品,提高内存带宽以及接口带宽。实际上,根据Rambus 5月初刚刚公布的2023年一季度业绩公告,在内存接口芯片的推动下,季度产品收入达到 6380 万美元,同比增长 33%,总营收达到了1亿1400万,均创出新高。

HBM还是GDDR

人工智能的应用场景可划分为训练和推理两部分,其中训练是指通过大数据训练出一个复杂的神经网络模型,通过大量标记过的数据来训练相应的系统,使其能够适应特定的功能。而推理则是利用训练好的模型,使用新数据推理出各种结论。借助神经网络模型进行运算,利用输入的新数据来一次性获得正确结论的过程。

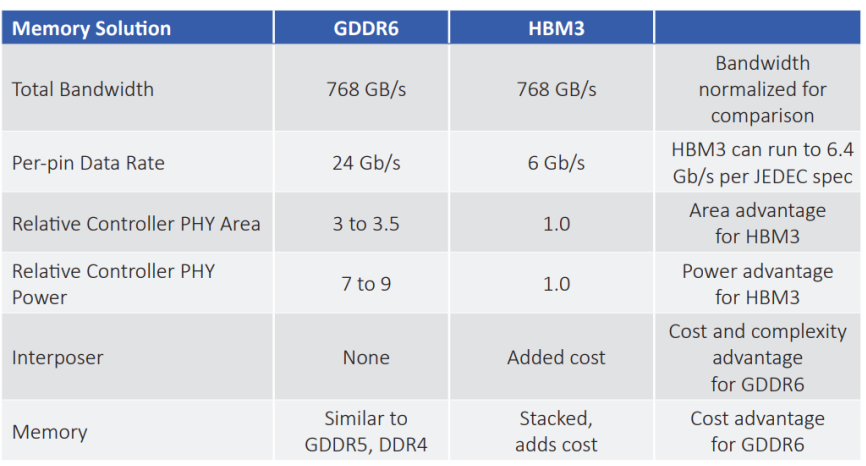

训练和推理在算力和存储上的需求并不完全相同,训练需要更大的数据进行分析,而推理则更注重成本。也正因此,产业界诞生了包括HBM与GDDR两种存储解决方案,以适应不同的场景要求。

AI推理场景带宽大概需要400-500Gb/s的带宽,如果用HBM3,带宽可以提高至800Gb/s,但却是大材小用,同时成本会增加3-4倍之多。

HBM(高带宽内存)于 2013 年推出,是一种高性能 3D 堆叠 SDRAM架构。如其名称所述,HBM最重要的是带宽更高,尽管HBM的内存都以相对较低的数据速率运行,但其通道数更多。例如,以3.6 Gbps运行的HBM2E在存储和处理器间的通道数达到了1024条,这无法在PCB上实现,因此硅中阶层(interposal)被用来连接内存和处理器。

GDDR的历史

随着AI的推理越来越多地向边缘设备上进行集成和转移,GDDR越来越成为边缘AI处理所需。比起HBM,GDDR的历史则更为悠久。GDDR可以追溯到PC和游戏机时代,早期的GPU使用SDRAM和DDR,这与CPU相同。随着对GPU性能追求增强,推动了GDDR专用图形显示的需求增长。

2003 年 10 月,英伟达推出了 GeForce FX 5700 Ultra,搭配了256 MB GDDR2 DRAM,当时5000系列大部分仍使用DDR DRAM。直到 2018 年底 GeForce 16 和 20 系列,GDDR被用于整个产品线。如今,GDDR6 是最先进的显存解决方案。

相比于LPDDR和DDR,GDDR在带宽关键参数上具有绝对优势,在24Gb/s传输速率和32位总线的时候,GDDR6可以提供最多96GB/s的带宽,在速度、带宽和延迟方面显著优于其他产品。

Rambus GDDR6方案

Rambus提供业内鲜有的全面内存IP产品组合,包括DDR、LPDDR、GDDR以及HBM,此外还有连接类Serdes,诸如PCIe和CXL,均达到了业界领先水平。并且Rambus的解决方案大多是提供包括控制器和PHY在内的全套方案。

为了应对边缘AI对于GDDR的需求,Rambus日前推出的GDDR6 PHY,提供市场领先的数据传输速率,最高可达24 Gb/s,能够为每个GDDR6内存设备带来96 GB/s的带宽,达到了行业标杆水平。此前GDDR6的传输率为16Gb/s,总带宽64GB/s,全新的GDDR6使带宽增加了50%,从而为人工智能/机器学习(AI/ML)、图形和网络应用提供更高成本效益、高带宽的内存。并凭借与Foundry的密切合作,支持先进的工艺节点。

除了业界领先的24Gb/s性能外,Rambus GDDR6 PHY还经过了全方位的优化,可满足AI/ML及其他需要高带宽、低延迟内存解决方案的先进应用的需求。Rambus能够实现24Gb/s的数据传输速率,依靠的是其在信号完整性和电源完整性(SI/PI)方面享誉世界的专业知识,这些知识可用于设计PHY、芯片封装和印刷电路板(PCB)。

此外,Frank还强调Rambus的工程师会和客户在设计初期就紧密合作,并提供封装参考设计,以确保系统达到最优性能。

总而言之,Rambus的GDDR6方案在性能、功耗管理、集成、完整性、以及支持等方面都具有明显优势,是提升边缘计算能力的理想合作伙伴。