一、各传感器的优劣势

1.激光雷达:优点:一般情况下精度准确、360度的感知范围、3维数据(相对于相机具有深度信息)缺点:成本高昂、数据量大、无序且稀疏(对于单个物体而言,其数据点更少,类似于一张具有深度信息低分辨率的广角照片)

2.相机优点:纹理细节丰富、成本低廉缺点:易受光照影响、没有深度信息

3.毫米波雷达:优点:在特殊场景下(雨雾天气)相对Lidar抗干扰能力强;基于多普勒效应的探测原理能捕捉到一定运动信息;长波长(毫米波)能够检测到一些corner场景下的目标缺点:精度较低(以点云表达后,数据稀疏且高度信息费城不准;对相对静止的物体检测效果差,并非所有静止物体

4.红外相机:夜视场景,是优点也是局限二、解决方案没有详细调研过各企业最终落地的传感器配置方案,但看过不少waymo、百度、nvidia多传感器融合的研究,所以更多地从理论和技术角度分析一下各种解决方案。

1.激光雷达+相机

当前主流的多传感器融合方案,采用相机和激光雷达相互的方式进行3D检测。将图像数据和点云统一坐标系后,结合图像提供的丰富的物体纹理信息和点云提供的几何结构信息有助于分类任务;点云提供的精确3维信息以及物体在物理世界自然分离的特点有助于改善图像中目标相互重叠的情况,从而更精准地进行目标检测。一些经典的方法比如MV3D、Frustum Pointnet以及同作者出的ImVotenet等,随便一篇融合的论文的related work都会有较详的综述,在这就不多重复了。

目前对于此类融合的算法研究较多,理论研究短期内很难有较大创新,但在工程实践中两种传感器相互辅助的方式可以更加多样化,且必须在考虑算力的前提下,结合不同的场景自适应地调整对不同数据源及特征置信度可能才能真正发挥激光雷达和相机融合的作用。

2.毫米波雷达+相机

若采用点云形式表达毫米波数据,那其实和Lidar和RGB融合原理相差不大,但效果会更差。另外,毫米波雷达还有range-doppler-azimuth(就是极坐标系下距离、角度以及多普勒特征)数据形式,经过一些数据处理后其实和image张量形式相差不大,因此可以采用传统CNN方法进行融合提取。关于毫米波雷达的多普勒特征可以算一个小的研究课题,有研究表明,多普勒效应能够捕捉到物体内部组件的振动特征,且毫米波雷达检测到的目标速度信息也是基于此原理。但自动驾驶对此研究并不多,工业应用就更少了。

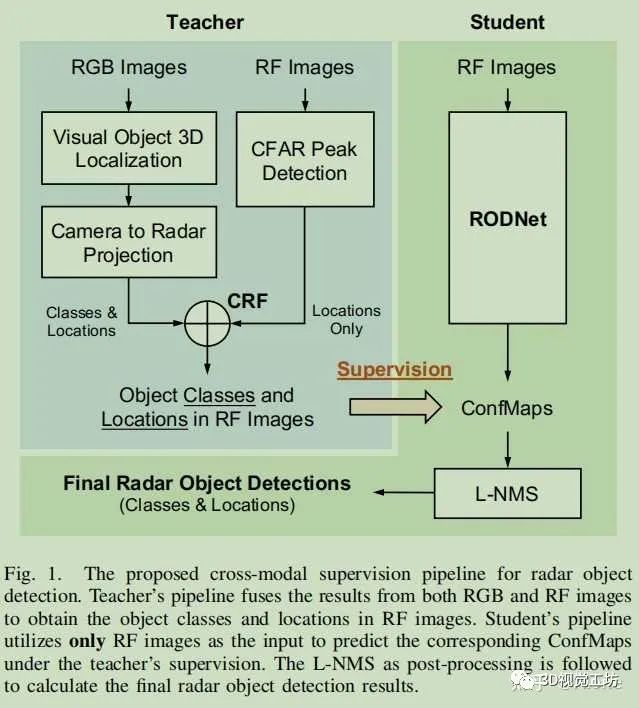

个人认为微多普勒特征的应用虽有理论支持,但在自动驾驶复杂场景以及对安全的高要求下,其性能表现并不稳定和鲁棒,因此没有得到广泛应用。另外,在4D radar实现技术突破能够量产以后,这种特别的特征在自动驾驶场景也许只是锦上添花。这篇研究[1]则采用这种新的表征形式来融合radar和image的特征,结合模仿学习的理念进行radar检测。

图1

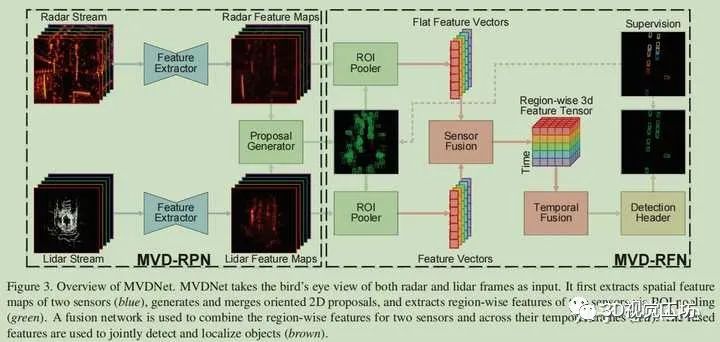

3.毫米波雷达+激光雷达

这篇研究[2]是2020CVPR的一篇文章,研究指出:在雾天场景下,Lidar点云会受到很大干扰,增加很多噪点;而radar的生成的点云虽然稀疏,但几乎不受雾的干扰,因此采用此融合方式可以改善在雾天场景下的3D检测表现。图2为该研究主要框架。

图2

4.RGB相机+红外相机:主要用于夜视场景的检测由于应用场景有限,目前更多的是用于学术界的理论研究。但如果真的要实现全天候的自动驾驶,可能终究跨不过类似夜视的长尾场景,只是目前还没发展到那个阶段而已。

总结来看针对工业界目前近几年L3+的目标,除特斯拉能依靠大规模真实驾驶数据来实现纯视觉的自动驾驶方案以外,其他造车新势力无不加持了激光雷达,同时结合多摄像头实现感知功能。radar和超声传感器等基本已是现代汽车的标配,只是如何使用的问题。单说传感器的配置方案,可能激光雷达+相机将会是主流(除特斯拉)。但更加具体和成熟的解决方案必须结合自动驾驶的基础系统来实现,并基于一定的机制来自适应调整从而灵活应用各传感器的数据特征,明确:一般场景采用什么方式节省算力?不同场景更加信任哪种数据?特殊场景如何安全兜底?等问题的处理机制,在大多数场景下能够表现稳定,才能真正胜出!