人工智能AI吹起新一轮科技革命浪潮,衍生出诸多新兴应用,庞大的需求驱动存储技术更迭。随着AI模型和数据集不断扩大,高效、高性能的存储显得愈发关键,符合AI模型需求的DDR、GDDR、HBM技术从幕后走向台前,并随着AI发展而不断推陈出新。

01

DDR不断沿袭,DDR6即将来临

DDR完整的应该称DDR SDRAM,英文全称为Double Data Rate SDRAM,中文含义是双倍速率同步动态随机存储器”,应用于高性能服务器、台式机、笔记本电脑及其他设备中,该技术将高带宽和高能效结合在一起,可以使性能翻倍。

从本质上讲,DDR是现有SDRAM内存的一种进化,SDRAM在一个时钟周期内只传输一次数据,是在时钟的上升期进行数据传输,而DDR内存在一个时钟周期内可以传输两次数据,它能够在时钟的上升期和下降期各传输一次数据,因此得名“双倍速率同步动态随机存储器”。在与SDRAM相同的总线频率下,DDR内存可以达到更高的数据传输率,带来优异的数据处理性能。

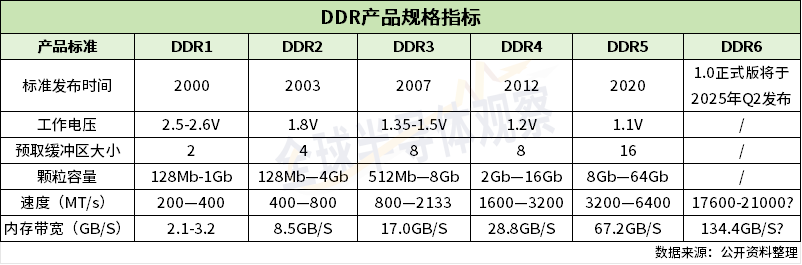

SDRAM根据时钟边沿读取数据情况分为SDR、DDR技术。经过多年的发展,DDR已从第一代DDR SDRAM,第二代DDR2 SDRAM,第三代DDR3 SDRAM,第四代DDR4 SDRAM,发展至第五代DDR5 SDRAM、第六代DDR6 SDRAM。

随着技术的进步,DDR内存的版本不断更新,每一代的DDR产品都提供更高的带宽和更低的功耗。从目前主流的DDR4、DDR5来看,DDR5内存的工作电压进一步降低至1.1V,相较于DDR4进一步提高了能效,带宽相较于DDR4有大幅提升。

据JEDEC(固态技术协会)6月初消息,DDR6(包括LPDDR6)已明确会以CAMM2取代使用多年的SO-DIMM和DIMM内存标准。DDR6内存最低频率8800MHz,可提高至17.6GHz,理论最高可以推进至21GHz,远超DDR4和DDR5内存。

业界认为,从市场普及来看,DDR6采用的标准是全新的CAMM2,生产设备也要做大规模替换,这会带来全新的成本结构。同时,存量市场的新标准迭代也会受限成本要求,这都限制了DDR6或LPDDR6的大规模普及速度。

图片来源:全球半导体观察制表

高速、高性能的DDR内存颗粒成为在人工智能、云计算、物联网、计算机等领域的优选存储方案。从AI领域来看,AI算法需大量数据训练与推理,DDR作为电脑内存的主要组件,能确保数据传输及存储稳健可靠;云计算领域,DDR在云服务器内承担大容量数据处理与传输的重任;物联网领域,物联设备需要满足低耗能、高效率以及稳定可靠的特性,DDR恰好满足上述要求,可实现设备间的有效连接与交互。

02

探索GDDR过往,GDDR7已来

GDDR英文全称Graphics Double Data Rate DRAM,是专为图形处理而设计的高性能DDR存储器规格,简称为显存。显存最关键的应用领域便是显卡,后者应用于新媒体和电脑游戏、炒卖加密货币、AI强化学习(如ChatGPT、Sora)等领域。而用于显卡的DRAM,需要具备两个关键的特性,高密度寻址能力和配备的高性能,早期因主要考虑兼容CPU,显卡大多采用DDR内存,不过近年随着图像处理需求的增加,显卡逐渐转向专为GPU设计的GDDR。

业界指出,GDDR有专属的工作频率、时钟频率、电压,因此与市面上标准的DDR存储器有所差异,与普通DDR内存不同,且不能共用。一般它比主内存中使用的普通DDR存储器时钟频率更高,发热量更小,具有更高的频率和带宽,所以更适用于中高端显卡。

目前,GDDR已成为人工智能、大数据应用领域中最热门的内存芯片之一。从类型上看,GDDR包括GDDR2、GDDR3、GDDR4、GDDR5、GDDR5X、GDDR6和GDDR6X等,GDDR5和GDDR6是高端显卡上常见的显存类型。其实,前两代的GDDR和GDDR2并没有得到GPU厂商的大规模应用,但随着性能的提升,第三代GDDR3数据传输速率最高达到2.5GHz,第四代GDDR4虽然性能有了进一步变化,但由于下游厂商对GDDR4标准意见不一,市场度接受度不高。为此GDDR3成为当时市场主流技术,包括英伟达和AMD等头部GPU厂商都使用的GDDR3。

从2008年后,产品更新至GDDR5,因具备更高的时钟频率和数据传输速率成为高性能显卡的标配,GDDR5与GDDR4、GDDR3一样,皆是基于DDR3技术开发而来。据悉,GDDR5之后,英伟达与美光共同合作推出GDDR5X半代产品,应用于前者的高端显卡。

据悉,英伟达是首家在其RTX 30 系列GPU中选择GDDR6X内存的供应商,至少是高端GPU。GDDR6X将每引脚带宽以14Gbps增加到21Gbps,将总带宽增加到1008GB/s,甚至超过3072位宽的HBM2堆栈。值得一提是,GDDR6X还引入了PAM4(Pulse Amplitude Modulation 4)信号技术,显著提高了数据传输速率。

图片来源:全球半导体观察制表

目前,今年来,美光、三星和SK海力士均表示已开始提供GDDR7内存样品。具体来看,三星GDDR7芯片通过首次应用PAM3信号,能够在仅1.1 V的DRAM电压下实现32 Gbps的速度,这超过了JEDEC的GDDR7规范中的1.2 V;SK海力士与其前身GDDR6相比,最新的GDDR7产品提供的最大带宽达到160GB/s,是其上一代产品(GDDR6位80GB/s)的两倍,功耗效率提升了40%,内存密度提升1.5倍;美光GDDR7具有28GB/s和32Gb/s两种速度,采用其1β (1-beta) DRAM 技术制造,其效率比GDDR6 提高了50%。

03

HBM成“军备竞赛”核心,主力来到HBM3E

HBM是高带宽存储器,属于图形DDR内存的一种,是通过使用先进的封装方法(如TSV硅通孔技术)垂直堆叠多个DRAM,与GPU通过中介层互联封装在一起。HBM具备高容量、高带宽、低延时与低功耗等特性,其优势在于打破内存带宽及功耗瓶颈。不过,HBM由于其复杂的设计及封装工艺导致产能较低同时成本较高,HBM的平均售价至少是DRAM的三倍。

图片来源:SK海力士

与传统DRAM芯片相比,HBM具有高带宽、高容量、低延时与低功耗等优势,可以加快AI数据处理速度。业界指出,HBM可以将专用数据处理器直接集成在DRAM中,将部分数据计算工作从主机处理器转移到存储器当中,从而满足AI芯片训练的高宽带要求,也因此更适用于ChatGPT等高性能计算场景。

图片来源:全球半导体观察制表

从技术迭代上看,HBM已经从HBM、HBM2、HBM2E,发展至被业界认为即将成为市场主流的HBM3、HBM3E,未来或将到达HBM4,甚至HBM4E。从大厂最新动态来看,三星已开始向客户提供HBM3E 12H样品,预计于今年下半年开始大规模量产;美光已开始量产HBM3E,英伟达H200 Tensor Core GPU将采用美光8层堆叠的24GB容量HBM3E内存,并于2024年第二季度开始出货;SK海力士已成功量产超高性能用于AI的存储器新产品HBM3E,实现了全球首次向客户供应现有DRAM最高性能的HBM3E。

至于HBM4,业界称,随着内存传输速率要求不断提高,尤其是在DRAM单元的基础物理原理没有改变的情况下,这一速度将无法满足未来AI场景下的数据传输要求。HBM从每堆叠1024位元增加到每堆叠2048位,HBM4将带来突破性变革,采用2048位元内存接口,理论上也可以使传输速度再次翻倍。

TrendForce集邦咨询预计,HBM4有望于2026年推出。目前包含NVIDIA以及其他CSP(云端业者)在未来的产品应用上,规格和效能将更优化。例如,随着客户对运算效能要求的提升,HBM4在堆栈的层数上,除了现有的12hi (12层)外,也将再往16hi (16层)发展,更高层数也预估带动新堆栈方式hybrid bonding的需求。HBM4 12hi产品将于2026年推出;而16hi产品则预计于2027年问世。

从市场格局来看,目前,HBM市场高度集中,呈现三足鼎立的态势。此前据TrendForce集邦咨询研究显示,2022年三大原厂HBM市占率分别为SK海力士(SK hynix)50%、三星(Samsung)约40%、美光(Micron)约10%。

结 语

AI就像一颗巨大能量的陨星,给予内存市场最新的冲击。随着市场提出的新挑战,三星、美光、SK海力士等大厂正埋头专心研发,致力于引领下一代图形内存技术的发展。业界十分关心的性能、能效、成本等问题,上述中提到的DDR、GDDR、HBM技术将如何发展,大厂们在这场内存技术竞赛中又将带来何种新的解决方案,让我们拭目以待。

全球市场研究机构TrendForce集邦咨询此前预计,2023年HBM产值占比之于DRAM整体产业约8.4%,至2024年底将扩大至20.1%。同时,新型存储技术也不断涌现,3D DRAM时代即将开启;SCM潜力即将释放,PCIe 6.0/7.0蓄势待发…

6月19日(周三),TrendForce集邦咨询将在深圳隆重举办“2024集邦咨询半导体产业高层论坛(TrendForce Semiconductor Seminar 2024)”。

届时,集邦咨询资深研究副总经理吴雅婷将发表《从HBM火爆看内存产业发展趋势》的主题演讲,敬请期待!

封面图片来源:拍信网

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服