1. 多传感器融合需求概述

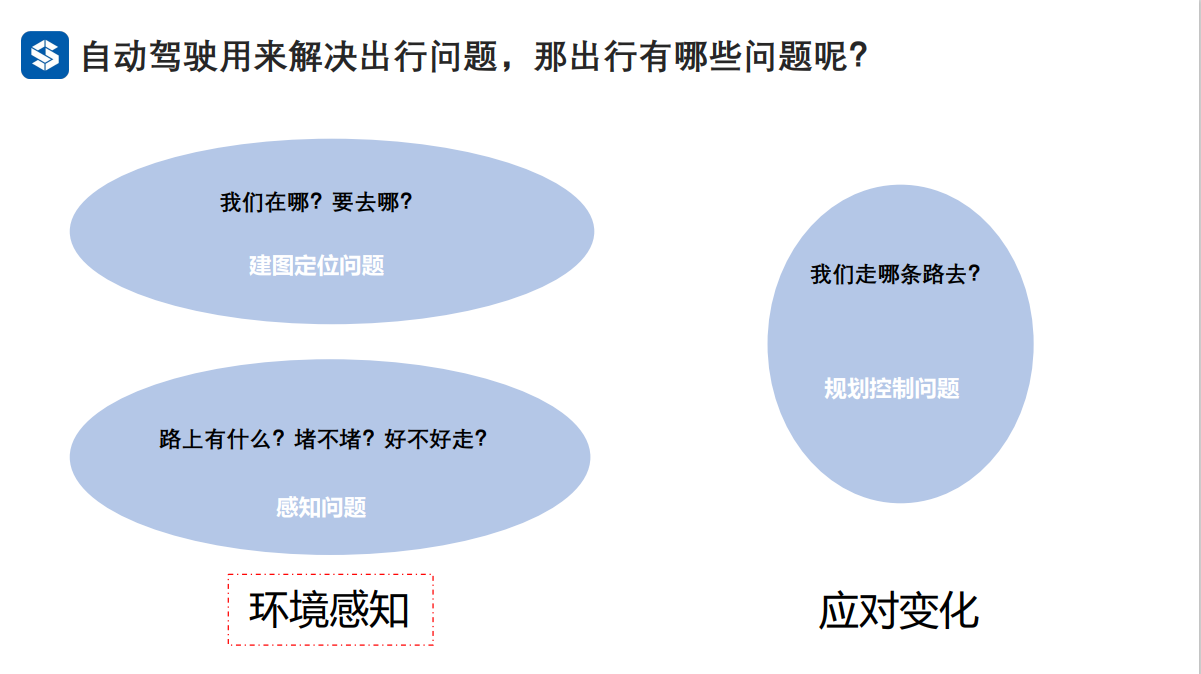

建图定位:感知自身状态;环境感知:感知外部状态

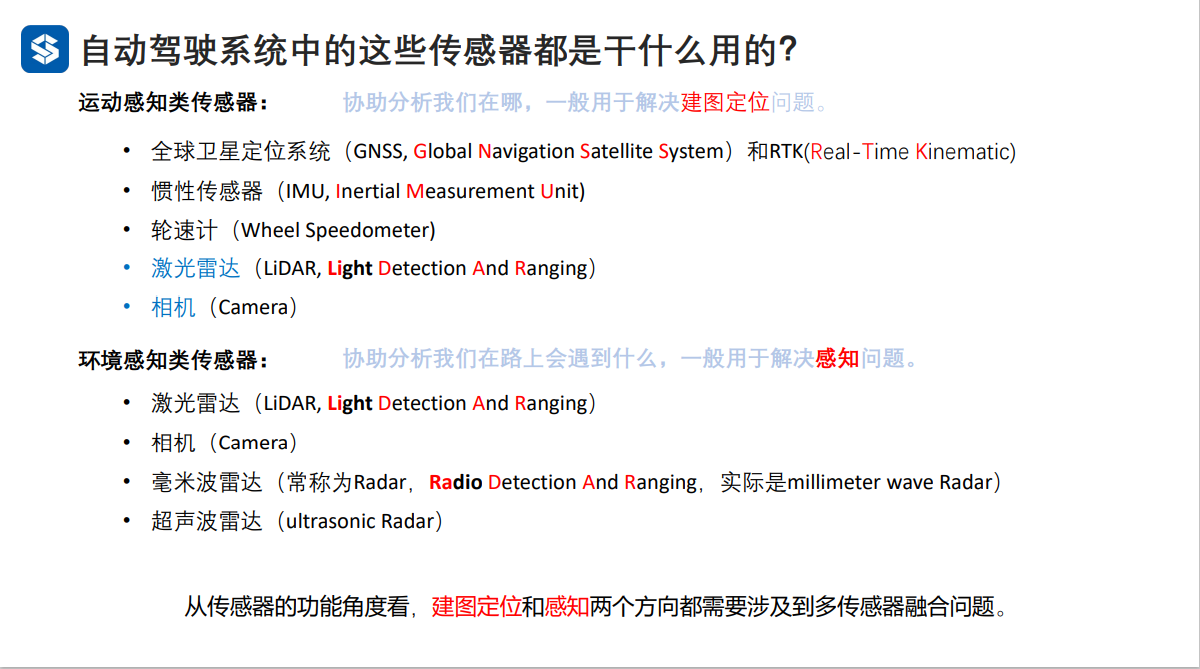

根据传感器测量的是自身状态还是周围环境状态,可分为主要用于建图定位的运动感知类传感器和环境感知类传感器。

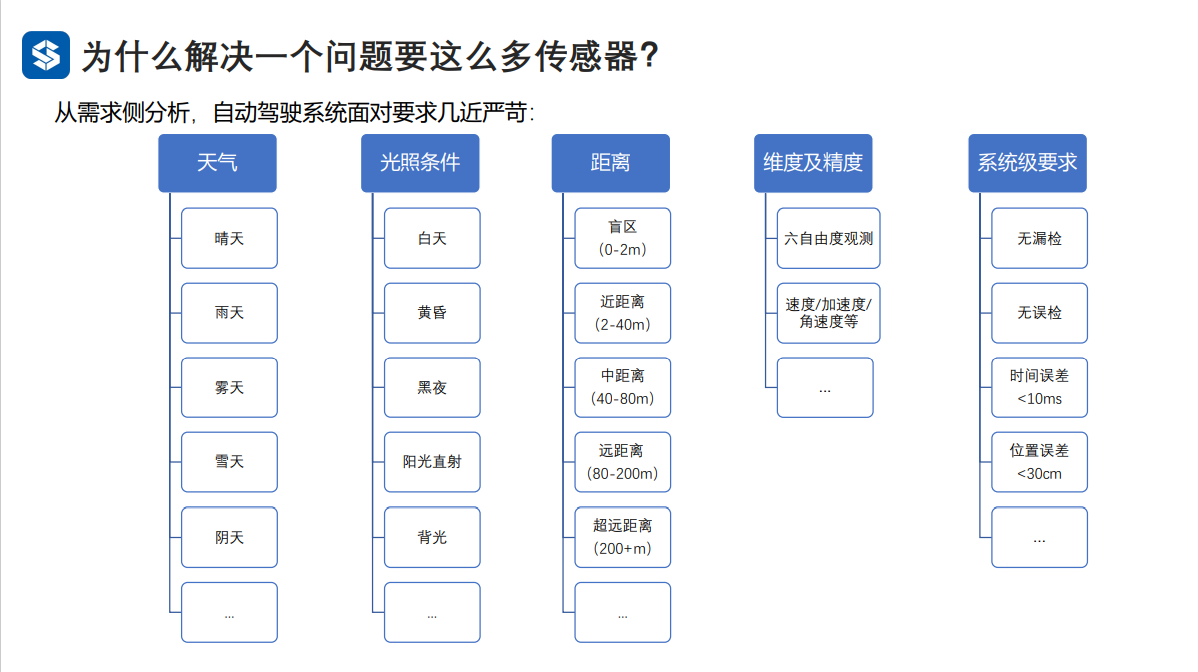

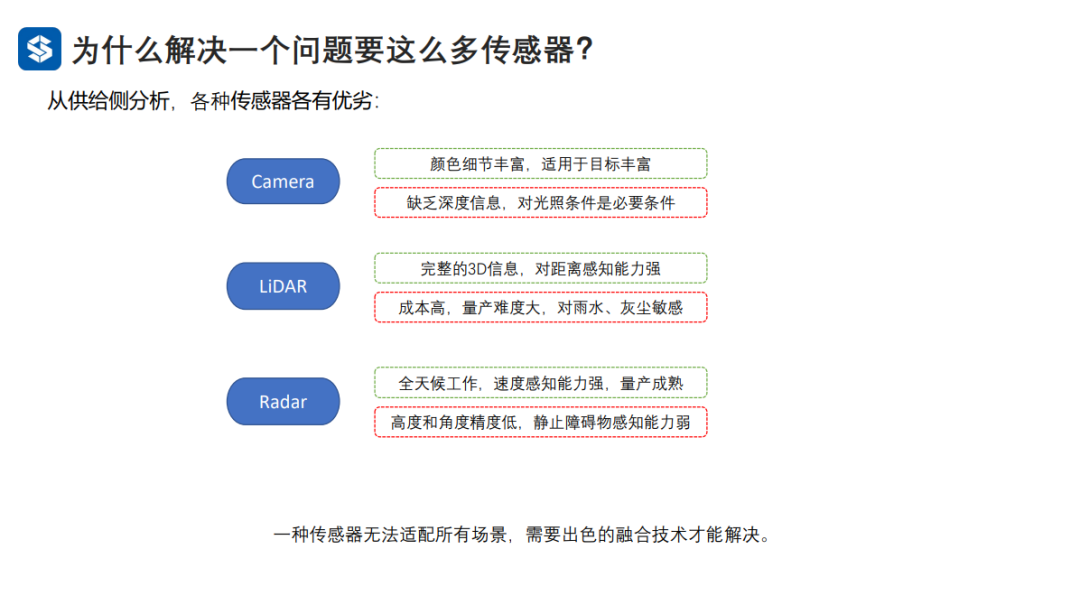

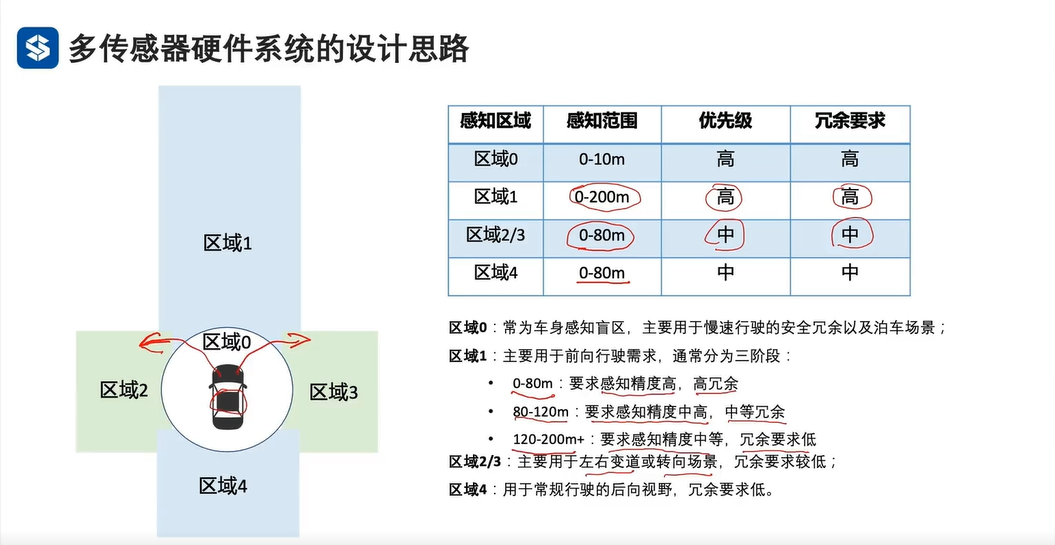

一种传感器无法满足需求侧所有场景的感知,因此需要对多种传感器进行融合,取长补短。 2. 多传感器硬件系统的构建 2.1 环境感知多传感器分析

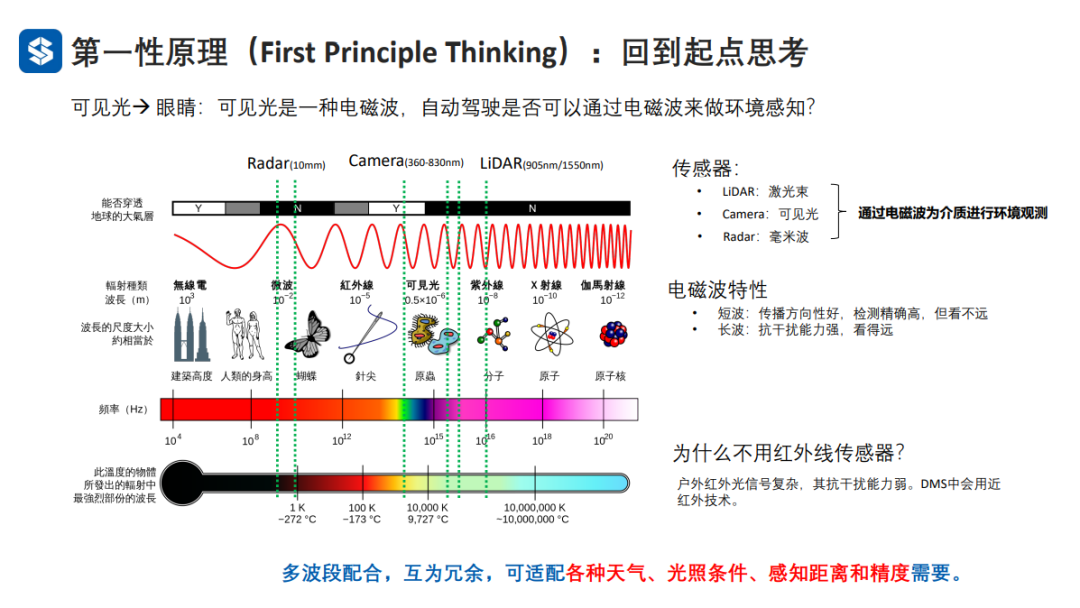

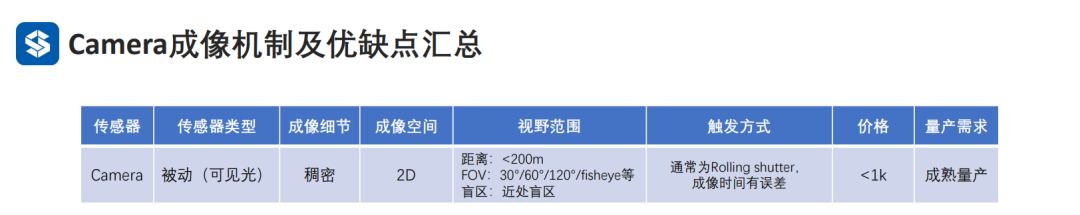

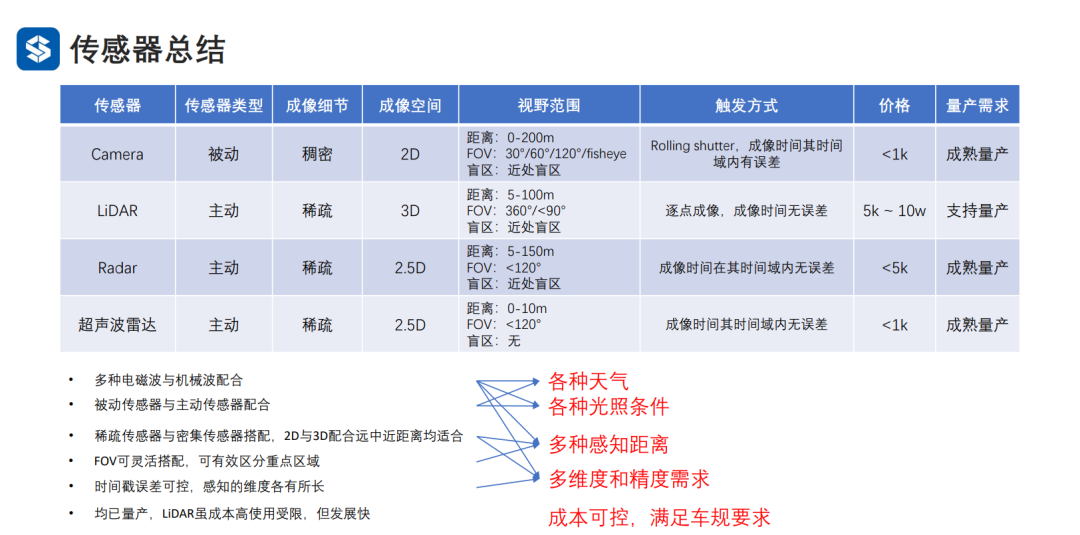

人可以通过看和听来感知世界,车也可以。 通过看的方式,主要是借助电磁波。按照波长由大到小,依次是毫米波雷达、相机、激光雷达。不用红外线波段的原因是室外或开放空间的热源较多,易受干扰。通过听的方式,主要是借助机械波。超声波是一种机械波,可以强化近距离检测的能力。 从传感器底层的物理特性上看,电磁波(cameraRadarLidar)加机械波(超声波雷达)的搭配是合理的。多波段互相配合,可满足不同光照、天气、感知距离和精度的要求。 2.1.1 四种传感器的成像特点 1) Camera

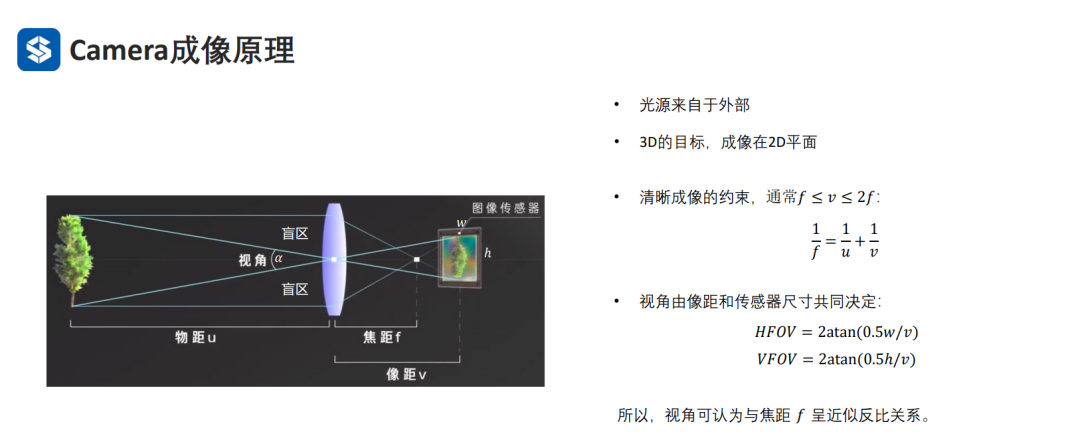

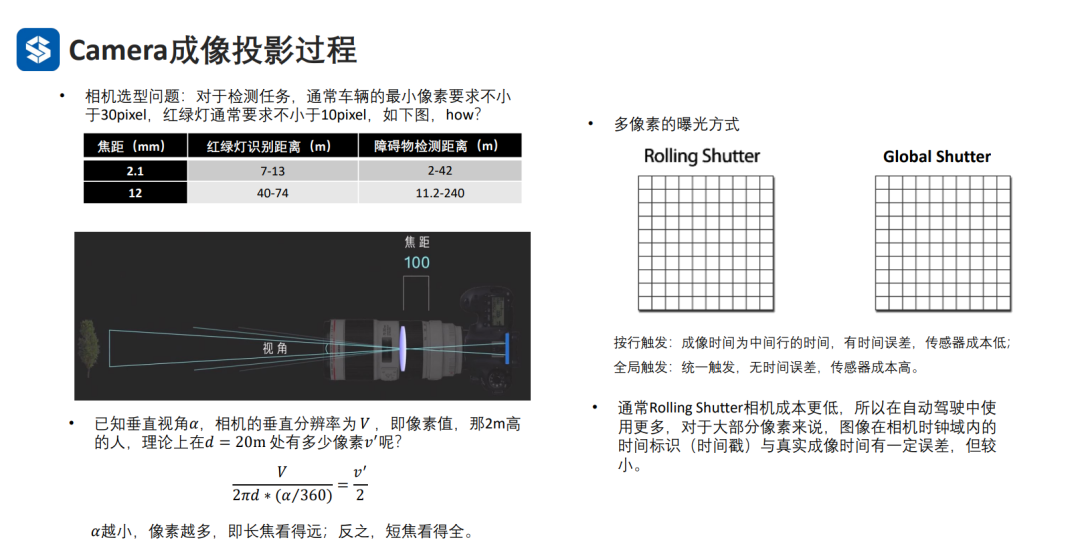

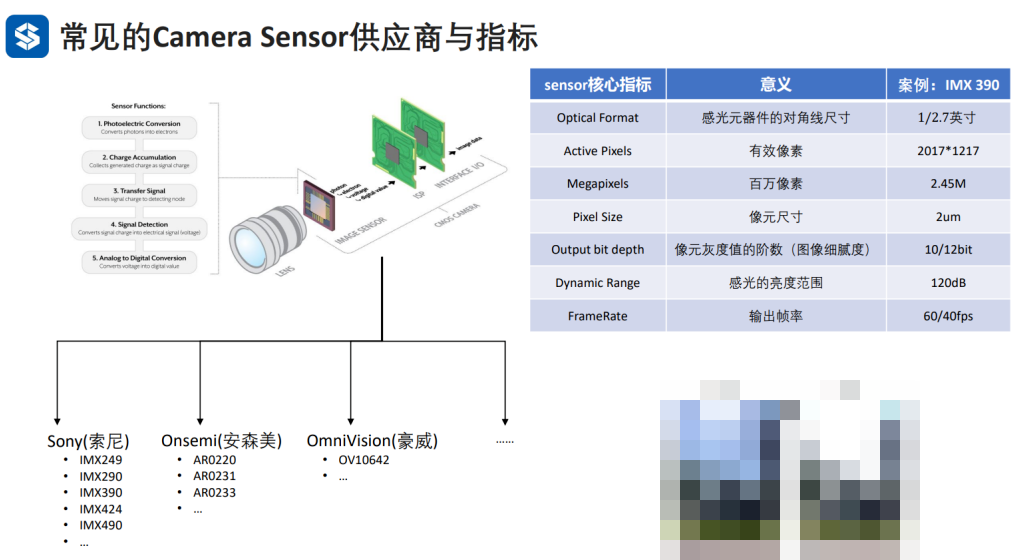

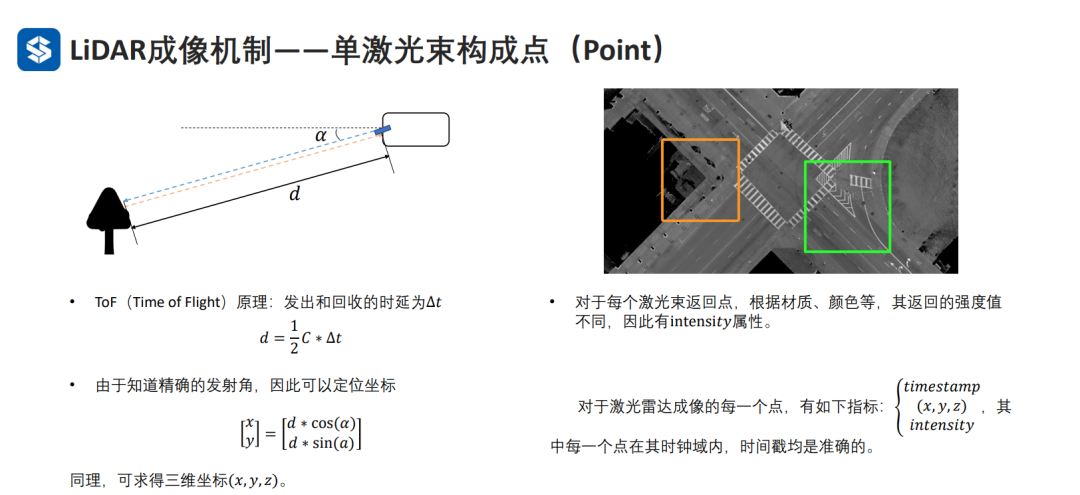

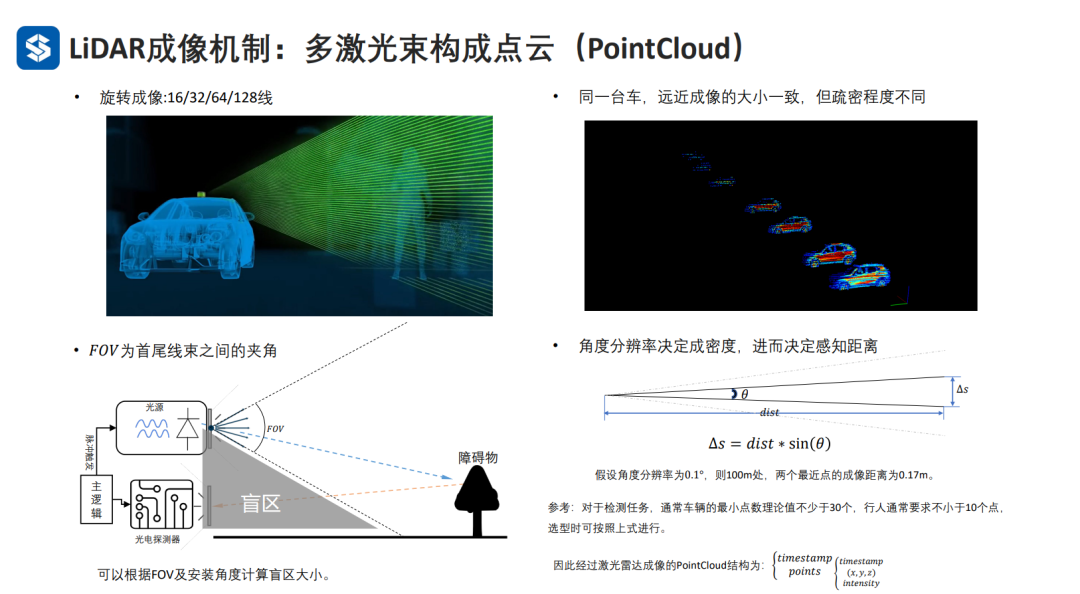

焦距越短,视角越大。Rolling是按行曝光的,左上角和右下角的像素值存在时间差,会造成畸变,但是成本更低。 2) Lidar

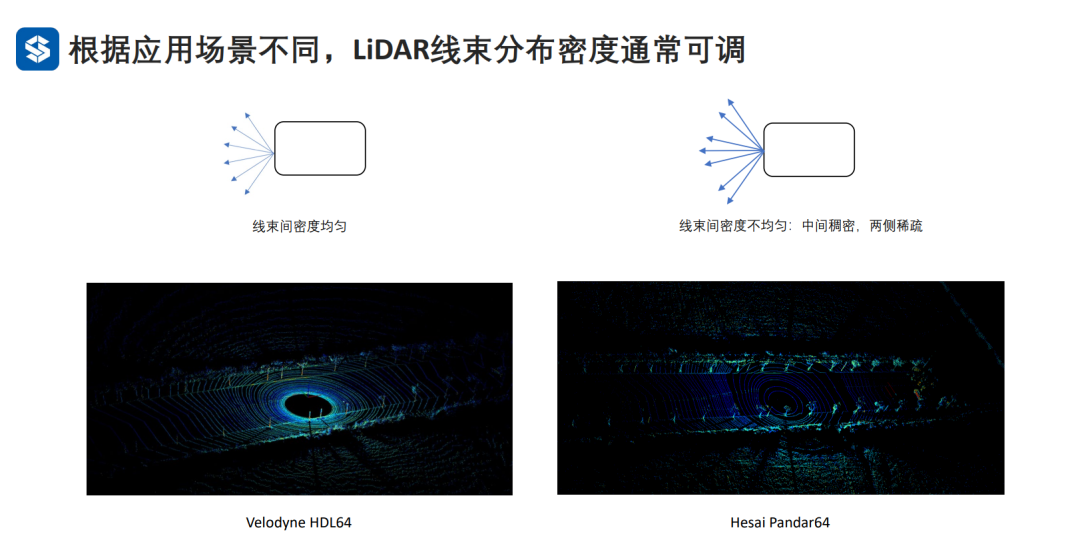

均匀线束:近距离点密,中距离点疏; 不均匀线束:近距离和中距离稀疏程度差不多

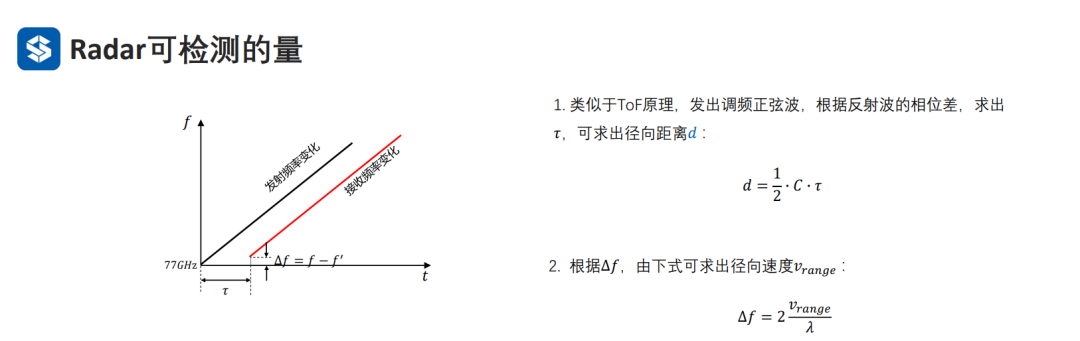

3)Radar

() 根据回波的频率变化可以得到障碍物的相对速度变化

将毫米波转到频域,根据频域里面成像的波峰值去求取障碍物上的每个点,再通过聚类多个点形成障碍物的检测结果。因此,在用设定的阈值去卡峰值的时候,阈值不能太高,否则造成漏检,也不能太低,否则噪声点较多,信噪比较低。

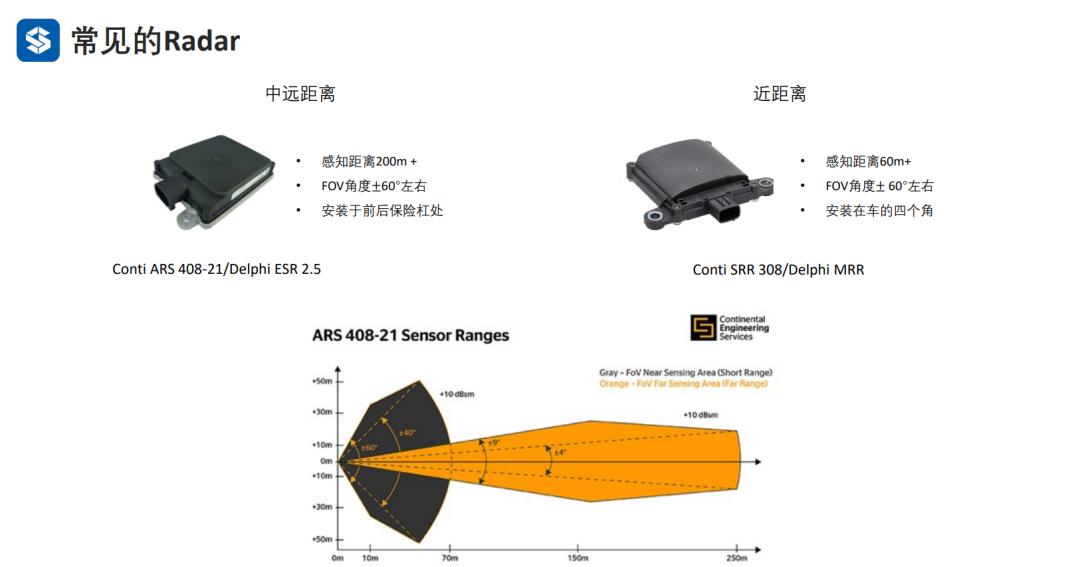

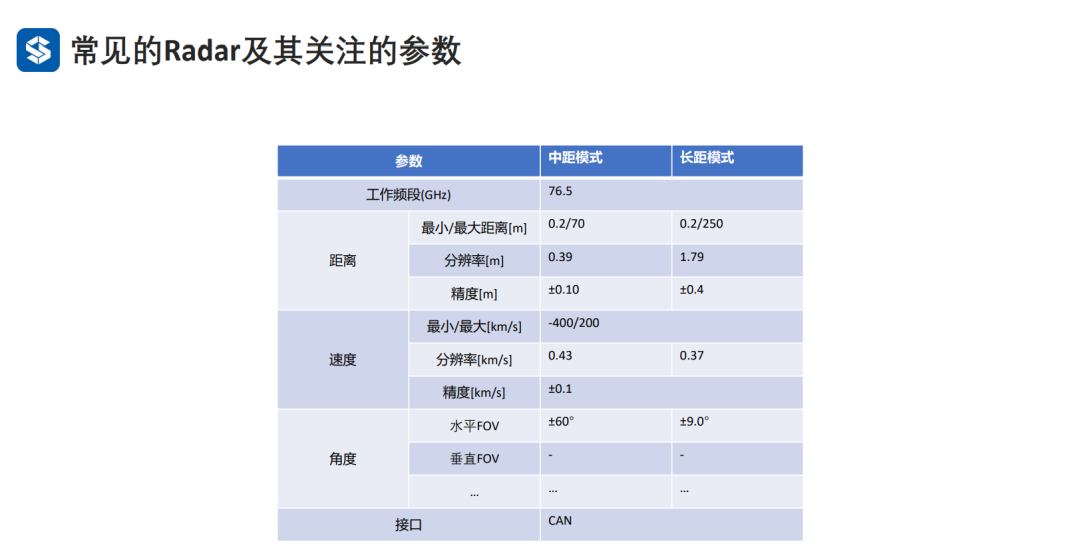

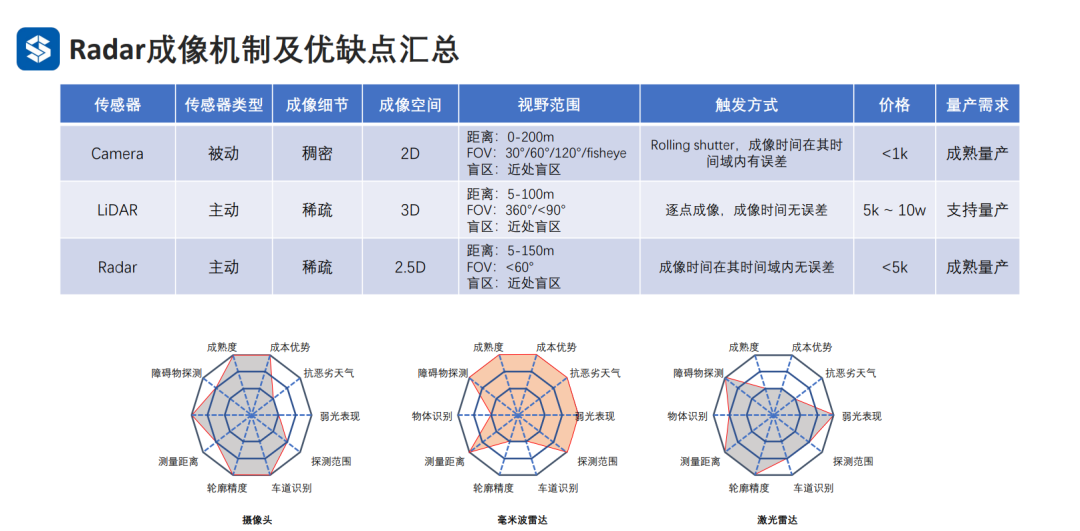

毫米波雷达和激光雷达都可以测出(x,y,z,强度),但是毫米波雷达生成的点云通常要比激光雷达稀疏。毫米波雷达适用于全天候工作(精度较低),而激光雷达的精度较高,未来应该是一种互补竞争的关系。 从各种传感器的雷达图分布可以看出,camera主要分布于左半边,毫米波雷达主要分布于右上角,激光雷达主要分布于左下角,因此采用三种传感器进行融合感知是有意义的。 4)超声波雷达

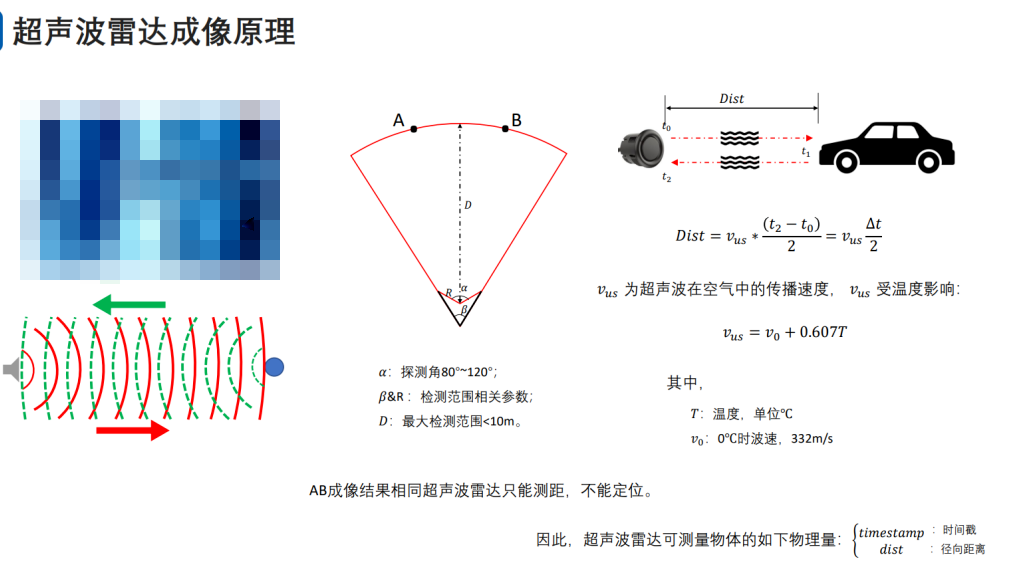

超声波雷达只能探测到前方多远的距离有障碍物,但是无法精确定位:对于同一弧长上的障碍物,超声波雷达的成像是一样的。

超声波雷达没有像其它传感器那样大量使用的原因

●

对温度敏感;波传播速度慢,对速度敏感;

CT方向性差,无法精确定位;抗干扰能力强,防水防尘能力强。

多种传感器相互搭配使用可以满足对于各种天气、光照、距离、维度和精度的感知要求。机械波协助电磁波,强化短距离感知能力。 2.2 建图定位多传感器简介

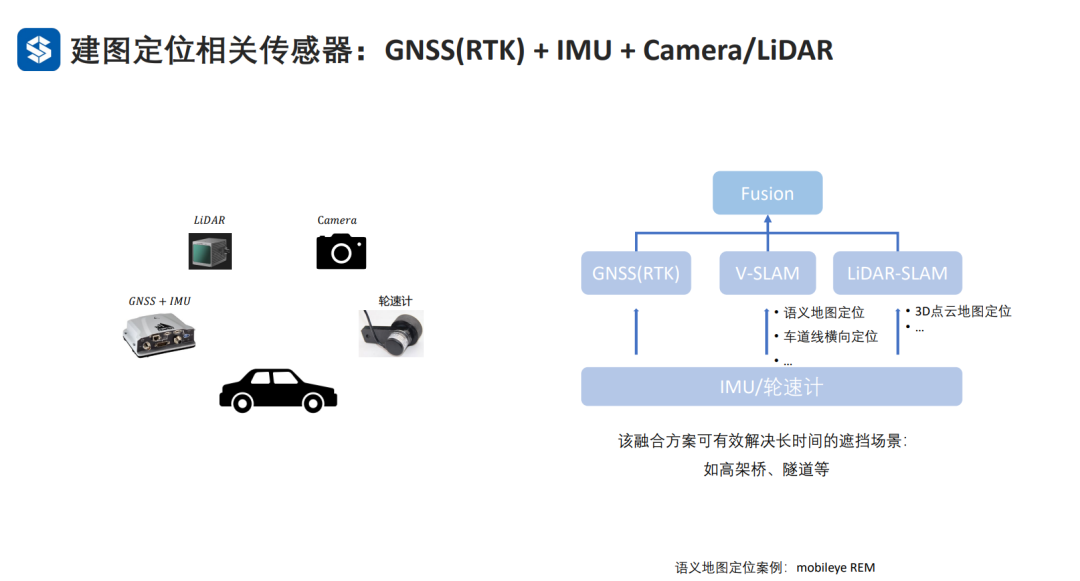

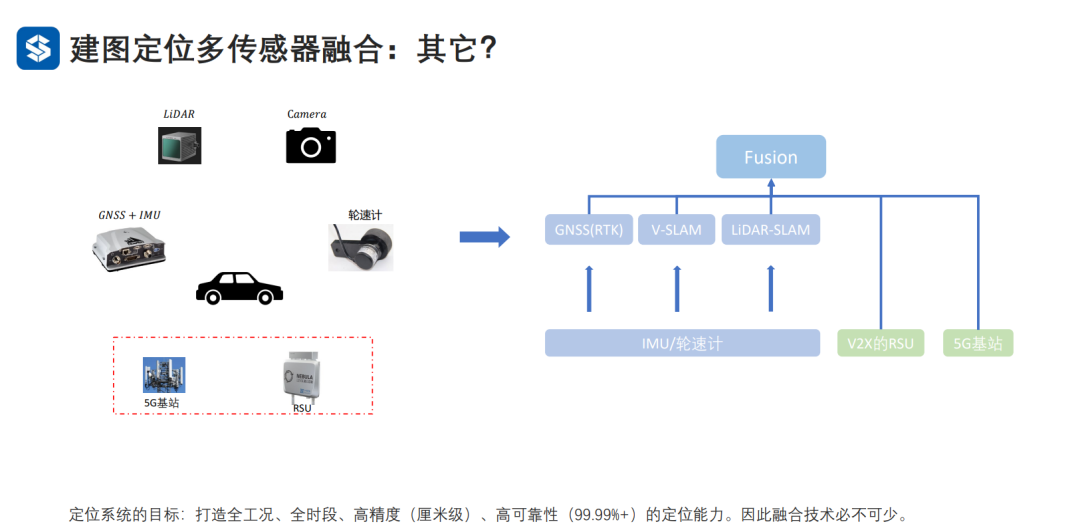

GNSS和RTK基站通信,RTK基站再和车辆进行通信,抵消GNSS和车辆直接通信的误差。但是,实际中如果存在遮挡,定位误差会变大,通常需要借助相机或者激光雷达进行辅助的建图与定位。为了更进一步提高定位的精度和可靠新,可以将RTK基站更换为分布更密更广的5G基站以及增加路端设备RSU进行辅助定位。

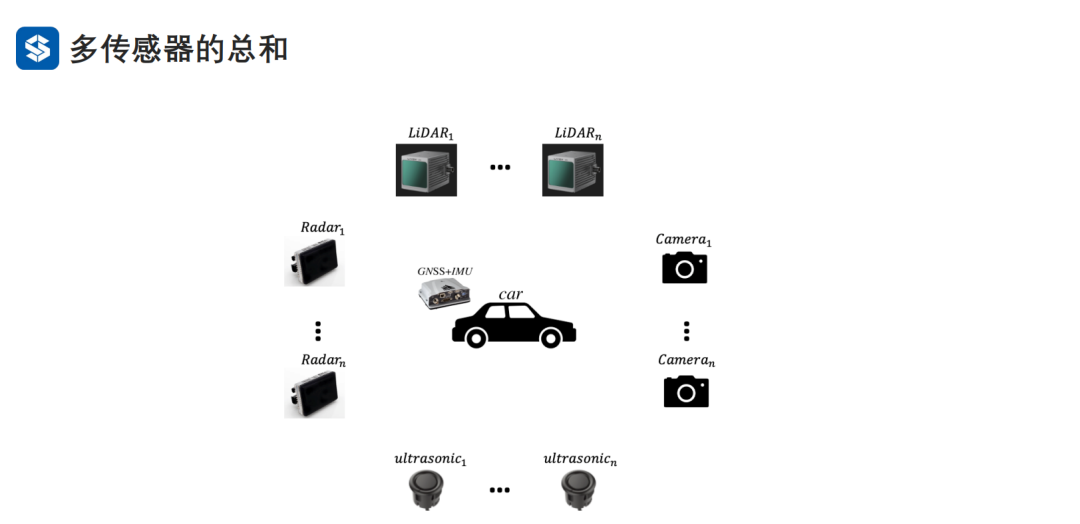

最终的一套综合环境感知和建图定位需求的传感器系统包括GNSS/IMU和多个摄像头激光雷达毫米波雷达超声波雷达,并且多传感器融合感知与定位技术是必不可少的。 2.3 整车传感器系统设计

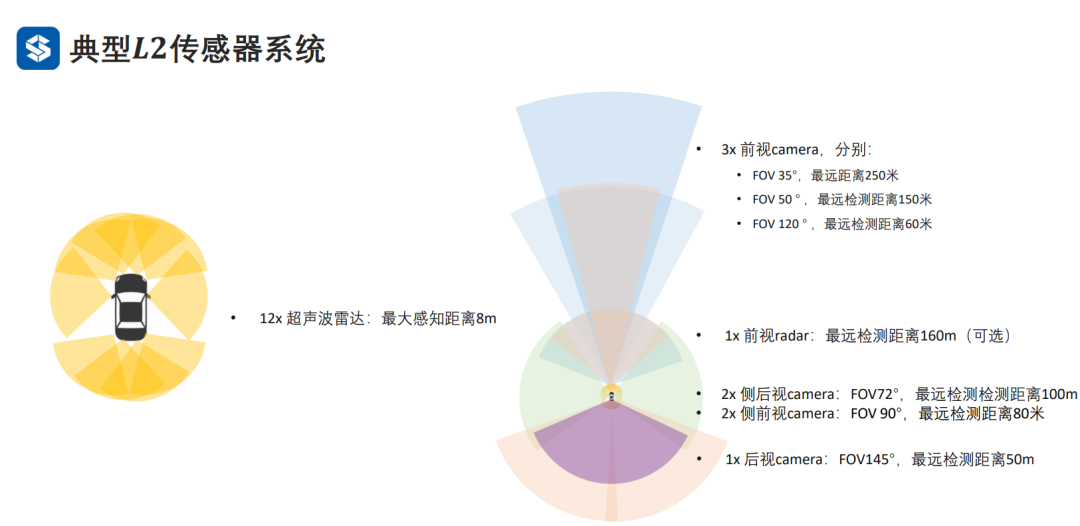

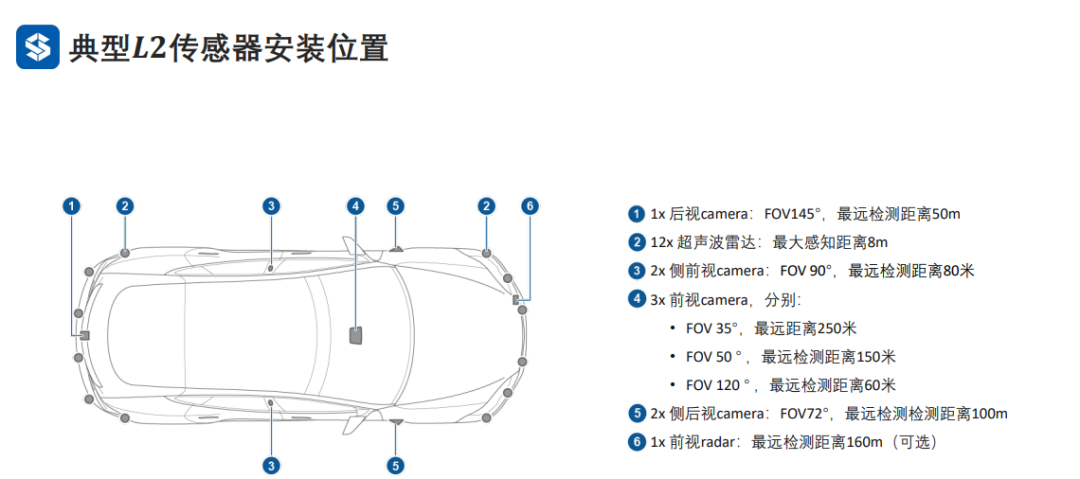

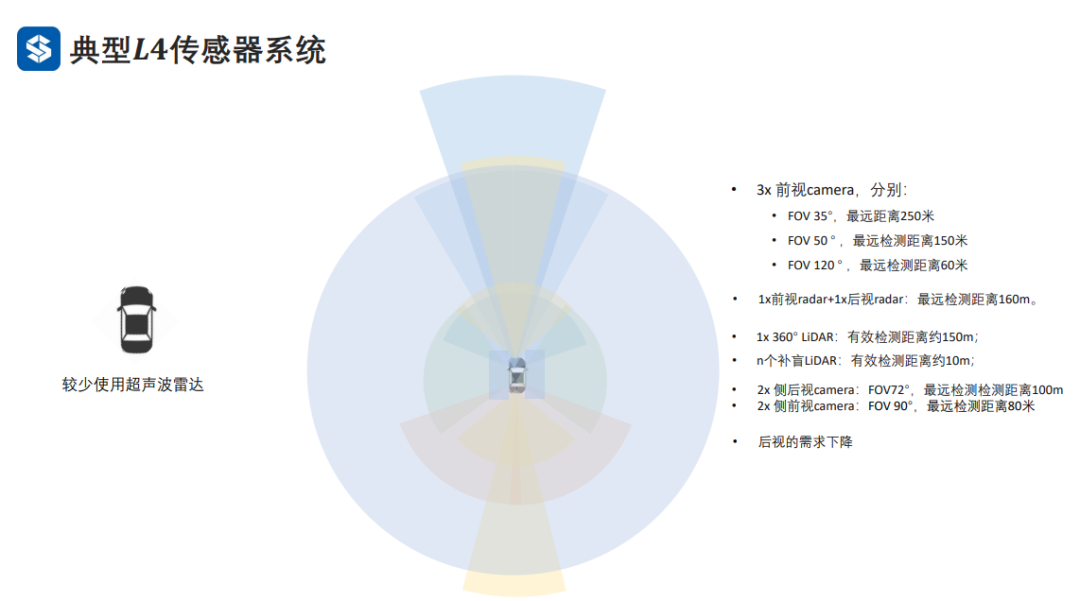

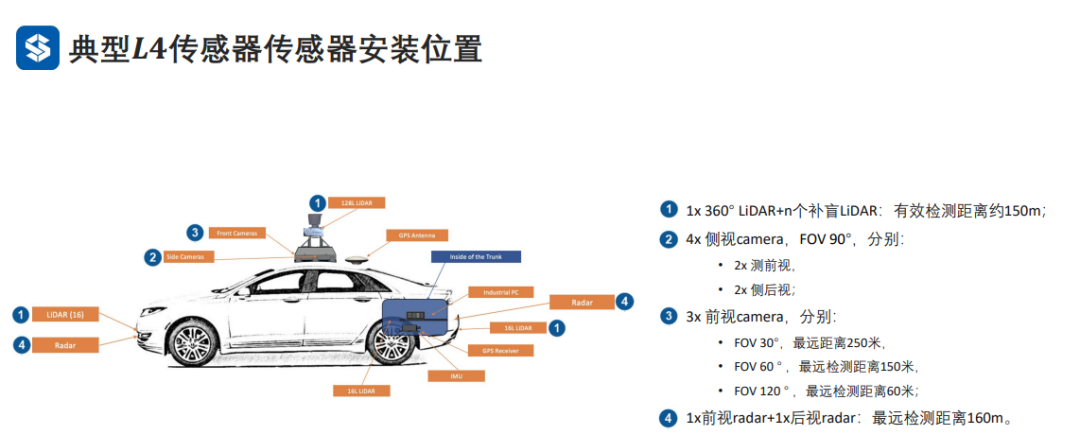

L4级别的自动驾驶相对于L2级别,增加了激光雷达。 3. 多传感器系统的时序闭环 3.1 传感器时钟闭环构建

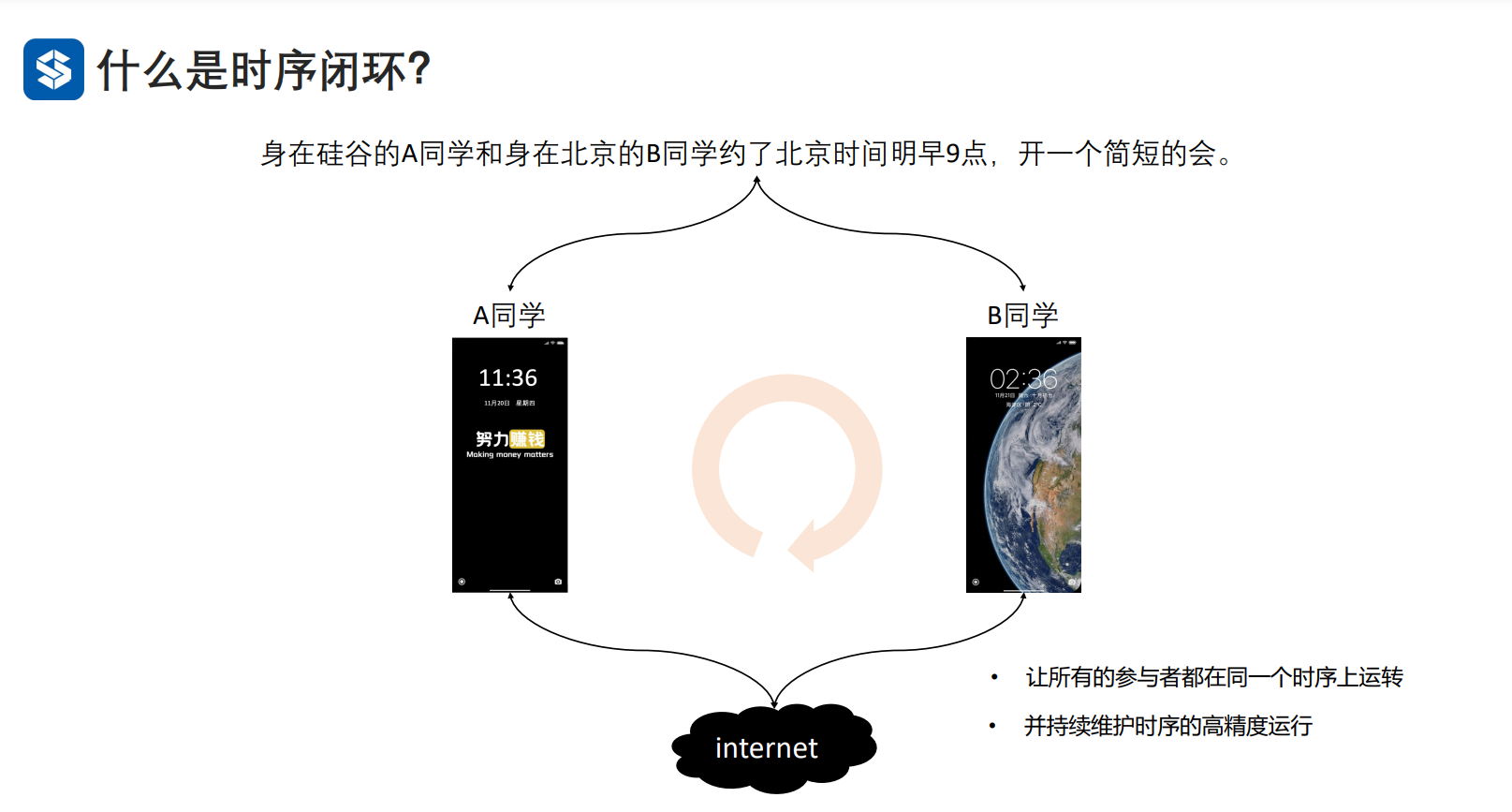

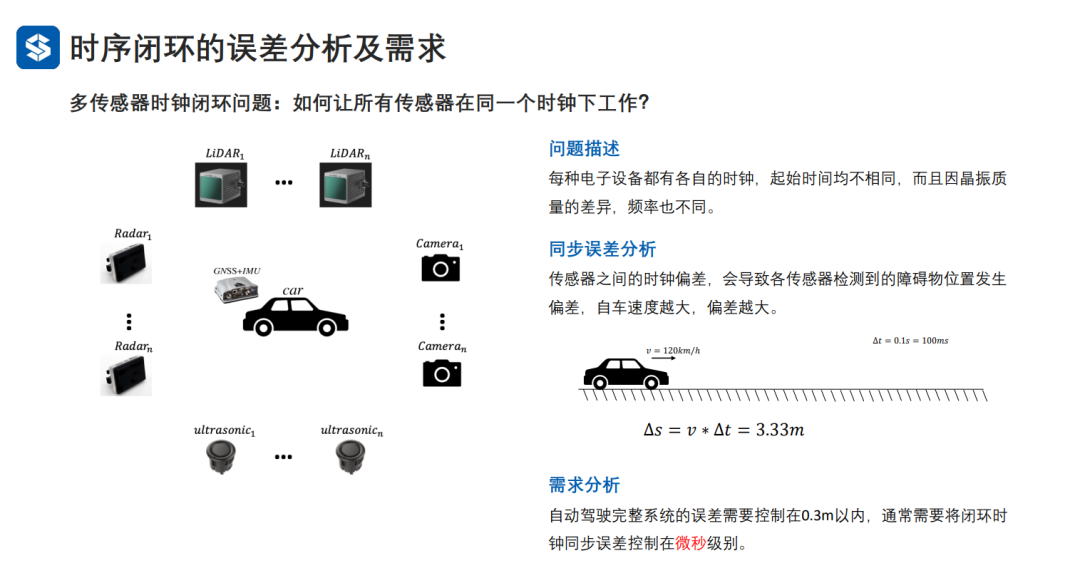

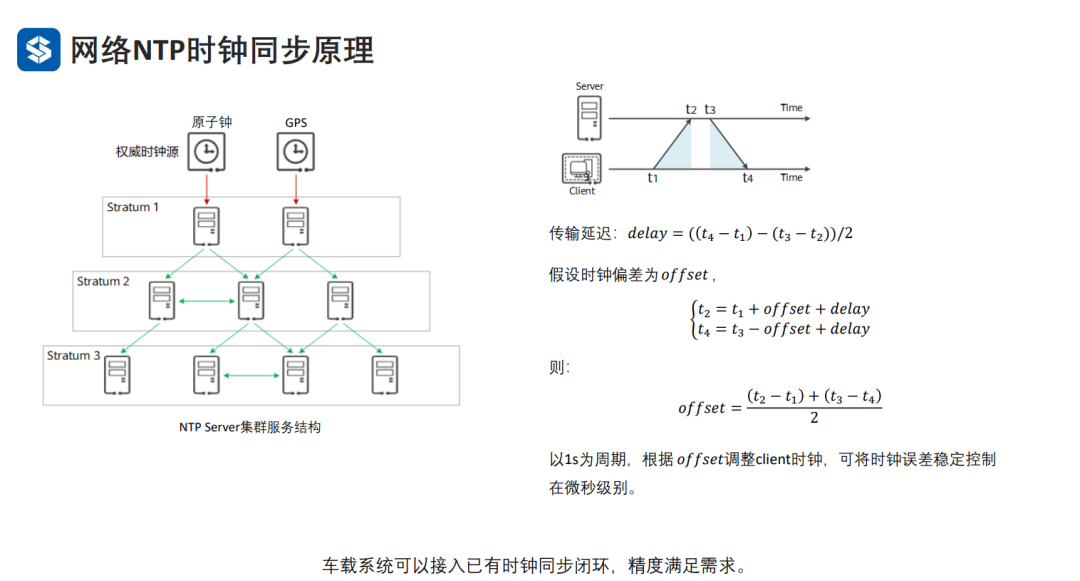

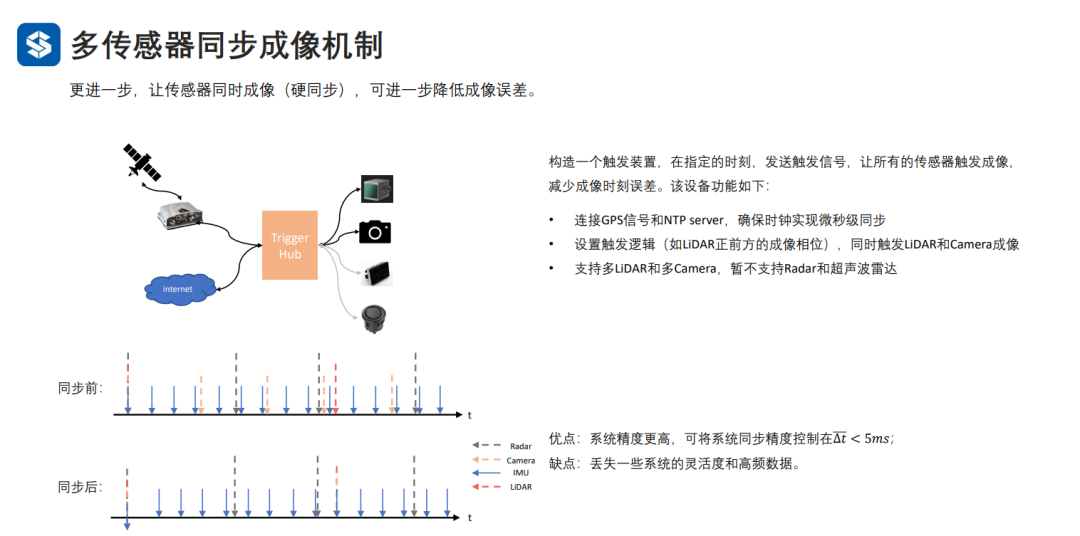

让各种传感器工作在同一时序上运转(每个传感器都可看作一个时区,时区内独自计时,但是要和权威时钟源同步)。

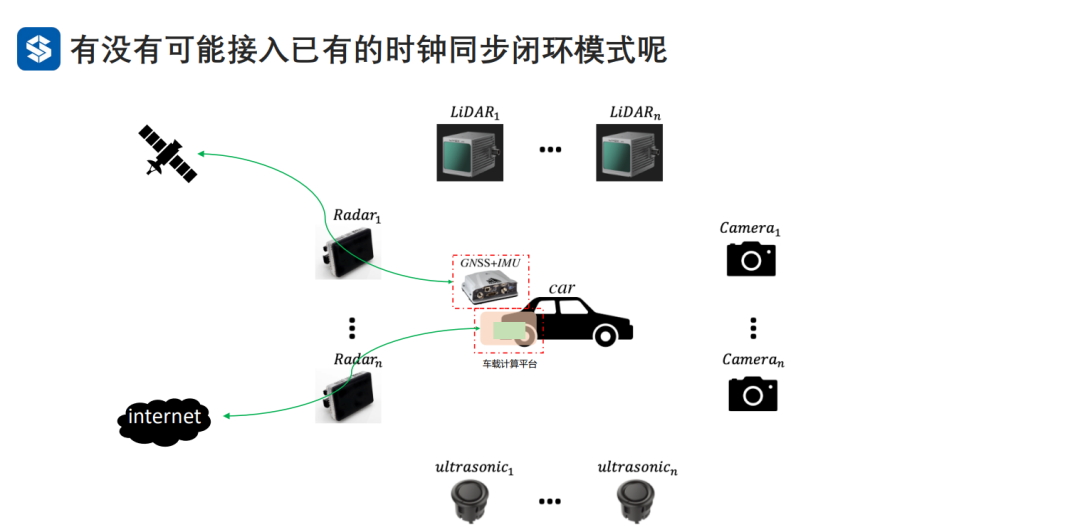

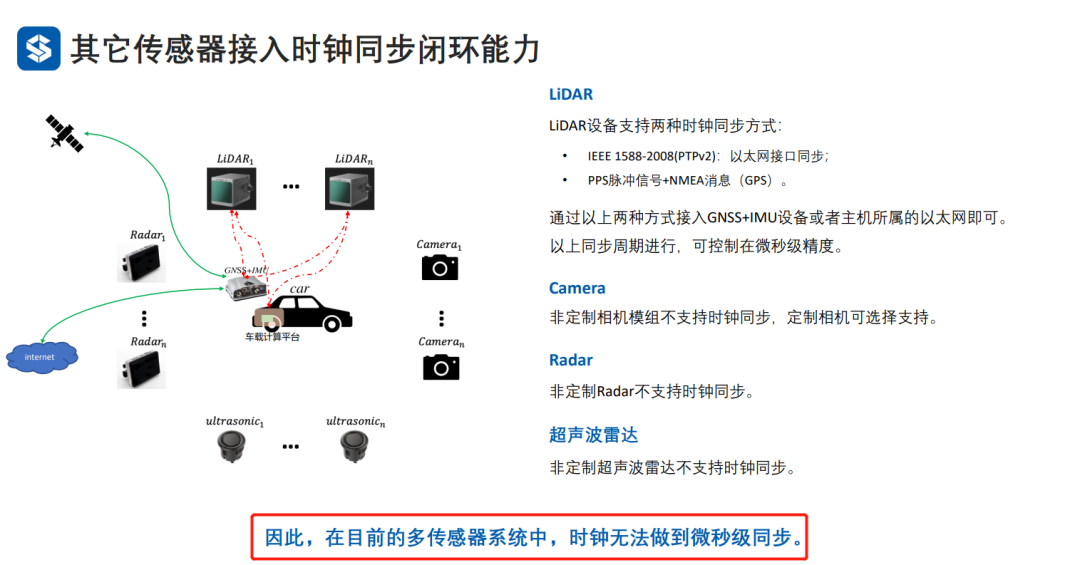

同步误差是相对于权威时钟源而言的,传感器的时钟与权威时钟源存在误差,因此需要周期性地修正传感器的时钟域。权威时钟源有两个,即以太网和GNSS/IMU。

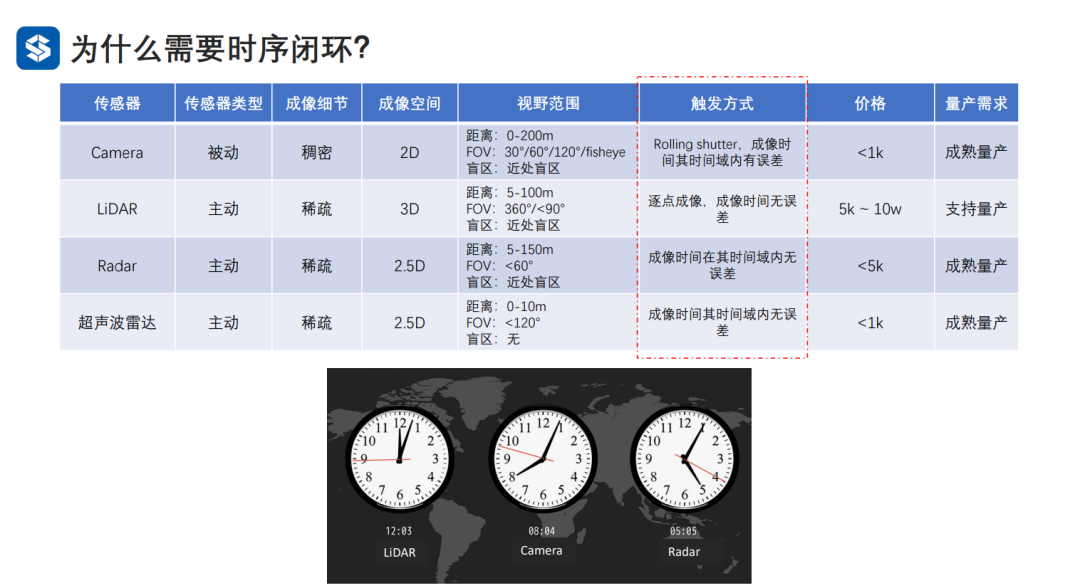

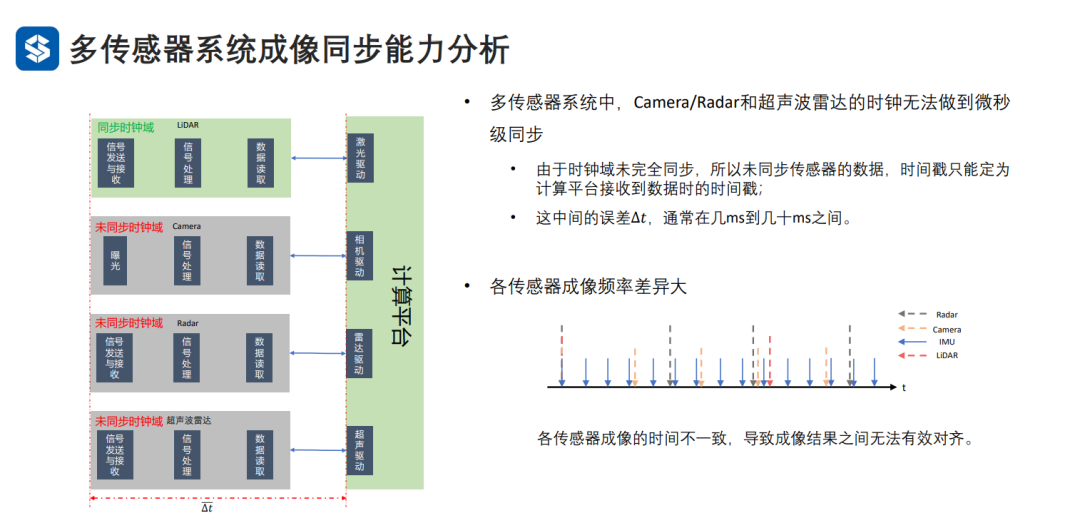

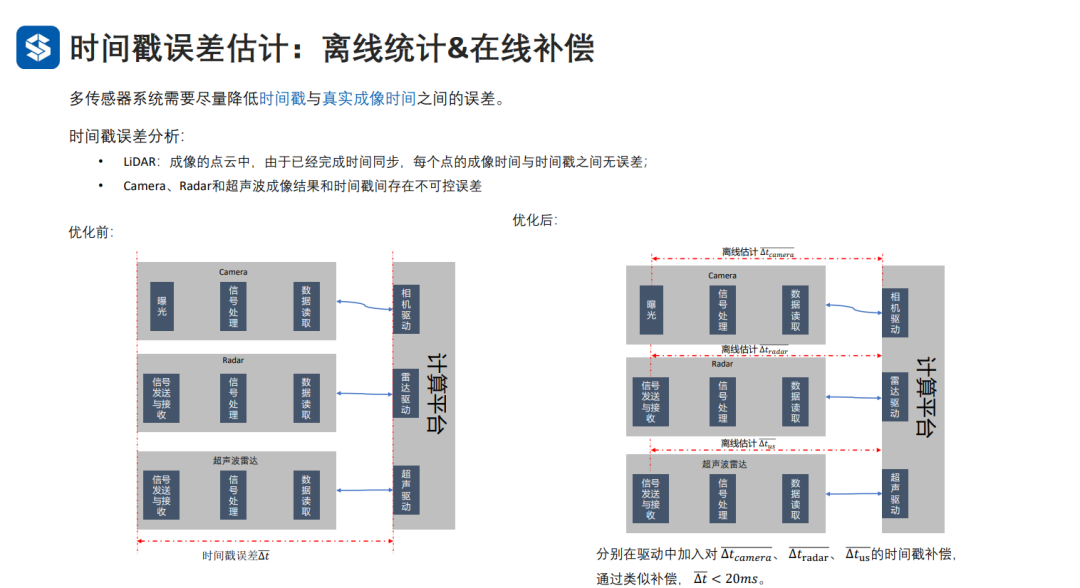

目前,以太网和GNSSIMU是准确的时钟源,且Lidar可以通过以太网和GNSSIMU这两种方式来修正自己的时钟域,而非定制的CameraRadar超声波雷达却无法达到微秒级同步。 3.2 成像同步机制

由于点云的成像时间是准的,一般将点云的成像结果往前退回几帧,并且映射到其它传感器的成像结果上,如果能够匹配上的话,其它传感器的成像时间也就大致确定了。

4. 总结 为了应对全天候、各种光照条件、多种感知距离、多维度和高精度的感知需求,有必要配置多种传感器,并在对齐它们的成像结果后,进行融合。