随着人工智能革命席卷而来,抓住生成式机会的全面出击,为大小挑战者设下新标杆。3月19日,在2024年GTC大会上发布Hopper架构的继任者 —— 全新架构平台,包括AWS、微软和谷歌在内的公司计划将其用于生成人工智能和其他现代计算任务。

本文引用地址:的形态已彻底改变

新架构“”得名于美国数学家David Harold ,与Grace CPU、新一代网络等产品一起,面向生成式共同组成完整解决方案。黄仁勋称Blackwell不只是芯片,而是一个全新的平台。这意味着英伟达从芯片走向平台的转变。

基于该架构的芯片B200采用台积电4NP制造工艺,密度方面应该不会有明显的提升,而之前的H100基本上已经是一个完整的掩模版,芯片尺寸为814mm²,而理论最大值为858mm²。为此B200使用了两个全尺寸掩模版制造的芯片,每个对应四个HBM3E堆栈,每个堆栈的接口容量为24GB、带宽为1TB/s。相比之下,每个H100芯片对应六个HBM3接口,意味着B200每个芯片可以减少内存控制器所需要的芯片面积,从而将更多的晶体管用于计算单元。

B200并不是传统意义上的单一GPU,相反它由两个紧密耦合的芯片组成,通过10TB/s NV-HBI(高带宽接口)进行连接,以确保它们能够作为单个完全一致的芯片正常运行。B200总晶体管数量达到2080亿个、内存带宽达到8TB/s、拥有20 petaflops的性能,英伟达称其可实现在十万亿级参数模型上的AI训练和实时LLM(大语言模型)推理。

GPU的形态已彻底改变。需要更大的GPU,如果不能更大,就把更多GPU组合在一起,变成更大的虚拟GPU。Blackwell新架构硬件产品线都围绕这一句话展开,通过芯片与芯片间的连接技术,一步步构建出大型AI超算集群。

两个B200 GPU与Grace CPU结合就成为GB200超级芯片,通过900GB/s的超低功耗NVLink芯片间互连技术连接在一起,将能够使大模型推理工作负载的性能提升30倍,同时提高效率。相比于H100,它可以将成本和能源消耗降至1/25,而在参数为1750亿的GPT-3 LLM基准测试中,GB200的性能达到了H100的7倍,而训练速度则达到了H100的4倍。GB200将于今年晚些时候在NVIDIA DGX Cloud上以及通过AWS、谷歌云和Oracle云基础设施实例提供。

在多卡互联方面,英伟达的NVLink和NVSwitch技术是其护城河。NVLINK是一种点对点的高速互连技术,可以将多个GPU直接连接起来,第五代NVLink在多达576个GPU之间可提供1.8TB/s的每GPU双向通信吞吐量;同时NVLink引入了统一内存的概念,支持连接的GPU之间的内存池,这对于需要大型数据集的任务来说是一个至关重要的功能。而NVSwitch是一种高速交换机技术,可以将多个GPU和CPU直接连接起来,形成一个高性能计算系统。

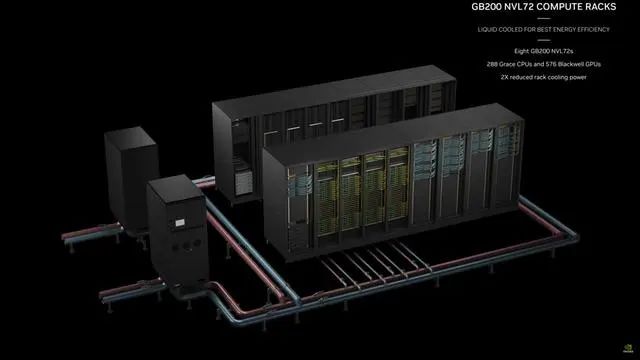

“新一代计算单元”GB200 NVL72由此诞生,GB200 NVL72是一个全机架解决方案,有18个1U服务器,每台服务器里带有两个GB200,合计共有36个Grace CPU和72个B200,并且全部采用液冷MGX封装。黄仁勋在介绍此台机器时说道:“此时此刻,地球上也许只有三台百亿亿次浮点运算(exaflop)机器。而这是一个单一机架中的1个百亿亿次浮点运算AI系统。”

值得注意的是,为了获得最高的AI性能,基于GB200的系统可以与同期发布的Quantum-X800 InfiniBand和Spectrum-X800以太网平台连接,可提供速度高达800Gb/s的高级网络,配合散热系统组成新一代DGX SuperPod集群。DGX GB200 SuperPod采用新型高效液冷机架规模架构,标准配置可在FP4精度下提供11.5 exaflops算力和240TB高速内存,并可通过额外的机架进行扩展。

此外,Blackwell支持的GPU包含RAS专用引擎,实现可靠性、可用性和服务性;还增加了芯片级功能,利用基于AI的预防性维护进行诊断和预测可靠性问题。这可以最大限度地延长系统正常运行时间,并提高大部署规模AI的弹性,使其能连续运行数周甚至数月,并降低运营成本。

“这样我们可以大量地节省能源、网络带宽量和时间。”黄仁勋表示,“未来将是可生成的,这就是为什么这是一个全新的行业。我们的计算方式有本质差异,所以英伟达为生成式AI时代打造了一款全新处理器。”

进军机器人领域

在GTC上,黄仁勋展示了多个由GR00T驱动的人形机器人如何完成各种任务,包括来自Agility Robotics、Apptronik、傅利叶智能(Fourier Intelligence)和宇树科技(Unitree Robotics)的机器人产品。GR00T驱动的机器人将能够理解自然语言,并通过观察人类行为来模仿动作。

英伟达过去针对机器人市场的Isaac机器人平台也得到重大更新,发布了一款基于Thor芯片的新型人形机器人计算机Jetson Thor。据介绍,Jetson Thor是一个全新的计算平台,能够执行复杂的任务并安全、自然地与人和机器交互,具有针对性能、功耗和尺寸优化的模块化架构。

该SoC包括一个带有transformer engine的下一代GPU,其采用英伟达Blackwell架构,可提供每秒800万亿次8位浮点运算AI性能,以运行GR00T等多模态生成式AI模型。凭借集成的功能安全处理器、高性能CPU集群和100GB以太网带宽,大大简化了设计和集成工作。

为了帮助机器人更好地感知所处环境,还发布了Isaac Perceptor软件开发工具包,该工具包具有最先进的多摄像头视觉里程计、3D重建和占用地图,以及深度感知功能;以及为了使机械臂更具适应性,宣布推出Isaac Manipulator,一个先进的机械臂感知、路径规划和运动学控制库。

自动驾驶未来可期

根据Frost&Sullivan统计数据显示,2022年英伟达出货量占到全球高算力自动驾驶芯片市场份额为82.5%。按照黄仁勋的规划,未来汽车业务将与数据中心、游戏并列成为英伟达的三大支柱业务。

最新发布的集中式车载计算平台DRIVE Thor也将搭载全新Blackwell架构。多家头部电动汽车制造商在GTC上展示了其搭载DRIVE Thor的下一代AI车型,既包括比亚迪、广汽埃安、小鹏、理想汽车和极氪等众多中国车企,也包括了文远知行等自动驾驶平台公司。

推理微服务成为AI入口

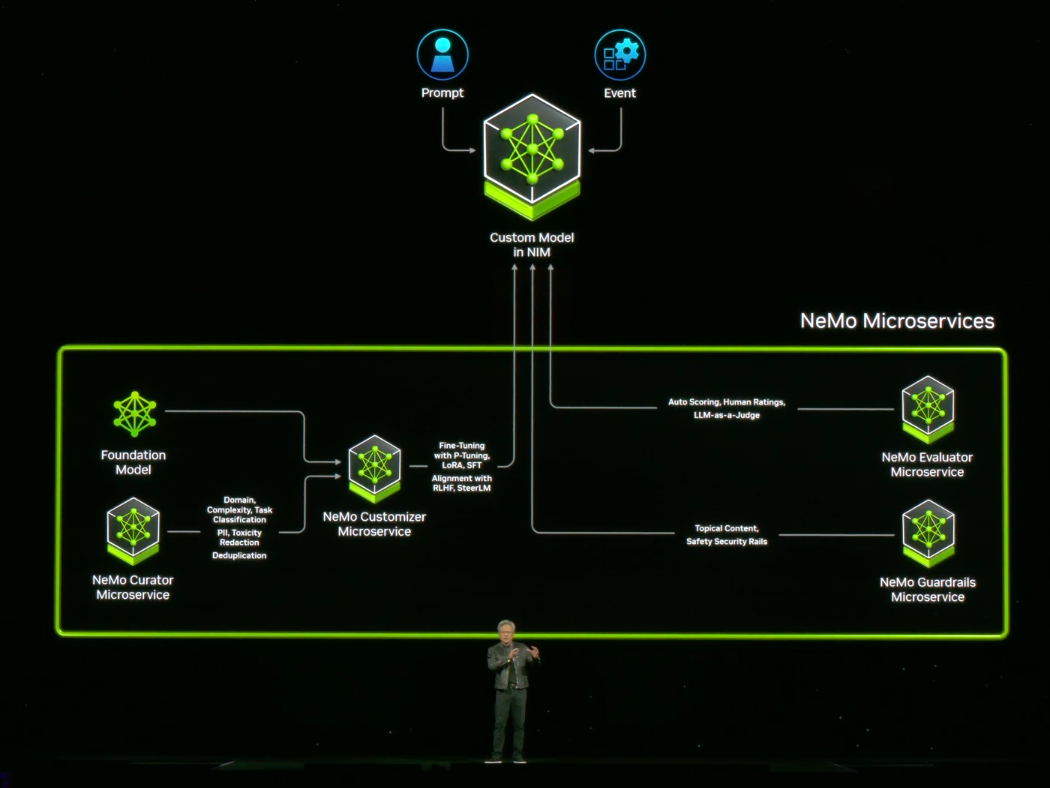

随着人工智能技术加速在各领域的渗透和变革,除了硬件产品,英伟达还与大量与企业合作,推进AI落地。为此,英伟达推出了推理微服务,即NVIDIA NIM,能够将开发者与数亿个GPU连接起来,以部署各种定制AI。这是一种全新的软件打包和交付方式,该服务有望支撑英伟达未来在AI服务上的营收增长。

其具体模式为:英伟达提供预训练好的AI模型并开放API(应用程序接口),再由行业客户开发应用,以简化企业自己开发生成式AI应用的成本。

这些微服务支持行业标准API、易于连接,可在英伟达庞大的CUDA安装基础上工作,针对新GPU进行重新优化,并不断扫描安全漏洞和威胁。黄仁勋也在现场示范了英伟达内部藉NIM所打造的“芯片设计聊天机器人”,经过数据训练和模型微调后,聊天机器人即可给出符合芯片设计领域的答案,甚至能同步生成所需的程序代码。

企业IT行业正坐在一座「金矿」上,拥有多年来创建的所有这些令人惊叹的工具和数据,如果能把它们变成AI助手,就能提供更多可能。

· 在量子计算领域,英伟达宣布推出云量子计算机模拟微服务,帮助研究人员和开发人员在化学、生物学、材料科学等科学领域的量子计算研究,该服务基于开源CUDA-Q量子计算平台,支持用户在云端构建并测试新的量子算法和应用,包括支持量子-经典混合算法编程的模拟器和工具等。与其他云服务不同,英伟达目前还没有量子计算机,但未来它将提供第三方量子计算机的访问。

· 在医药领域,英伟达宣布旗下包括Parabricks、MONAI、NeMo™、Riva、Metropolis,现已通CUDA-X微服务提供访问,以加速药物研发、医学影像、基因组学分析等医疗工作流程。

游戏领域大显身手

游戏起家的英伟达,自然也没有忘记人工智能技术在游戏领域大显身手,这次GTC上重点展示的是它的数字人技术。英伟达数字人平台包括三项主要技术:NVIDIA ACE、NVIDIA NeMo和RTX光线追踪技术,分别通过AI驱动游戏角色语言、语音、动画和图形。

其中,NVIDIA ACE可帮助开发者通过Audio2Face驱动的面部动画以及由Riva自动语音识别(ASR)和文本转语音(TTS)驱动的语音交流,允许模型在云端和PC上运行,以确保用户获得最佳体验。全球游戏发行商正评估NVIDIA ACE如何改善游戏体验。

NVIDIA NeMo则可帮助开发者提供企业级生成式AI模型,包括精确数据管理、模型个性化定制、检索增强生成和加速性能等。最后,包含RTX全局光照(RTXGI)和DLSS 3.5等渲染技术的集合,可在游戏和应用中实现实时光线路径追踪。

总结

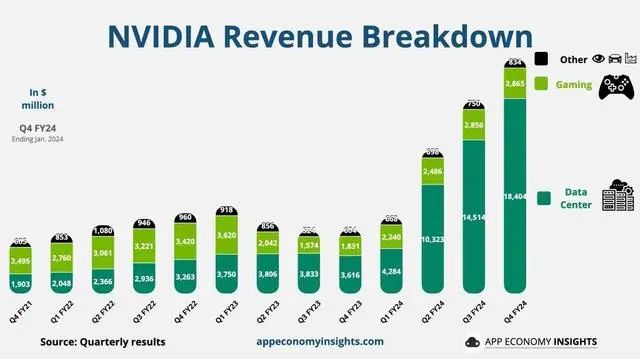

自从2022年底OpenAI宣布AI聊天机器人ChatGPT以来,全球掀起了一轮巨大的AI热潮,推动了GPU芯片大厂英伟达数个财务季度的收入爆发式增长。更加确切地说是,英伟达在最近几个财季的收入暴增,其实主要依赖数据中心业务作为增长引擎。与此同时,英伟达在资本市场上还受到投资者们狂热地追捧,它的股价持续攀升。目前,英伟达已经拥有2.26万亿美元的市值,是全球市值排名第三的上市企业,仅次于微软的3.16万亿美元和苹果的2.76万亿美元。

预计每年全球对数据中心设备投入的费用将共计2500亿美元,英伟达产品在其中占据的份额将超过其他芯片生产商。英伟达正致力提供AI模型和其他软件,然后根据客户的算力和运行的芯片数量向客户收费,软件业务未来有望带来数十亿美元营收,成为高利润率业务。

Blackwell产品线就由Nvidia AI Enterprise支持。英伟达的软件和生态系统有助于加速AI的应用,同时进一步构建“护城河”,构建了难以跨越的竞争壁垒。凭借领先GPU/DPU/CPU、硬件/软件平台和强大的生态系统,英伟达有望继续从人工智能、高性能计算、游戏和自动驾驶汽车的重大长期趋势中受益。

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服