前言:现今已是2023年了,科技在快速发展,特别是数字智能时代的到来,作为核心驱动力量为医疗行业、汽车行业以及等行业带来了巨大转变。

本文引用地址:如在医疗行业,应用认知计算技术能为人们的健康保驾护航,将人工智能应用到医院平台,能从各种渠道分析访问者的健康状况并提供保健相关的洞察力,并与访问者进行双向互动。对于患者而言,AI可以帮助自己预知发病时间,并及时寻求有效的解决方案;

如在汽车行业,可以利用AI技术进行自动驾驶,改变我们的出行方式,创造更安全、更高效的出行方式;

如在AI行业,人工智能可以自主学习大量而深厚的专业知识,开发者能通过人工智能对这些大量非结构化数据进行训练、推理和学习。

……

我们都知道支撑AI应用需要完善的基础架构,但是在AI解决方案部署过程中,从底层算力平台到上层资源管理软件,整个基础架构需要集成CPU、、存储、网络等多种硬件基础设施,其中是部署过程中的关键,因为加速计算是近年来集群建设的主流方案,可以提供卓越的应用程序性能,将应用程序计算密集部分的工作负载转移到GPU,同时仍由CPU运行其余程序代码,可显著提高应用程序的运行速度,建设一个GPU高性能计算集群可以提供一个GPU加速的人工智能实验平台,促进企业人工智能、大数据、深度学习、机器学习等算法方面的研究和应用。

此外,还需要pytorch、Tensorflow等AI框架,AI框架是为了更轻松、高效地研究和应用深度学习,目前主流的深度学习框架都很好的支持GPU加速,框架可专门为深度神经网络(DNN)训练所需的计算提供支持高度优化GPU的代码的框架经过调优和测试,可提供非常出色的GPU性能,借助这些框架,用户可以通过简单的命令行或Python等脚本语言接口访问代码。许多功能强大的DNN都可通过这些框架来训练和部署,而无需编写任何GPU或复杂的编译代码。再通过docker容器技术,调度器等软件进行统一的计算资源与数据库管理和调度,可从GPU加速带来的训练速度提高中受益。

如果将能成功跑起来的AI应用比做一辆车,那么算法就是发动机,大数据是油,提供动力,而GPU计算力就是车轮,只有三者相匹配、融为一体,才能跑得快、跑得远。

工欲善其事必先利其器, 机房建设是部署AI应用的基础,也是整个基础架构中最底层的部分,合理的机房建设可以满足未来计算资源的扩容,可以提高计算资源的利用率,节省空间与能耗,机房基础设施涉及服务器机柜、KVM切换器、UPS不间断电源、精密空调、防静电地板,新风系统、隔音的处理等等,机房基础建设要考虑未来算力资源的扩充,提前根据算力平台的功耗考虑供电系统,根据设备的数量考虑机房空间。

另外机房基础建设分为传统机房和模块化机房,传统机房一般采用工业空调对机房整体空间制冷的方式,或者是采用精密空调架空地板下送风方式制冷方式,模块化机房与传统机房最大的区别在于能够最大限度的利用制冷功率为设备散热。因为其采用封闭冷通道方式,冷气与热气隔离,整体提高制冷效率;空调与IT机柜并排间隔摆放,采用空调水平送风直接对机柜吹冷风,满足其散热需求,为客户节约大量运营成本。其次,模块化机房能够快速部署。因其出厂前完成机柜的预安装,现场只需接通外部电源,固定机柜等简单操作即可使用,包头云计算中心即采用模块化机房,位于包头市稀土高新区,总面积2400平米,地板承重800KG/㎡,抗震烈度等级8级,电力方面稀土变+沼潭变,双市电保障,发电机冗余,满负荷下可运行12小时,并与加油站签署供油合同,UPS采用采用2N冗余UPS供电,满载后备120分钟,空调方面采用N+1列间精密空调,运营安全方面采用双冗余华为6680防火墙,开启IPS/IDS/防病毒功能,采用7x24小时不间断全方位机房监控,采用大数据动态感知系统,实时分析预警。

在解决机房建设这个基础问题后,硬件问题亦是重点。

要知道硬件资源层构成复杂,部署AI应用需要涉及算力、网络、存储等方面,标准的集群构建需要管理节点、计算节点、存储节点和网络节点、我们一般管理节点采用普通2U机架式服务器,顾名思义,它是承担集群中管理的角色,计算节点即我们提供核心算力的部分,通常采用GPU服务器,为首的有 A40 Tensor Core GPU。

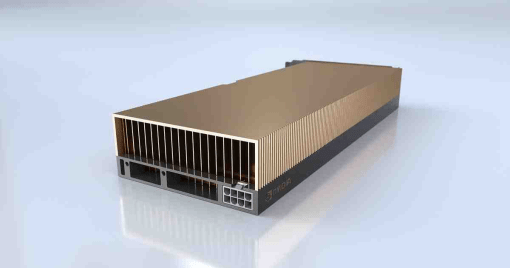

A40是NVIDIA Ampere 架构GPU,速度提升一倍的单精度浮点 (FP32) 运算处理和改善的能效可显著提高图形和模拟工作流程的性能,A40采用第二代 RT Core 的吞吐量是上一代的 2 倍,并能同时运行光线追踪和着色或降噪功能,从而大幅加快工作负载的运行速度,A40采用第三代 Tensor Core新的 Tensor Float 32 (TF32) 精度提供的训练吞吐量达到上一代的 5 倍,而且无需更改代码即可加速 AI 和数据科学模型的训练。从硬件上支持结构稀疏度使推理吞吐量提升一倍;另外,A40具有超高速 GDDR6 显存,单卡48GB,还可通过 NVLink 扩展到高达 96 GB,为数据科学家、工程师和创意专业人士提供所需的大容量显存,让他们能够处理大型数据集以及数据科学和模拟等工作负载,PCI Express 第 4 代将 PCIe 第 3 代的带宽增加了一倍,因而提升了从 CPU 内存传输数据的速度,能更好地支持 AI、数据科学和 3D 设计等数据密集型任务,更快的 PCIe 性能还能加速 GPU 直接显存访问 (DMA) 传输,A40 向后兼容 PCI Express 第 3 代,这也提供了部署灵活性。

(图 NVIDIA A40)

*与 NVIDIA 产品相关的图片或视频(完整或部分)的版权均归 NVIDIA Corporation 所有

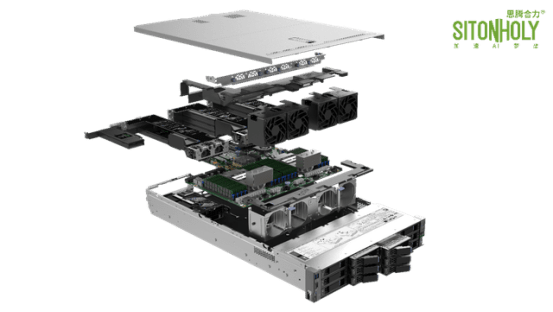

GPU服务器从2U2卡,2U4卡到4U4卡,4U8卡,4U10卡均有覆盖,像IW4222-8GR这块8卡GPU服务器,就是我们构建集群经常用到的一款服务器,它支持2颗第三代Intel® Xeon® Icelake系列可扩展处理器,TDP 270W,提供强大的X86处理平台针对推理及训练应用,带宽翻倍的PCIe Gen4平台上可支持8块双宽GPU卡,专为高密度GPU计算提供多方位的性能支持,支持高速网络,存储和其他IO扩展,8个U.2硬盘。为高端计算平台提供高速传输和数据存储能力。同时进一步优化运维效率,拥有专业管理平台能够实现对市面主流的各类GPU实现识别,监控,风扇调速支持,故障报警等功能;存储节点即AI应用中存放数据的地方,AI应用对于数据量的需求非常庞大,而且对于读写性能、带宽都要求很高,所以对存储的容量、性能及安全性都有要求,存储可以采用分布式存储系统,即数据分布到各个存储节点上,并行读写,提供存储性能,同时可以采用不同的冗余方式,比如双副本、多副本、纠删码冗余技术等等,保证数据安全性,这块我司具备4U24盘位、4U36盘位存储服务器,也有自己的分布式存储管理软件,可提供集性能、容量、安全性与一体的分布式存储系统;网络节点有3套:管理网络、计算网络和IPMI网络,这里管理网络一般采用千兆以太网,计算网络一般采用万兆光纤网络或者IB网络,IPMI网络做远程管理使用。

(图 IW4222-8GR )

*与 NVIDIA 产品相关的图片或视频(完整或部分)的版权均归 NVIDIA Corporation 所有

NVIDIA A40 GPU 可使数据中心的性能和多工作负载能力获得进化式飞跃。它集优秀的专业图形性能与强大的计算和 AI 加速能力于一体,可应对当今的设计、创意和科学挑战。NVIDIA A40 能驱动新一代虚拟工作站和基于服务器的工作负载,并随时随地为专业人士提供光线追踪渲染、模拟、虚拟制作等领域的先进功能。NVIDIA A40 对最新 vGPU 软件的支持使复杂的图形工作负载可以在虚拟环境中运行,且性能可与裸机媲美。

Citrix 产品管理副总裁 Calvin Hsu 表示:“Citrix Hypervisor8.2 和 Citrix Virtual Desktops 支持 NVIDIA 最新的 vGPU 软件和 NVIDIA A40 ,尽管客户需要处理的数据和工作负载不断增加,我们依然可以继续为其提供运行图形密集型可视化应用程序的所需性能。 Citrix 和 NVIDIA 虚拟化技术的结合使用户无论身在何处,都能够访问这些应用程序,并获得与物理工作站相媲美的优质体验。”

红帽产品管理总监 Steve Gordon 表示:“NVIDIA 最新一代 A40 GPU 和 NVIDIA vGPU 软件的结合,以及红帽企业 Linux 和红帽虚拟化的支持,能够为用户提供一个强大的平台。无论在石油天然气还是媒体娱乐行业,都能满足从 AI/ML 到可视化领域最严苛的工作负载。随着组织转型并越来越多地使用 Kubernetes 进行容器设计并作为其应用程序的关键构建模块,我们认为红帽可能是容器化和虚拟化工作负载的终点。”

上面介绍了很多关于硬件资源层的知识,笔者再分享下构建好集群硬件后,关于平台软件的部署的问题

我们在开篇讲到部署AI应用需要pytorch、Tensorflow等AI框架,如果没有平台软件统一管理,就需要使用者自己安装应用环境,包括CUDA、AI框架、docker等,再进行环境的调试,在AI部署中,软件环境调试非常耗费时间,并且不是所有使用者都熟悉各种软件环境,此外,没有软件平台做统一管理,会造成资源分配不均,容易产生计算资源的浪费,比如大多数高校发现GPU 计算资源被初学者占用,往往导致真正科研计算任务匮乏计算资源,基于 Docker 环境的计算管理环境常常发生计算资源抢占现象,让管理者应接不暇各种投诉,这里有自主开发的SCM人工智能云平台软件,集成了主流的AI框架,可实现计算资源池化,按需分配给一个或多个用户使用。SCM云平台可对 GPU 高性能计算资源进行统一的管理和调度,有效满足用户在深度学习等科研及教学方面的需求,用户可以快速的在平台上进行数据处理、算法设计、模型训练、模型验证、模型部署等工作,而不用关心底层复杂的集群构建与调度机制以及深度学习框架的安装部署、性能调优等问题,在充分简化深度学习训练方面工作的同时有效提高资源利用率。

其实分享到这里,我们的AI应用的全套装备差不多就齐全了,下面以实际案例,让我们在看看一个AI应用究竟是如何落地的。

案例1:国内某知名智能汽车设计及制造商AI驾驶基础架构建设,定位于深圳,成立于2014年,是一家专注未来出行的科技公司。他们一直坚持饱和式研发投入,构建全栈自研的核心能力,如今已经成为中国领先的智能电动汽车公司之一。

背景:在研发的过程中,尤其是深度神经网络建模及训练,需要大量计算力,因为汽车自动驾驶是需要很多大量数据进行训练,让这个汽车能够去进行图象图形的识别,然后应用在汽车当中,让我们的汽车能够智能化的去自动驾驶。

需求痛点:

1 模型和算法出现算力瓶颈,训练出成熟的模型周期太长;

2 难分配:存在的所有资源都是以物理形式存在,没有办法很好的进行合理资源分配,导致算法研究存在一定问题。低效率:正在运行中的项目作业只能靠人为干预检查是否正常运行,费时费力。不灵活:大量的算力资源无法通过软件进行灵活调配,无法支撑算力需求极高的任务;

3 难定位:在多个线程的项目同时运行时,一旦有其中之一出错,难以精准定位报错任务。

解决方案:从底层硬件算力平台和上层软件管理平台的统一部署,使用6节点思腾合力IW4213-4G,加速计算卡为NVIDIA A40,配合NVIDIA 深度学习SDK与NVIDIA DRIVE® 软件堆栈进行问题的解决。

部署效果:

GPU作为底层平台,很好的起到了加速应用的作用,帮助深度学习的研发人员更快的训练出成熟的模型,其次,用户可以根据需求选择不同的平台,深度学习研发人员需要在算法、统计方面精益求精,都需要一个生态环境的支持,GPU已经构建了CUDA、cuDNN及DIGITS等工具,支持硬件兼容,GPU高性能解决方案让研发人员能够排除意外干扰,专注于深度学习的研究项目中。

案例2:国内某知名医院AI医疗算力平台建设,医院位于北京市昌平区,由高校与北京市共建共管的大型综合性公立医院,建设和运营过程中得到了台塑企业的无私捐助和援建。

背景:基于现代先进的医疗科研发展趋势,医院作为新型医院,对于病例、病因的数据处理需求很大。患者的医疗影像数据十分庞大,原有设备已无法满足大量的数据推理,模型训练,新型医院需要对患者肺部的切片医疗影像进行病理匹配、判断,减少医疗事故的发生。

需求痛点:

1 对于病例、病因的数据处理需求很大,很多数据没有及时的建立相应的数据库进行存放。

2 设备数量不足,无法满足庞大的医疗影像数据进行数据训练、数据推理与模型训练等。

3 无法对未知的病部切片进行推理分析,无法在影像中看到医生肉眼看不到的疾病发展征象。

解决方案:从底层硬件算力平台和上层软件管理平台的统一部署,1节点IW2200-2G计算服务器,1节点IW4200-8G计算服务器,1节点IR2200推理服务器,1节点管理服务器,1节点存储服务器,加速计算卡为NVIDIA A40,计算网络采用万兆光纤组网,软件管理平台使用思腾合力SCM人工智能云平台软件。

部署效果:

AI与医疗的融合可以有效的解决资源不均衡的痛点,AI的强大在于可以通过大量的数据深度学习之后,能够预测和看到人类肉眼看不到的东西,比如通过影像切片预测病变的发生。通过AI经过上千病例的训练,能在影像中看到医生肉眼看不到的疾病发展征象,从而给出医生更精准的判断提示,算力平台的建设可加快AI模型的训练与推理。

案例3:北京某知名AI科技公司智能视觉处理平台建设,公司位于北京市海淀区,是一家以图像处理与智能视觉为核心的AI技术服务提供商。

背景:公司是以图像处理与智能视觉为核心的AI技术服务提供商,聚焦活体采集、人脸识别、人形检索等应用,以高性能图像处理和视频结构化技术为基础,整合人、物识别与追迹以及场景感知,需要GPU集群加速数据处理过程。

需求痛点:

1.人脸识别、人脸比对云服务的算法训练周期太长,影响客户体验的同时,丢失了部分商业市场。

2人形检索与人物追迹、车牌识别等算法精确度不足,时长出现识别错误的信息。

3高性能图像处理和视频结构化技术在实际的应用场景中,对项目落地的要求太高,端到端的AI算法训练难以开展。

解决方案:从底层硬件算力平台和上层软件管理平台的统一部署,1节点思腾合力IR2200管理服务器,2节点思腾合力IW4200-8G计算服务器,1节点思腾合力IS4200-24存储服务器,加速计算卡为NVIDIA A40,计算网络采用56G Mellanox IB组网与千兆以太网管理,软件管理平台使用思腾合力SCM人工智能云平台软件。

部署效果:

通过思腾合力搭建的GPU集群环境,配套云平台软件,可实现端到端的AI算法训练,加速了人脸识别、人脸比对云服务、人形检索与人物追迹、车牌识别等算法的落地。

NVIDIA GPU应用在实际的项目中需要多重因素协调配合,对于一些非计算机专业人员,基础设施的开发、搭建、调试往往要耗费数月时间,期间透明性低,测试频繁,效率低下,严重限制人工智能技术在行业中的应用,比如Tensorflow、Caffe 等众多的计算框架以及 CNN、RNN 等复杂的网络模型,即便是资深工程师也需要花费大量的时间成本学习和应用,主流计算框架采用 CPU+GPU 的异构计算平台,其管理和调度融合了高性能计算、大数据和云计算等多领域技术,实现难度较大,诸如思腾合力这类解决方案提供者,可以帮助大家完成从基础设施到云管理平台的构建,通过其研发的SCM人工智能云平台软件,面向大规模异构计算基础设施管理,解决上述问题。

这篇文章就暂时先到这里,希望各位开发者、技术负责人、业务管理者们能够找到适合自身的解决方案,在AI企业,医疗、金融、教育、汽车等行业中更好的使用NVIDIA GPU的应用,充分提升GPU资源利用效率,降低部署AI应用的总体拥有成本,提升AI研发创新效率!

相关文章

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服