AI行业火热,作为基础设施巨头的英特尔也在不断加大布局,先是在去年提出AI PC的概念,今年也在不断加大AI投入。

日前,英特尔中国区领导齐聚一堂,共同探讨一个话题——AI。

企业AI:开放、易部署、可扩展、可靠

前两年,大家“卷”的是大模型,即互相比拼模型参数,也从而催生了诸如1000亿参数,甚至是万亿参数的模型。

然而,在大模型及生成式AI智力涌现的背后,如何在行业中成功落地至关重要,而技术落地的关键在于:开放、经济、可扩展和可靠。

为此,英特尔推出企业AI。英特尔公司市场营销集团副总裁、中国区数据中心销售总经理、中国区运营商销售总经理庄秉翰解释,与AI算力集中在公共场合的通用模型不同,企业AI能够通过开放的生态,更有规模地、更可靠地帮助企业释放AI潜力,这也是英特尔企业AI最基本的核心。

英特尔公司市场营销集团副总裁、中国区云与行业解决方案部总经理梁雅莉强调,英特尔在中国始终秉承着“水利万物而不争”的理念,其中,“利”和“不争”均有其深刻的含义。

她表示,当一个新的技术潮流来临、新一代技术的应用扩展之时,开放、可靠和易部署的策略对终端用户来说极为关键,这也是英特尔在以往每一次技术迭代过程中,与OEM、ODM、ISV、SI等在内整个生态系统合作的基础。

根据梁雅莉的介绍,小米SU7背后由金山云云基础平台所支持,英特尔与金山云合作,在其第七代性能保障型云服务器 X7 中引入了第四代至强可扩展处理器进行了针对性优化;基于第五代至强可扩展处理器的京东云新一代云服务器整体性能提高了23%;TCL华星借助英特尔提供的硬件产品和“云边端”架构,降低了人力和设备配置成本,使产品良率得到迅速提升;医药领域,英矽智能基于英特尔酷睿Ultra 7 的本地部署,基于第五代英特尔至强可扩展处理器的SaaS服务,PandaOmics平台帮助研发人员进行先期药物的发现和探索。

在工业方面,根据英特尔公司市场营销集团副总裁、英特尔中国网络与边缘及渠道数据中心事业部总经理郭威的介绍,生成式AI让机器设备、机器人具有了自我学习、自我生成的能力。根据客户最后的需求,可以自动生成PLC逻辑控制器代码,并且把这个代码用在机器人的运动控制上,这样可以极大地让终端客户降低使用这个设备的成本,而不需要自己专门维护一个很大的编程团队做这个事情。

至强6:AI性能直线飙升

去年,英特尔将其产品推出至第五代至强,该产品便拥有不俗的AI推理表现。现在,英特尔将其更新到至强6,与以往每一代至强不同,全新的至强6品牌是一个产品组合,通过至强6的产品组合,我们可以解决数据中心在性能、功耗,以及多元工作负载等方面的各种不同问题。

至强6拥有两个不同的微架构,有点类似我们之前常常说起的大小核,即一个更强调性能的性能核(P-core),和一个更强调功耗比的能效核(E-Core)。

配备能效核(E-Core)的至强6,性能取得了质的飞跃,与第二代英特尔至强处理器相比,每瓦性能提高2.4倍,机架密度提高2.7倍。要知道,这种核心更强调的是功耗,这意味着我们可以用更少的核心,完成过去同等的工作,从而节能减排。

配备性能核(P-core)的至强6(代号为Sierra Forest)将于今年第二季度率先发布,它不仅能够支持MXFP4数据格式,在传统的FP16有性能提升,也可以运行700亿参数的Llama2。日前,英特尔称Granite Rapids在运行80亿参数的Llama 3模型推理时,延迟比第四代英特尔至强处理器表现出两倍的提升,并且能够以低于100毫秒的token延迟运行700亿参数的Llama 3模型推理。简单来说,就是随随便便跑大模型。

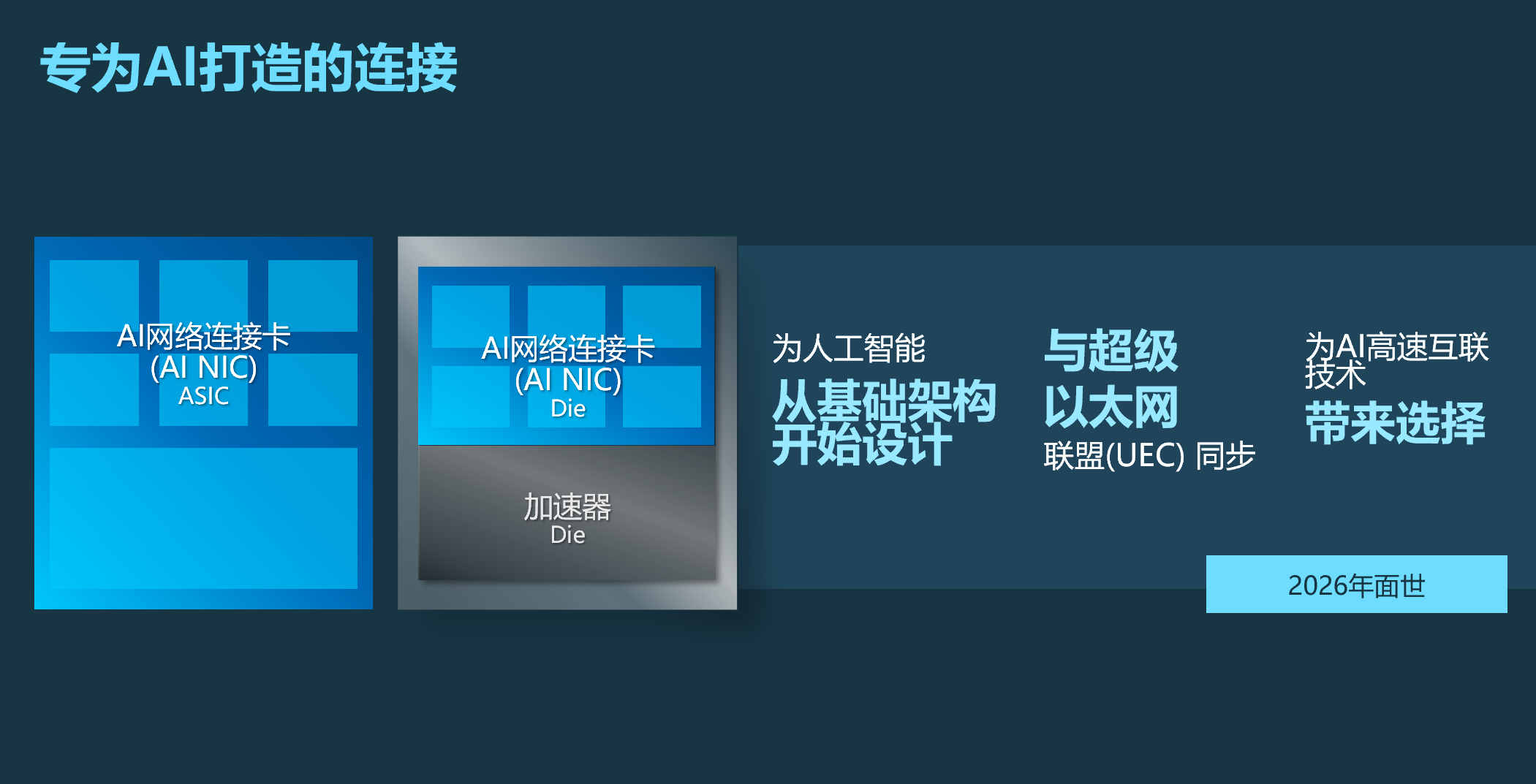

AI NIC:专为AI打造的连接

现在的AI系统本质上还是采取的冯诺依曼的架构,也就是说,我们不仅要看系统不的算能,还要看数据传输的能力。

当下,着大模型不断发展,模型规模已经超过了万亿,无论推理还是训练,很多实践场景往往需要分布式的并行系统,来满足模型处理所需要的要求。在并行处理过程中,会涉及到大量的数据应用。

以训练为例,训练过程中会产生大量中间结果,这些中间结果需要在不同加速卡中间进行分享。而在大模型整个网络中,可以看到网络流量体现出瞬时并发的特征,在整个模型处理过程中,会频繁出现多张加速卡向一张加速卡发送数据的情况,这样会造成网络拥塞。所以如何更好解决网络拥塞的问题,是我今后制约大模型性能提升以及规模扩张的核心要素。

英特尔中国网络与边缘事业部首席技术官、英特尔高级首席AI工程师张宇表示,解决上述问题时,英特尔有相应的技术和产品,同时英特尔和合作伙伴倡导成立了新的超级以太网联盟(UEC),宗旨就是要定义新一代增强的以太网技术,以一种开放的方式来面对新时代大模型对整个网络的要求。

不止如此,英特尔在下半年,会推出第一代基于ASIC IPU的产品,也就是基础架构处理器产品。这款产品首先能够提供高达200GB/s的速度,同时能够提供非常灵活的包的处理能力,非常能够满足现在大模型的时代对网络的要求。

在今年下半年计划推出IPU产品的基础上,英特尔会不断持续做网络创新工作,我们会在IPU上进行进一步优化,开发下一代专门面对AI网络优化的产品,英特尔把这一类产品叫做AI NIC。

AI NIC在后面会有两种形态,一种形态是它会以独立网卡的形态存在,跟不同的加速器之间进行对接。另外还有一种形态是芯粒的形态,不同的AI加速器甚至可以把AI NIC集成到整个AI加速器的芯片里面去,做成一个完整的SoC,包括英特尔自己的AI加速器。

张宇表示,在2026年我们推出的加速的产品中,也会继续把AI NIC集成进去,这样可以更好的满足AI大模型网络对网络传输、数据传输的可靠性、稳定性等方面的要求。

软件:开放软件生态激发AI创新

软件也是英特尔AI战略中重要的一环。英特尔公司副总裁、英特尔中国软件和先进技术事业部总经理李映分享了三点。

第一,未来软件非常重要的点是如何通过软件加速企业AI的发展。在底层,英特尔软件能够保证硬件性能充分释放。从整个软件堆栈来讲,英特尔是少数几家企业能够真正可以在各个层面上通过软件提供优化、提供技术,帮助客户一起实现传统的、云架构的企业IT架构,和未来AI企业IT架构的融合。

第二,英特尔极力推动基于AI的软件创新。比如,英特尔一直是PyTorch前几名的贡献者,这种贡献不仅是对PyTorch平台本身进行优化,也是基于英特尔技术或者是把我们最新的一些创新投入到整个PyTorch开源框架之中,让业内更多企业,更多的开发者得到共享。在整个的框架之上,英特尔通过一系列的贡献,可以让整个AI软件框架变得更加开源、开放。oneAPI就是很典型的例子,根据最新数据,oneAPI已经超过100万次的下载量。

第三,英特尔开发者云平台不仅能帮助开发者更早熟悉和使用至强在内的硬件,更重要的是能够保证各种开源框架、组件在一个环境中,能够保证这种框架之间的兼容性,让开发者能够有更好的用户体验,实现整个开发效率的提升。

当用户拥有开放的生态系统之后,会有什么好处?英特尔院士、大数据技术全球首席技术官、大数据分析和人工智能创新院院长戴金权表示,很多开源大模型训练的方法、数据、算法,因为在同一个开源生态系统上,是可以相互促进的,同时上面新的应用场景也可以互通。

总结

从英特尔的布局不难看出,英特尔未来对于AI生态的建设,不局限于硬件方面,也会包括基础设施、软件生态和应用生态。此外,英特尔能够满足不同层级的不同需求,拥有非常全面的技术储备,让千行百业轻松拥抱AI。

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服