距离ChatGPT发布,已经过去一年零一周。伴随着ChatGPT的发布,成为了人工智能领域最耀眼的公司,尤其是在领域,它也是其他所有科技公司的追赶目标,当然也包括。

本文引用地址:一直把「AI-first」作为公司战略,2016年吸引了全球目光的AlphaGo便是最好的证明。事实上,才是在2017年提出Transformer模型、为今天这场游戏制定规则的先行者。毫不夸张地说,是谷歌掀起的第一波AI浪潮,改变了整个AI行业的发展。但现在,它亟需在领域证明自己。

Gemini:谷歌重新证明自己

12月6日,谷歌正式发布了Gemini。谷歌CEO桑达尔·皮查伊 (Sundar Pichai) 称,这是谷歌迄今为止功能最强大、最通用的模型,也是谷歌新时代的开始。

Gemini是Google Brain和DeepMind合并组建Google DeepMind之后的首个重要产品。而在Gemini发布之前,谷歌在生成式AI和LLM方面主推的两款模型PaLM 2和LaMDA,在用户当中收获的评价一直不高,相对于业界领军的差距很大。

目前,谷歌计划通过谷歌云将Gemini授权给客户,供他们在自己的应用程序中使用。据悉,在Gemini 1.0版本中包含三个不同尺寸,分别是Nano、Pro、Ultra。

· Gemini Nano:有1.8B和3.25B两个版本,分别针对低内存和高内存设备,用于特定任务和移动设备,支持在本地部署;目标是创建一个尽可能强大的Gemini版本,但同时不会占用手机的存储空间或使处理器过热。

· Gemini Pro:是性价比优化的版本,具有良好延展性,在推理、多模态等方面也有较强能力,可以在几周内完成预训练,在多项测试中仅次于V,强于PaLM2、Claude2、LLaMA2、GPT3.5等主流大模型;从发布会当天开始,谷歌聊天机器人Bard将使用Pro来实现高级推理、规划、理解和其他功能。

· Gemini Ultra:是最大、功能最强大的类别,在对应的TPU基础设施中能够展现出最高效率,在多项测试中Ultra版本性能超过V,被定位为GPT-4的竞争对手;谷歌称目前正在进行信任和安全检查,以及通过微调和基于人类反馈的强化学习(RLHF)进一步完善模型,预计明年初,谷歌将推出使用Gemini Ultra的Bard Advanced,会是Bard发布以来的最大更新。

在性能测试上,Gemini Ultra在32个大语言模型基准测试中的30个中超过了当前最优成绩,另外在MMLU(大规模多任务语言理解)中,Gemini Ultra的得分为90%,成为首个超越人类专家的大模型。

MMLU通过结合数学、物理、历史、法律、医学和伦理学等57个科目,来测试大模型对世界知识和解决问题的能力。此前,GPT-4在该测试中的成绩为86.4%,而人类专家的成绩为89.8%。

从自然图像、音频和视频理解到数学推理,在被大型语言模型研究和开发中广泛使用的32项学术基准中,Gemini Ultra的性能有30项都超过了目前最先进的水平;图像理解方面,在新的MMMU(专家AGI的大规模多学科多模式理解和推理)基准测试中,Gemini Ultra的表现也更优,其得分率达59.4%,GPT-4V的得分率为56.8%。

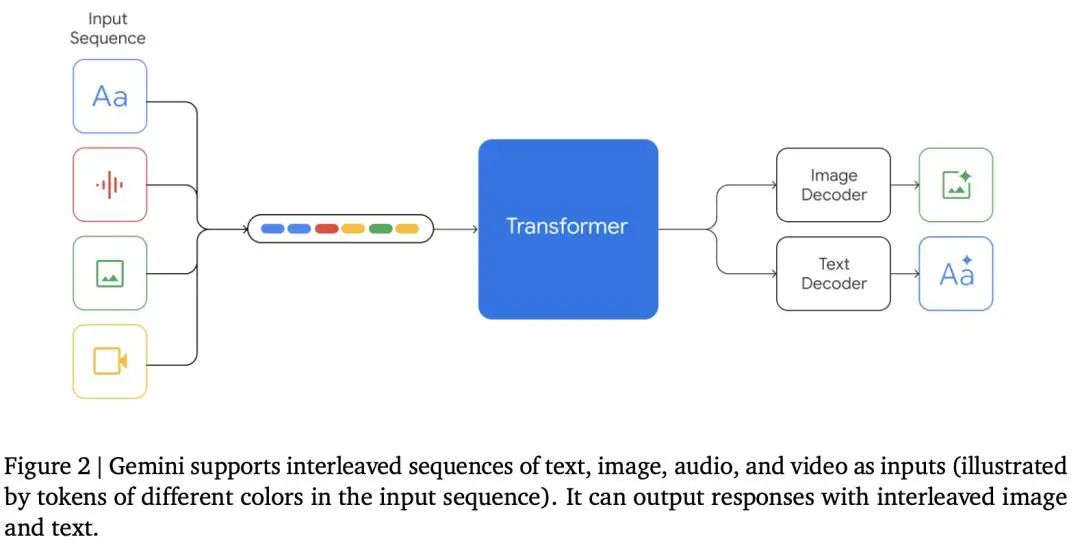

在对比Gemini和GPT-4的基准测试中,Gemini最明显的优势来自于它理解视频和音频并与之交互的能力,这很大程度上是设计使然:多模态在最开始就是Gemini计划的一部分。谷歌没有像构建DALL·E(文生图模型)和Whisper(语音识别模型)那样单独训练图像和语音模型,而是从一开始就建立为一个多感官模型。

最大亮点:原生多模态模型

目前,创建多模态模型的标准方法主要是通过分别针对不同模态训练单独的组件,再将这些组件组合起来以模拟多模态功能的方法构建的。但这样操作的结果是,这些模型有时在执行某些任务(如描述图像)方面表现良好,但在处理需要更深层次概念理解和复杂推理的任务时,它们的表现往往不尽人意。

而谷歌将Gemini设计为原生多模态,区别于其他既有的多模态模型,它从一开始就针对不同模态进行了预训练,再通过使用额外的多模态数据进行微调,进一步提升了模型的有效性。这意味着Gemini一开始就能无缝理解和推理不同类型的信息,包括文本、代码、音频、图像和视频,远远优于现有的多模态模型。

这种原生的多模态训练方法使得Gemini在处理多种类型的数据和复杂任务时更为高效和精准,从而在多模态人工智能领域树立了新的标准。原生多模态能力意味着模型能够更自然、高效地处理和融合多种类型的数据,这在实现更复杂的AI应用方面具有重要意义。

人类在理解世界时自然地融合了视觉、听觉和语言等多种感官信息。一个具有本地多模态能力的AI模型在处理信息时也采用了类似的综合方式,这更接近于人类的理解和认知方式。

想要实现AGI(通用人工智能),就需要AI做到像人类一样从容地解决不同领域、不同模式的复杂任务,在这个过程中,除了基本的计算、推理等基础能力,相对应的文字、图像、视频等多模态能力也要跟上。

· AGI-0:基本的人工智能,能够在特定的领域和任务上表现出智能,如图像识别、语音识别、自然语言处理等,但不能跨领域和跨模态地进行学习和推理,也不能与人类和其他AI进行有效和自然的沟通和协作,也不能感知和表达情感和价值。

· AGI-1:初级的通用人工智能,能够在多个领域和任务上表现出智能,如问答、摘要、翻译、对话等,能够跨领域和跨模态地进行学习和推理,可以与人类和其他AI进行基本的沟通和协作,能够感知和表达简单的情感和价值。

Gemini的演示视频,充分展现了它对各个模态交互的深刻理解,能看、能说、能推理、能够感知和表达简单的情感和价值,也让我们看到了AGI-1的潜在可能性。

经过训练,Gemini可以同时识别和理解文本、图像、音频等,因此它能更好地理解微妙的信息,并能回答涉及复杂主题的问题,比如进行数学和物理等复杂学科的推理。

而在编码方面,Gemini能够理解、解释和生成世界上最流行的编程语言(如Python、Java、C++和Go)的高质量代码。两年前,谷歌曾推出AI代码生成平台AlphaCode,现在在Gemini的助力下,该平台迭代到AlphaCode 2,性能也得到大幅提升,可以解决之前几乎两倍数量的问题。

Gemini的训练是基于谷歌自己的张量处理单元(TPUs)v4和v5e,比谷歌之前的模型运行速度更快、成本更低。值得关注的是,随着Gemini的问世,谷歌还宣布了TPU系统的最强升级Cloud TPU v5p,专为训练尖端AI模型而设计;在训练优化方面,Gemini还使用了Jax和Pathways编程模型,为复杂的数学运算(如在机器学习中常见的运算)提供了优化的支持,增加了对模型并行性和数据并行性的利用,并对网络延迟和带宽进行了优化。

通过使用这些工具,Gemini模型的开发者可以使用单个Python进程来协调整个训练过程,这样可以简化开发和训练工作流,同时利用Jax和Pathways的高效性能。

GPT-4的“双子”星?

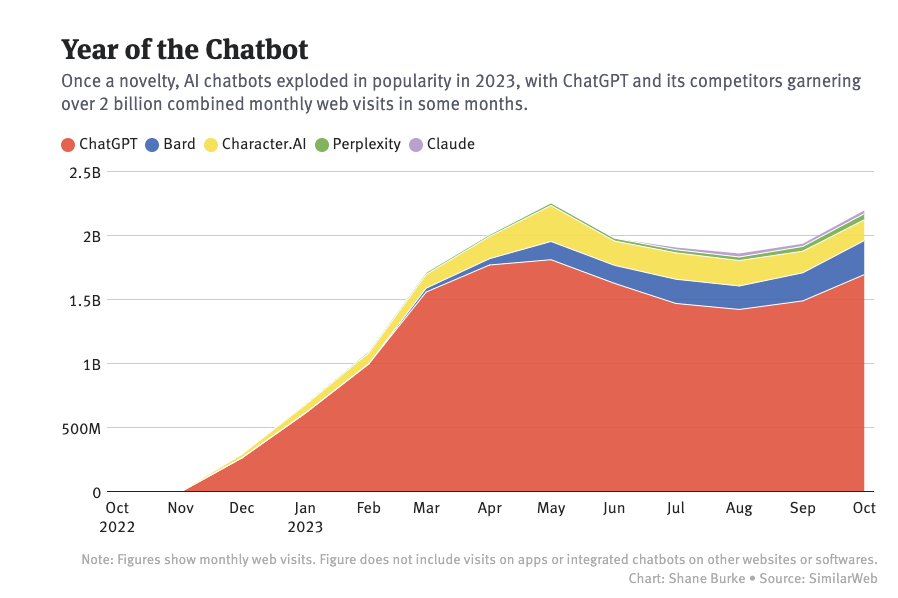

在过去的一年里,大模型的聊天机器人单月访问量已经增长到超过20亿:ChatGPT的月用户数从5月开始有所下降,10月出现回升重新达到17亿,对比谷歌Bard的用户数仅为2.6亿;Bard虽然排名第二,但和几个竞品一起归为“其他”更为合适。

随着推出了ChatGPT,尤其是在必应搜索中整合了GPT技术,并首次在应用程序下载量上超越了谷歌后,人们开始思考谷歌是否在已人工智能领域落后于竞争对手。此次谷歌发布Gemini早已被寄予了打破ChatGPT统治的厚望,那么Gemini能否代表着谷歌已经迎头赶上了呢?或者说,如今的谷歌能否重新站在人工智能行业的最高点呢?

通过ChatGPT获得了大量训练数据反馈,短期内OpenAI仍占有先机,但长期来看谷歌也依然有着自己的优势 —— 具备的海量用户和产品生态将会成为强大势能。相比OpenAI,谷歌积累了海量的PC和手机端用户,拥有海量实时数据(而OpenAI的数据依赖互联网,包括谷歌),并通过在用户手机集成GPT提供如地铁导航方面而拥有大量用户信息。

虽然谷歌此次发布的Gemini虽然在很多性能上超越了GPT-4,但是它与OpenAI仍存在时间差,GPT-4发布已经半年多,新一代模型应该也在开发过程中。所以对谷歌而言,与GPT-4进行各种基准测试的比较,只是展现其现阶段能力的一方面,能否依靠自身积累以及强大的资源,缩短与OpenAI的时间差才是关键。

据CNBC报道,在Gemini正式发布前曾多次推迟发布日期,内部对Gemini的提前发布意见不一,如今因为过大的市场压力突然决定发布。未来还需要解决在非英语查询等任务上的困难,盈利策略也还没有确定,商业化路线不清晰。即使Gemini宣传效果惊人,但作为谷歌在大模型时代构建的全新基础设施,比起测试数据,实际应用效果有待验证:能否满足日常用户以及企业客户,才是检验Gemini能力的真正标准。目前谷歌已经开始在搜索中试验Gemini,它使用户的搜索生成体验变得更快(目前只有英语版本,其他语言版本将在未来陆续推出),延迟减少了40%,同时在质量方面也有所提升。

Gemini的发布无疑是AI界又一个里程碑,这意味着AI大模型浪潮进入到一个全新阶段。比起大语言模型,多模态模型的运作模式,才是人类最自然的和世界交互的方式:用眼睛看到东西,用耳朵听到声音,再把这个东西的语义用声音/文字输出,再做出决策。

值得注意的是,视频内容已经是信息时代的主流,据思科的年度互联网报告显示,视频已经占据互联网超过80%的流量。Gemini只是掀起了多模态领域的一角,比起大语言模型,多模态模型增加了音频、视频、图片这些数据,而且这些数据的训练还远未到头,意味着大模型的天花板上限还很高。如果AI领域的尺度定律(Scaling law)一直奏效,随着训练规模不断扩大,我们还有许多可以期待的能力涌现。

Gemini的发布,必然会对其他AI大模型的迭代升级带来新的催化。对产业而言,多模态料将带动算力需求的提升,同时为后续GPT-5等模型的发布将带来更多催化。除了在一样闭源路线上的谷歌,还能有谁可以超越OpenAI?走不同开源路线Meta旗下的Llama可能也有机会。

Meta对AI的投资主要集中在三个方面。一是基础设施:Meta耗费巨资,在全球范围内建立昂贵的数据中心;二是开源大模型Llama 2:作为AI社区中最强大的开源大模型,Llama 2包括7B、13B、70B三个版本;三是Meta AI:作为一款打通Meta旗下各平台的AI助手,Meta AI可支持一对一、群聊,上线文生图功能,甚至可用于AR眼镜。

7月,Meta发布Llama 2开源大模型,以“开源”“开放”的名义发起反击;12月,Meta又高调升级Meta AI助手,为Facebook、Instagram等平台注入AI动力。面对激烈的竞争,Meta寄希望于升级已有平台,将Meta AI打造成全球应用最广泛的AI助手。

强大的平台,一方面为Meta的大模型训练提供了丰富的语料,另一方面也为Meta AI的普及准备了大量的用户。除此之外,AI的核心专利方面,Meta可以、谷歌并驾齐驱,广泛应用的深度学习框架PyTorch便诞生于Meta团队。

相关文章

技术咨询

技术咨询 代买器件

代买器件 商务客服

商务客服 研发客服

研发客服